Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

Loading...

警告

除已校对部分外,本项目目前翻译错漏百出,不适合用于生产。

本项目目前处于低维护状态,主要维护者因精力所限仅处理 PR 或新的期刊。欢迎社区通过 PR 贡献力量。

FreeBSD 期刊原文位于:https://freebsdfoundation.org/our-work/journal

基金会书信、读者来信、日历等均不译。

本书部署网站:https://book.bsdcn.org

使用由 提供的脚本:

用于导出本书的 PDF 文档。该脚本使用 Python 3 编写,仅在 Windows 10、FreeBSD 14 上测试过。

具体使用方法见该项目的 README。

或参见 Github 的 Release。

2024.7.9 机器翻译 2024-0506、2024-0102、2024-0304、2023-1112。校对《悼念 Mike Karels》

2024.7.29 校对《基本系统中的 mfsBSD》

2024.7.30 校对《rdist》

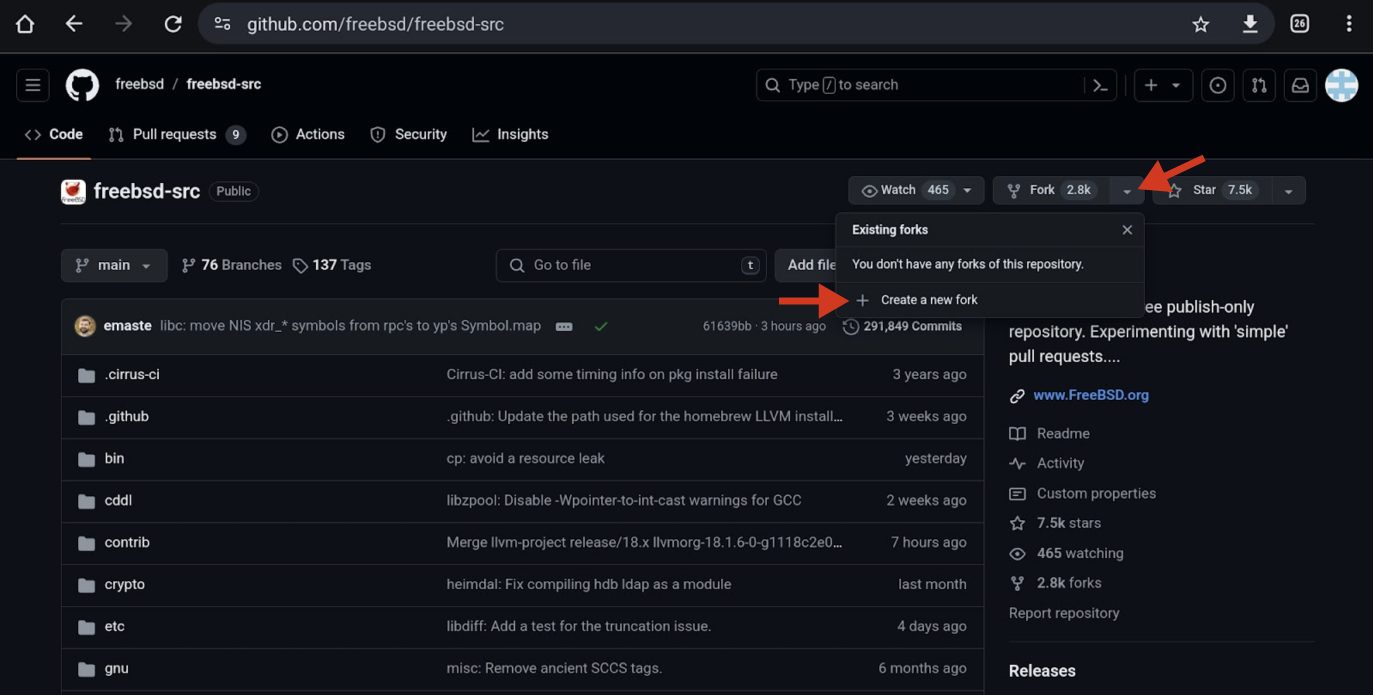

2024.8.12 校对《Hashicorp Vault》、《在 GitHub 上向 FreeBSD 提交 PR》

2024.8.14 校对《2024 年 5-6 月来信》

2024.8.15 校对《嵌入式 FreeBSD 面包板》

2024.8.16 校对《提升 Git 使用体验》、重命名为“期刊”,杂志不符合原意。

2024.11.10

校对《新的 Port 提交者:oel Bodenmann ([email protected])》

重新机器翻译 2024-0708、2024-0506、2024-0102、2024-0304、2023-1112

校对《现在用 Webhook 触发我》

2024.11.14

校对《FreeBSD 与 KDE 持续集成(CI)》

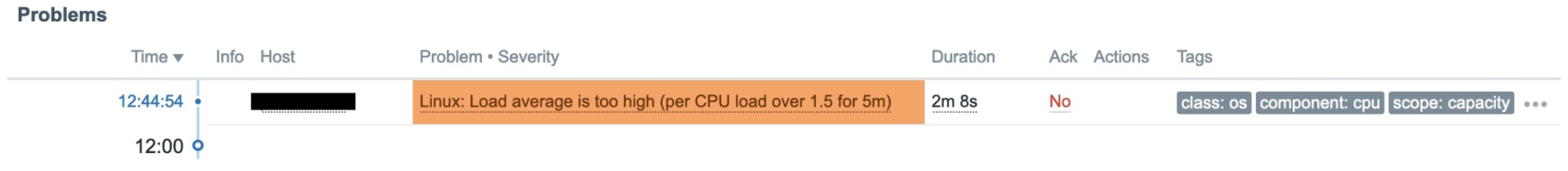

校对《实用软件:使用 Zabbix 监控主机》

校对《BATMAN:更优的可移动热点网络方式》

2024.11.15

校对《TCP LRO 简介》

校对《TCP/IP 历险记:TCP BBLog》

校对《FreeBSD 中的 RACK 栈和替代 TCP 栈》

2024.11.16 校对《实用软件:开发定制 Ansible 模块》

校对《FreeBSD 内核开发工作流程》

校对《更现代的内核调试工具》

校对《配置自己的 VPN——内置 FreeBSD、Wireguard、IPv6 和广告拦截(基于 FreeBSD)》

校对《SR-IOV 已成为 FreeBSD 的重要功能》

校对《FreeBSD iSCSI 入门》

校对《FreeBSD 中的 NVMe-oF》

校对《使用 ZFS 原生加密保护数据》

校对《嵌入式 FreeBSD:打造自己的镜像》

校对《基于 Samba 的时间机器备份》

校对《从零开始的 ZFS 镜像及 makefs -t zfs》

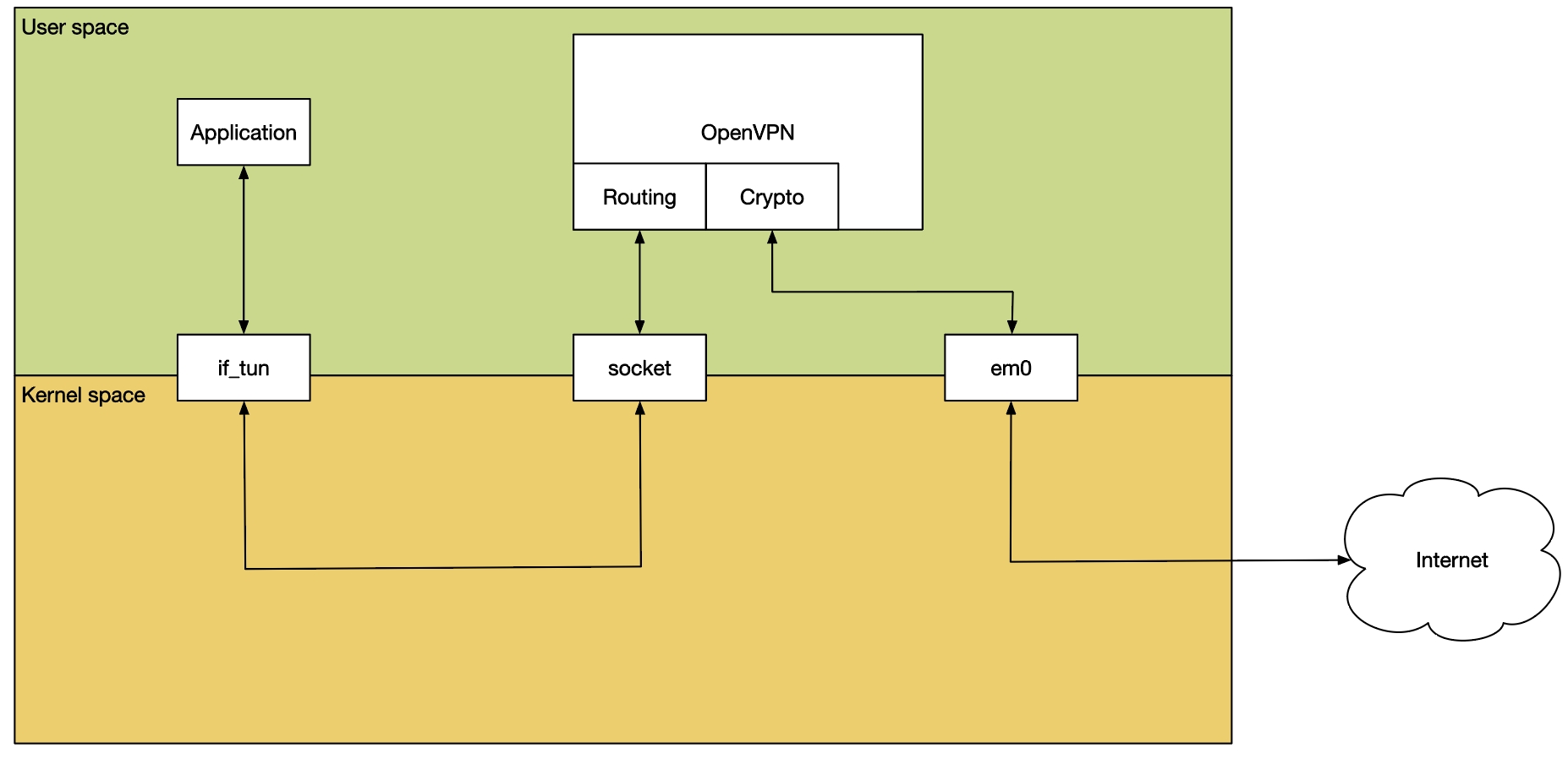

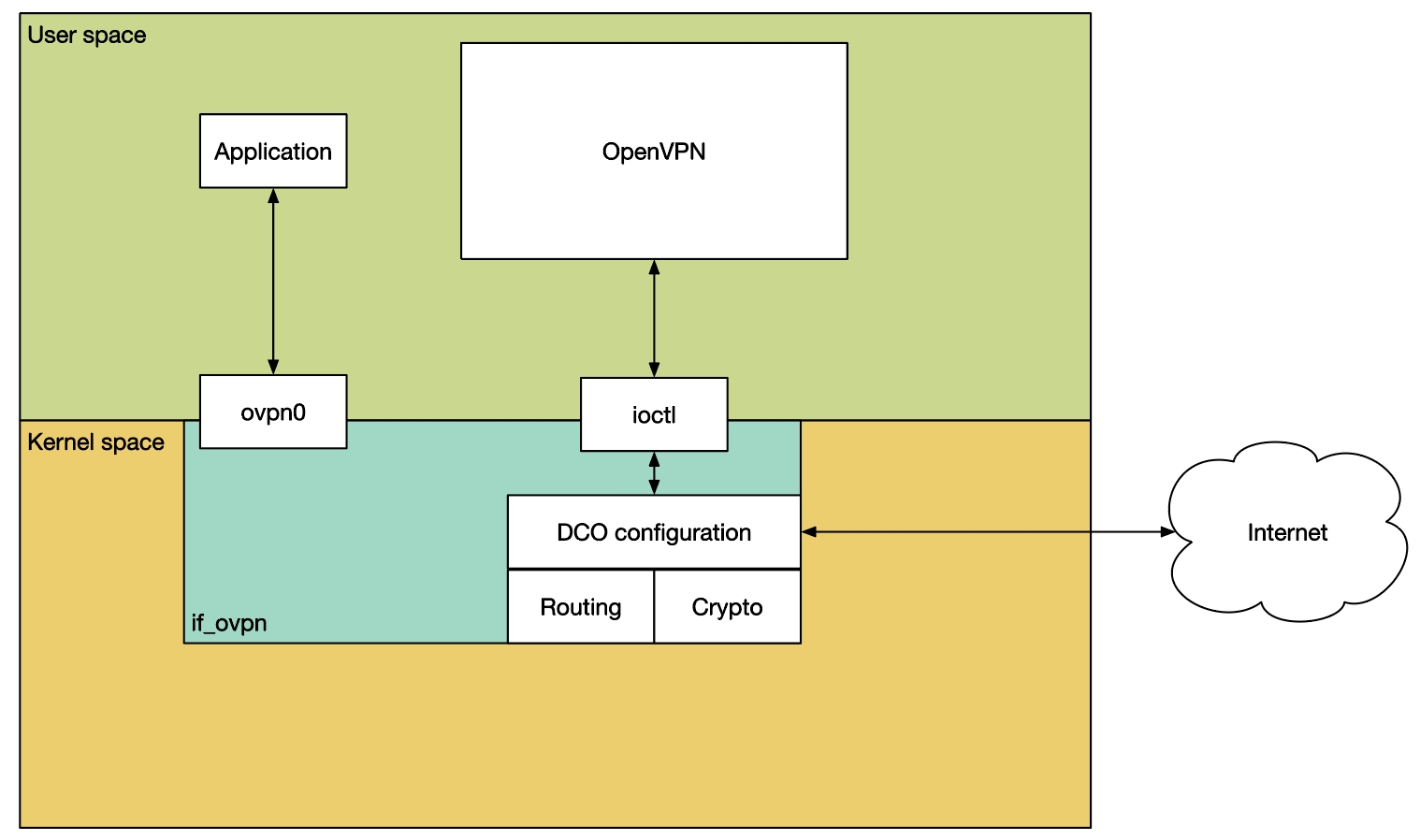

校对《if_ovpn 还是 OpenVPN》

作者:Alice Sowerby

我参加了 2024 年秋季在 NetApp 圣何塞校园(Santana Row)举办的 FreeBSD 峰会。此次活动让我有机会与 FreeBSD 社区建立联系、交流思想,并讨论正在进行的项目。我的主要目标是通过演讲以及非正式的交流,强调直接资助项目在 FreeBSD 基金会工作中的作用。

面对面交流让我深刻体会到亲自参与的重要价值。我与许多人进行了富有成效的讨论,探讨了基金会资助项目的影响,同时也看到了大家对 FreeBSD 在笔记本电脑使用方面的兴趣,这也是我演讲的核心内容。

在活动期间,我遇到了几位有趣的人,他们分享了自己使用 FreeBSD 的经历以及对该系统的抱负。同一行程中,我也有幸见到了 Framework 团队,这让我更好地了解了基金会笔记本电脑项目的背景。

我于 11 月 8 日(星期五)进行了演讲,Learning as We Grow: Managing FreeBSD Infrastructure and Laptop Projects at The FreeBSD Foundation(边成长边学习:FreeBSD 基金会的基础设施与笔记本项目管理)。听众提出了很多深思熟虑的问题,我也非常感激有机会分享我们如何构建和资助这些项目的见解。

让我印象特别深刻的是 Marshall McKusick 的演讲 The History of the BSD Daemon,它为我们提供了有关 BSD 历史的有趣见解。他还带来了既往 BSD 会议的 T 恤,并将其赠送给与会者,这一温馨的举动令所有人感动。

Santana Row 为此次峰会提供了一个充满活力且便利的环境。NetApp 大楼宽敞而友好,使得与人会面和进行有意义的讨论变得十分容易。活动组织得井然有序,这种环境也促进了富有成效的交流。

自参加峰会以来,我已经感受到了由此建立的联系和讨论带来的益处。这些讨论和获得的见解帮助塑造了正在进行的项目,并强化了以社区为驱动的发展努力的重要性。

参加 2024 年秋季的 FreeBSD 峰会让我有机会与 FreeBSD 社区互动、分享知识并加深合作。此次活动突显了 FreeBSD 基金会投资的价值,并为讨论 FreeBSD 的未来提供了极好的平台。我期待着继续这些交流,并在峰会带来的势头上进一步发展。

Alice Sowerby 在打造团队和培养科技领域领导者方面拥有丰富的经验。

我们对 Mike Karels 的离世深感悲痛,他是 BSD UNIX 历史上的一个重要人物,更是在 FreeBSD 社区中备受尊重的成员,同时也是 FreeBSD 项目的副发布工程师。Mike 在 BSD 系统开发和发展方面做出了卓越贡献,并在 FreeBSD 项目留下了不可磨灭的印记。

Mike 的愿景和奉献精神对塑造我们今天所知道并使用的 FreeBSD 起到了关键作用。他的精神将永远激励和指导我们在未来继续努力。

我们向 Mike 的家人、朋友和所有认识他的人表示慰问。我们将深切怀念他。

请参阅其亲属准备的待办事项,了解他不可思议的一生。

无需送花,Mike 的亲属更倾向于将其捐给基金会,以资助日后的 FreeBSD 项目。

原文:

作者:Christos Margiolis

今年,我在 上做了一场题为 的演讲。

我于 6 月 9 日抵达蒙特利尔,比会议早两天,不过当天没做什么,主要是休息。

第二天 6 月 10 日,我乘巴士从蒙特利尔前往渥太华(会议举办地)。一下车就偶遇了 Olivier Certner(olce@),我们一起在渥太华大学附近餐厅吃了午饭——会议和演讲者住宿都在这里——之后办理入住。晚上,我和 Mateusz Piotrowski(0mp@)、Bojan Novković(bnovkov@)、Kyle Evans(kevans@)在 Father & Sons 餐厅喝酒聚餐。在这个常见的聚会点,我们还遇到了会议的其他人。

作者:Tom Jones

TJ: 你能简单介绍一下你自己以及你与 FreeBSD 的背景吗?

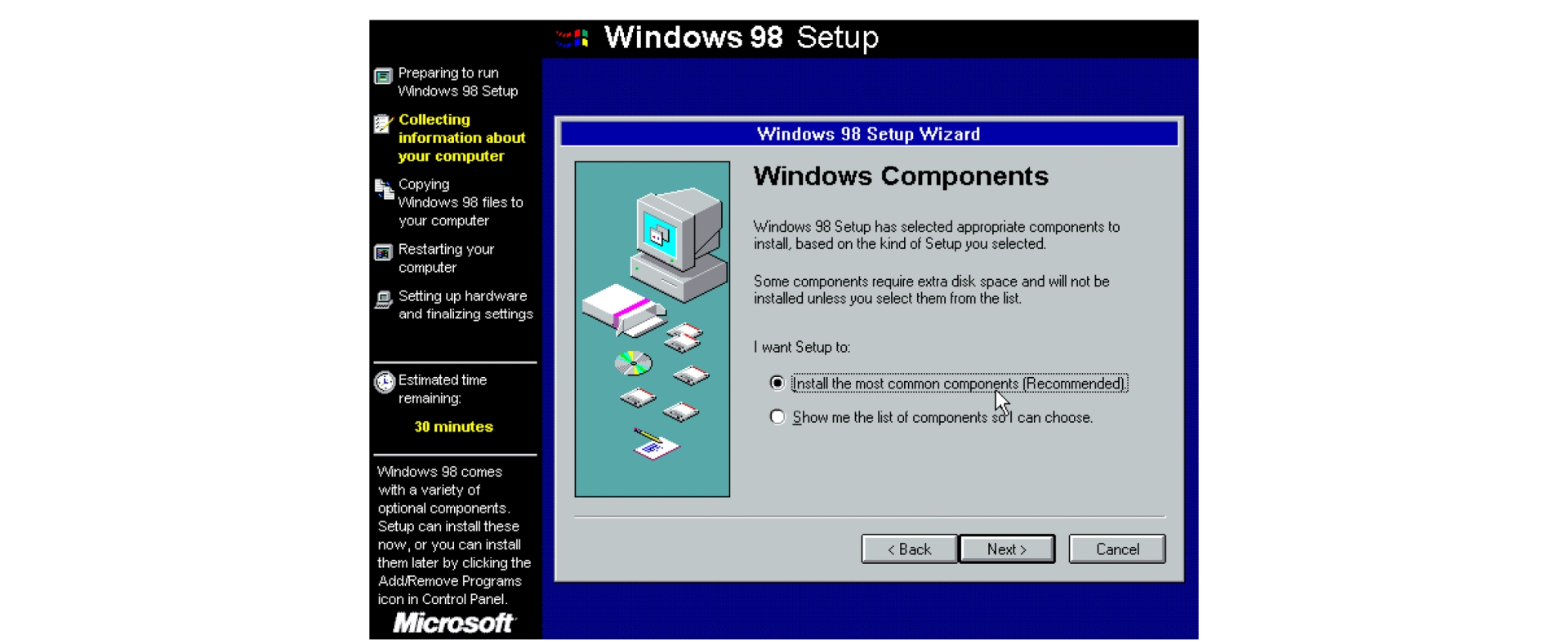

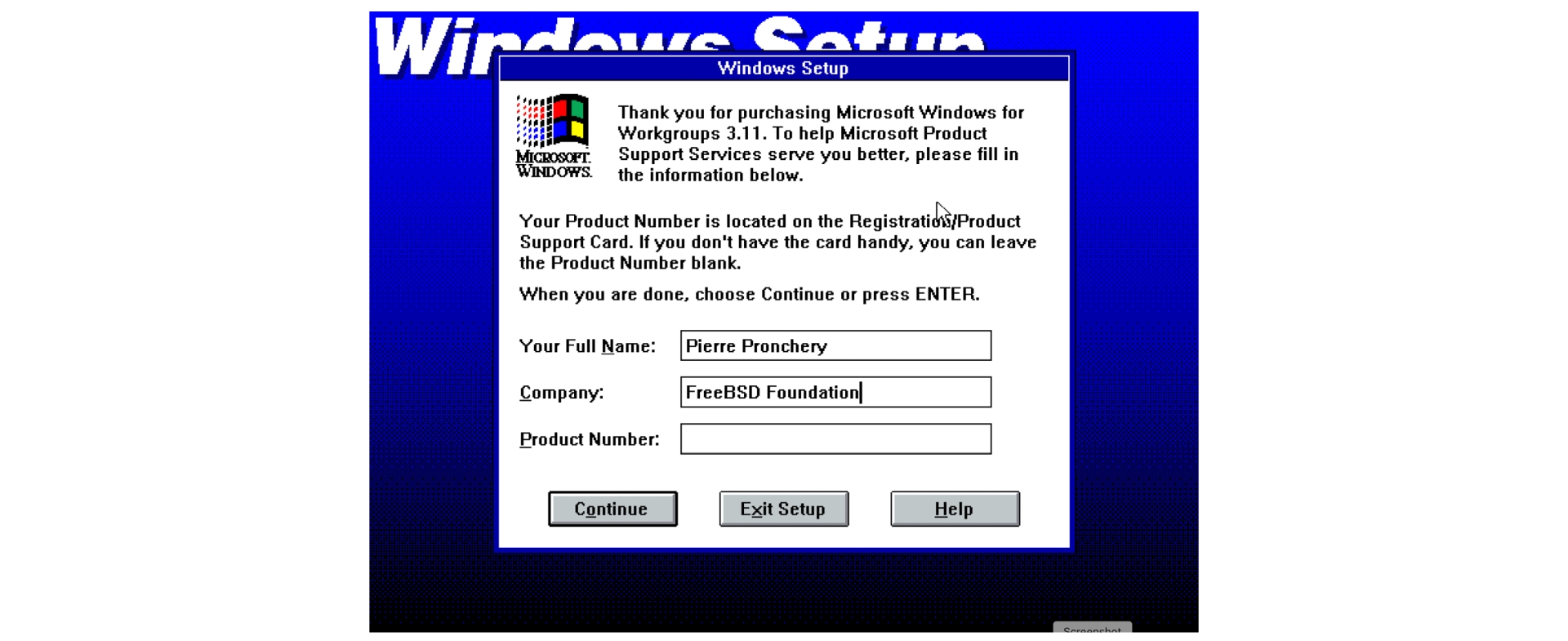

KS: 我叫 Kajetan Staszkiewicz。 1984 年出生于波兰神奇的城市克拉科夫。大约在 8 岁,我在计算机俱乐部接触了 ZX Spectrum 和 Atari 65XE 等 8 位机器。后来父母给我买了一台 Commodore 64。我对这台机器记忆犹新,直到现在我的桌上还摆着一台能正常工作的机器。

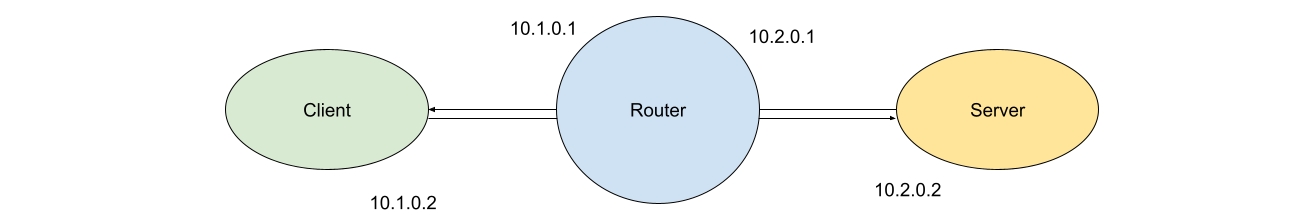

1996 年,我们家买了第一台 PC 克隆机(注:IBM PC 兼容机),不久波兰家用用户就能通过拨号连入互联网。但这种方式可持续时间不长。大约 1999 年,我和邻居们决定搭建邻里网络(注:小区或街道搭建的局域网)。大约 15 个人通过悬挂在屋顶到阳台的 10 Mb/s 以太网线共享一家网吧的 115 kb/s 连接。

网络共享由一台运行 IPchains(注:一款网络数据包过滤与地址转换工具) 的 Linux 机器来完成,最初由网吧的系统管理员提供,很快就被我们网络里年长的朋友搭建的另一套系统取代。后来我接手管理,用 Perl 写了几段 CGI 脚本,通过 Web 界面管理 DHCP 服务器和流量整形。

原文链接:

作者:Aymeric Wibo

在广阔的网络协议领域,有一种协议脱颖而出,作为一个多功能且自适应的竞争者:BATMAN,即 Better Approach to Mobile Ad-hoc Networks(随建即连网络优化方案)。在大城市的无线电波中,BATMAN 能让设备在网状网络中无缝通信,却无需让任何一台设备了解整个网络拓扑。

今夏,我参加了谷歌编程之夏 (GSoC),并将内核模块 batman-adv(提供了 Linux 对 BATMAN 协议的支持)移植到了 FreeBSD。谷歌编程之夏是个学生在暑期参与开源项目的计划,谷歌为学生提供津贴,并由导师监督。对我而言,我的导师是那位唯一无二的 Mahdi(或 Mehdi,取决于你问他是星期几)Mokhtari,即 mmokhi@。他是位非常有风度的人,我非常感激在谷歌编程之夏的旅程中有他的指导!

现在,使用 batman_adv(FreeBSD 上等同于 batman-adv

Junos 非常庞大。同步 FreeBSD 是一项艰巨的任务。为简化这个过程,Juniper 将 FreeBSD 组件拆分成了独立的仓库,将瞻博的增强功能保留在独立的仓库中。这就带来了一个难题——我们如何在 FreeBSD 中保留驱动程序,而将网络栈放在其他地方?作为分拆 FreeBSD 项目的一部分,提出了原始的 DrvAPI。通过这个 API,驱动程序可以存在于 FreeBSD 仓库中,同时把 Junos 网络栈保持为独立部分。

但什么是网络栈?我们在哪里划定网络栈与其他部分的界限?最初的方法是“sys/ 目录下所有以 net 开头的目录”,这种方法有效。然而,最近添加了组件 netlink ,从概念上来说,它并不属于网络栈的一部分,所以这一方法被抛弃了。现在,网络栈有 net、net80211、netgraph、netinet、netinet6 和 netpfil。保持网络栈的细节只关乎网络栈本身,也让核心内核的细节得以遮蔽。某些内核的其他部分也需要做出调整,以适应 IfAPI,包括 NFS 无根(boot)和 mbuf 处理。

当前 IfAPI 的设计主要是访问器和迭代器。这种方法被认为是将驱动程序转化并遮蔽 struct ifnet 的最便捷方式,尽管它并非最理想的方式。转化过程大多是自动化的,Juniper 提供了一个 shell 脚本 tools/ifnet/convert_ifapi.sh 来解决大部分转化。显然,这可能会漏掉一些转化,例如当 ifp 是另一个结构体的成员,或者其名称是其他形式(如 foo_ifp)时,但它能处理大多数情况。

至于迭代器,最初的实现基于 Gleb Smirnoff 的 if_foreach_lladdr(),在迭代给定类型时使用回调函数。这被应用于 if_addr 和 if_t,在迭代接口时只会遍历当前的 VNET。最近,增加了一种新的迭代器 API,能使用更传统的循环进行迭代;要求是你必须调用 if_iter_finish()/ifa_iter_finish() 来清理迭代所设置的任何状态,包括释放实现可能分配的任何内存(FreeBSD 网络栈未做此处理,但其他栈可以做到)。

将设备驱动程序与网络栈细节解耦,不仅对瞻博的源代码管理有益,还带来了一些额外的好处。通过稳定的 ABI,单个设备驱动程序能与多个不同的网络栈一起使用。例如,在数据中心的所有计算机上,在启动时,某款镜像能选择不同的网络栈,依据执行配置选择一款高性能的有限网络栈用于某些设备,而为其他设备使用完整的网络栈,所有设备仍使用相同的网络驱动程序。

另一个较小的好处是,驱动程序更改和网络栈更改可以同时发生,而不会互相干涉。在 IfAPI 出现之前,对 struct ifnet 的任何更改都需要重新构建所有设备驱动程序。现在,由于 struct ifnet 是完全私有的,任何对该结构的更改只需要重新构建那些直接引用它的文件,从而缩短了调试周期。

IfAPI 只是第一步,仍然有很多工作要做,以便真正地抽象化网络栈。Gleb Smirnoff 提出了使用 KOBJ 接口来允许一个更加可插拔的网络栈,并完全解耦网络栈与其他部分。这甚至可以允许在运行时替换网络栈(kldunload/kldload)。进一步来说,我们甚至可以允许多个网络栈,并将不同的设备分配到不同的网络栈中。如此一来,甚至可能实现动态地在网络栈之间移动接口。

IfAPI 只是解耦网络驱动程序与网络栈内部实现之间关系的第一阶段。随着进一步的工作,多个网络栈可以同时使用——甚至是可重新加载的网络栈。

Justin Hibbits 于 2011 年因其对 PowerPC 的执着被愚蠢地授予了 FreeBSD 提交权限。从那时起,他专注于 PowerPC 和其他嵌入式架构的工作。目前他在瞻博 Networks 工作,负责所有与 FreeBSD 内核相关的事务,并继续他对底层开发和异构架构的热情。

我的下一份工作是在一家大多数服务都使用 FreeBSD 的公司,甚至有员工大胆地在工作站上运行 FreeBSD。

目前我居住在德国汉堡。在现在的工作中, FreeBSD 是我们路由器和负载均衡器的首选系统。

TJ: 你是如何开始提交第一个 FreeBSD 贡献的?当时你如何选择起步的项目?

KS: 选择很简单:修复那些出问题的部分。在 $WORK,我们依赖 pf(4) 的源跟踪,期间发现一个棘手的 Bug:删除源节点时,每个源节点会扫描所有状态。数百个源节点与数十万条状态会导致内核代码出现大量循环,系统因此被锁死。

在 glebius@ 的帮助下,我成功修复了该问题,并提交了我的第一个补丁到 FreeBSD。

TJ: 你是如何定位这个问题的?FreeBSD 中是否有现成的工具可以帮助,还是你需要自行开发?

KS: 当时我已经大致知道问题出在哪,因为它是由我们用于负载均衡的自定义工具引发的。

那时我对 FreeBSD 尤其是内核开发经验尚浅,所以采用了最原始的暴力调试法:不断在代码里加 printf,直到找到卡住的位置。

不过系统自带了构建自定义内核所需的所有工具,这点对我帮助很大。

此外,还能按需生成内存转储,再用调试器分析,也非常方便。

TJ: 在这个过程中你一定学到了很多。有没有什么技巧能让新开发者的调试和开发更轻松?

KS: 不只是知识,额外的工具和工作流也很关键。

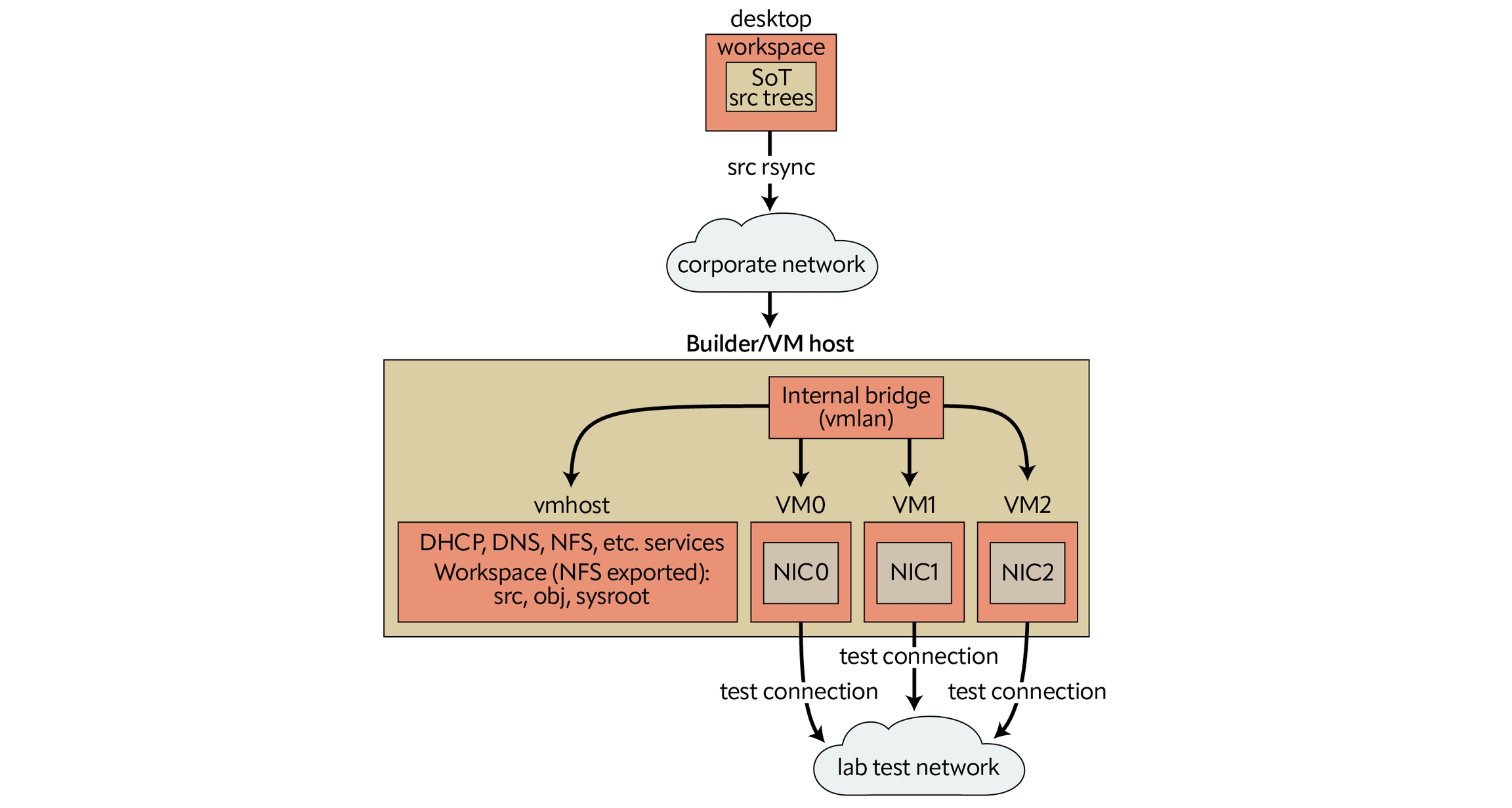

第一是要有完善的开发和测试环境。在 $WORK,我们只在裸机上跑 FreeBSD,最初的补丁必须部署到这些“真”服务器上——它们启动要花几分钟 POST,并且承载着真实的生产流量,影响客户体验。

在那种环境下测试补丁又紧张又慢。现在我有三层系统:

可以在几秒内重启新内核的虚拟机;

承载少量流量、即便挂了也不影响客户的测试机;

承载更多流量、但仍不影响付费客户的预演机。

第二是 FreeBSD 的测试套件,真的能救命!我能在几分钟内(支持并行)跑完所有测试,确保没破坏现有功能。虽然偶尔会发现有些功能还没对应的测试,但我们正在逐步完善。

最后是在编译内核时启用各种调试选项——可以监测锁顺序、变量断言,甚至捕获内核中的非法内存访问。FreeBSD 开发者手册对这些选项都有详细说明。

TJ: 对新贡献者有什么建议或其他想补充的吗?

KS: 开源项目(包括 FreeBSD)依赖贡献者。FreeBSD 已经很成熟,虽然代码复杂,但总有贡献的空间——从小而简单的改动开始也完全没问题。社区友好又乐于助人,会在代码审查中给出建设性反馈,别被吓到!

希望大家的贡献既能带来新功能,也能让新手学习新技能、职业成长,甚至享受与计算机打交道的乐趣。

Tom Jones 是一位致力于保持高效网络栈的 FreeBSD 提交者。

Kajetan Staszkiewicz 是专注于网络和虚拟化的系统管理员,偶尔为 FreeBSD 的 pf(4) 做出贡献。

struct net_devicestruct ifnetmbufsk_buff虽然我远不是内核组件移植方面的专家(这是我首次移植像 BATMAN 这样的大型项目),但下面是我对这个过程的一个高层次概述——希望从我的小冒险中可以获得一些洞见。

第一步——自然而然——是将 Linux 上的 batman-adv 代码拉入 sys/contrib/dev/batman_adv,再创建一个 Makefile 来构建它,Makefile 中列出了所有源文件,设置了编译参数,例如告诉它包含 LinuxKPI 的内容。正如预期的那样,初次尝试并未成功;batman-adv 调用了很多函数,使用了许多仅在 Linux 内核上下文中存在/才有意义的结构体。这正是 LinuxKPI 存在的原因;它提供了兼容层,通过调用 FreeBSD 内核中等效(或者有时并不完全等效)的函数来实现 Linux 内核的子集。

因此,下一步自然就是通过为 LinuxKPI 中所有缺失的函数和结构体编写存根(stub)来使其能够编译,弥补缺失的字段(我们不能直接复制 Linux 中的结构体,因为 Linux 采用 GPL 许可证)。这些存根仅包含调试打印语句,以便我们知道它们何时被调用。

在所有编译通过后,我可以加载内核模块,但这随即引发了内核崩溃。接下来的过程就是逐一检查所有调用的存根,查找并理解它们在 Linux 中的实现,并在 LinuxKPI 中实现一个等效的版本,直到内核不再崩溃为止。这大概占了工作量的 70%。

在每个操作(加载模块、创建接口、发送数据等)都能正常工作且不再崩溃后,就该拉上窗帘,在第二台显示器上打开 Wireshark,锁在我的 kot(= = 比利时宿舍的房间)里一周,确保 1) 所有设备在网状网络中能够互相识别,2) 数据能够从设备 A 通过设备 B 正常传输到设备 C,不会在过程中丢失和被破坏。大部分时间花在了重新审视之前步骤中(有时不充分的)实现上。这可能占了 30% 的工作量,但感觉像是 90%。大部分时间我都在凝视着 Wireshark,Wireshark 也在凝视着我。

最后,BATMAN 在 FreeBSD 上工作了,剩下的就是让用户态工具支持操作 BATMAN 接口,写几行文档,然后拉开窗帘。

去年在 EuroBSDCon 上,我与核心团队的一些成员讨论了将 batman_adv 合并到上游的可能性,他们表示不大愿意这样做,因为 BATMAN 是 GPL 许可证的。所以它可能会永远作为一款 port 存在,因为 BATMAN 在 FreeBSD 系统中并非必需;如果你需要使用 BATMAN 来做某些事情,你很可能已处于一个可以轻松自行获取、构建 port 的环境中(与网卡驱动程序等情况不同)。

目前 BATMAN 在 FreeBSD 上的最大限制是,它不能加入无线网络。我完全打算在接下来的一年内让无线网络也能够正常工作,因为那才是 BATMAN 的主要使用场景。希望能在 BSDCan 2024 之前完成这项工作 ??

我强烈建议所有符合申请条件的人参加谷歌编程之夏。我从一开始对 FreeBSD 的网络栈和内核了解不多,到现在,在大局上仍然了解不多,但肯定比我刚开始时知道的要多得多。它尤其帮助我更加自如地在源代码树中浏览,调试内核崩溃,即使这些崩溃与网络代码无关。

这是我的谷歌编程之夏项目 Wiki 页面,包含了所有的具体内容、代码和一个小的演示视频:https://wiki.freebsd.org/SummerOfCode2023Projects/CallingTheBatmanFreeNetworksOnFreeBSD

此外,你可能会对这个链接感兴趣,它详细介绍了 BATMAN 在 Linux 上的实现(因此也包括在 FreeBSD 上的实现):https://www.open-mesh.org/projects/batman-adv/wiki/Wiki

Aymeric Wibo 是比利时法语鲁汶大学的计算机科学学生,自高中起就一直使用 FreeBSD,开发基于 FreeBSD 的项目。他的主要兴趣在于图形学和网络。

第一天的亮点是核心团队发起的关于 FreeBSD 项目中 AI 使用 的公开讨论,休息时间也在继续。核心团队主要关注 AI 生成代码的许可问题。而我坚持认为应该 坚决反对 AI 的任何使用,主要基于伦理和质量方面的担忧。许可问题在我看来只是次要的。比如:我们是否要主动参与可能让世界变得更糟的事?如果放宽 AI 政策,会吸引什么样的人加入项目?这会怎样影响项目的长期质量?我们真的 需要 AI 及其带来的复杂性吗?如果没有许可问题,那用 AI 就没问题吗?还有很多类似的疑问。好在不少人(有些人犹豫着)支持了我的观点。

我还与 Mark Johnston(markj@)、Joseph Mingrone(jrm@)、Bojan 以及 Charlie Li(vishwin@)进行了技术和非技术讨论。意外的是,Charlie 也对 FreeBSD 音频/音乐制作感兴趣,还用它做 DJ 表演。

DevSummit 第一天结束后,我们在大学宿舍里吃了披萨,但我比较早回房间继续准备幻灯片。

第二天 6 月 12 日的日程以 AlphaOmega 的安全审计演讲开始,接着是关于 FreeBSD 15.0 技术规划 的讨论,包括 PkgBase。午饭后,Brooks Davis(brooks@)带来了一场极其精彩的演讲——大概是整个 DevSummit 我最喜欢的技术讲座——主题是 CheriBSD 分支的上游合并。他不仅讲了上游过程,还详细介绍了 CHERI、CheriBSD 及能力机制,并展示了其内建的内存安全特性能如何捕捉 FreeBSD 代码中的各种 bug。随后,FreeBSD 基金会 汇报了近期工作和资金使用情况,包括我参与的 Laptop Support and Usability Project。在会议尾声,我和 Alexander Ziaee(ziaee@)花时间调试了他笔记本的声音问题。晚上,我与 Benedict Reuschling(bcr@)等人去了一家不错的海鲜餐厅。

BSDCan 正式会议于 6 月 13–14 日举行。开幕主题演讲由著名计算机科学家 Margot Seltzer 主讲,题为 《Hardware Support for Memory-Hungry Applications》。

这两天我听了许多讲座,其中印象深刻的有:

ShengYi Hung:《ABI stability in FreeBSD》,展示了一个检测 CTF 数据差异的实验性工具,用于发现 ABI 变化。之后我们(包括我、Mark Johnston、John Baldwin、Warner Losh 和讲者本人)展开了关于工具局限性及如何在实际应用中的讨论。

Marshall Kirk McKusick:《A History of the BSD Daemon》,以及即将出版的《FreeBSD 操作系统设计与实现》(The Design and Implementation of the FreeBSD Operating System)第三版更新。我一向喜欢 Kirk 的演讲风格。

Bojan Novković:《Hardware-accelerated program tracing on FreeBSD》,介绍了他在 hwt(8) 框架上的最新工作。

Zhuo Ying Jiang Li:《Improvements to FreeBSD KASAN》,讲解了 FreeBSD 内核地址消毒器 (KASAN) 的改进工作,这是她参与 CheriBSD 的一部分。

我没能参加但本想听的讲座有:

我在 6 月 14 日,也就是 BSDCan 的最后一天做了演讲。引发了大量问题和交流,甚至在讲座结束后仍在继续。显然,比我预想的更多人希望能在 FreeBSD 上做音乐和音频制作,或用于大型音频系统,这场演讲似乎启发了他们,这是非常好的事情。

会议闭幕式后,我们去附近的市场广场参加社交活动。我大部分时间和 Mark Johnston、Andreas Kirchner、Mateusz Piotrowski 在一起,进行了很多有趣的对话。

第二天,我返回蒙特利尔,休息了几天才回家。

一如既往,会议是弥补编程孤独性的绝佳机会,让我们能见到每天通过邮件交流的幕后人。除了完成工作和交换技术想法,我更享受那些意外发生的、深入的交流,包括与此前未曾见过的人。

Christos Margiolis 是来自希腊的独立开发者和 FreeBSD src 提交者。

作者:Tom Jones

TJ: 通往 FreeBSD 开发之路的有很多因素,有些是通过大学课程,有些是通过工作经验。你是如何了解到这个项目的?最初又是什么吸引你走向操作系统开发的?

IO: 在上世纪九十年代,我在上学期间有机会接触到了几种编程语言和技术。比如,我花了很多时间鼓捣 TR-DOS,小心规划行号(这在我开始用 ipfw 时勾起了回忆),为自己设想的另一个游戏写 DATA 和 GOTO,还尝试过在 MS-DOS 下用中断向量开发常驻程序。因为有这些经历,极简的命令行界面对我来说并不陌生。后来我在大学学习计算机科学时初次接触到 FreeBSD,当时唯一的问题就是要买哪些书。

很明显,掌握 FreeBSD 会很有挑战,但也会非常值得,因为我必须一路补充基础知识。为什么是 FreeBSD?高年级同学推荐它,因为我们整个宿舍的网络都是基于 FreeBSD 搭建的。这是在千禧年初,还延续着上一个十年的惯性,当时 FreeBSD 是网络领域的事实标准。近年来,我更多专注在操作系统开发上。凭借广泛的软件开发背景,我积累了一系列想法,思考如何利用操作系统内部机制来支持更高层的解决方案。

TJ: 你最初是如何迈出修改 FreeBSD 的第一步的?最初又是怎么决定要做什么工作的?

IO: 第一步是准备。我希望能完善自己已有的 FreeBSD 知识,填补空白,形成更系统的认知。一本非常著名的参考书是 The Design and Implementation of the FreeBSD Operating System(《FreeBSD 操作系统设计与实现》),作者是 Marshall Kirk McKusick、George V. Neville-Neil 和 Robert N.M. Watson。

FreeBSD 源码对我来说并不完全陌生,多年来我已经对其结构有了整体印象。但我想要专业的指导,避免错过关键概念、风格细节或结构要点。幸运的是,有 McKusick 主讲的 FreeBSD 内核课程,它帮我节省了很多时间,解答了我的问题,并且在最佳的方式下提供了历史背景来回答“为什么”。另外,George Neville-Neil 的《FreeBSD Networking from the Bottom Up》(FreeBSD 网络体系结构自底向上)课程则进一步完善了我在网络栈方面的理解。

我考虑过先做大项目还是小项目,并和 mckusick@ 以及 kib@ 讨论过。Konstantin Belousov 建议我从小任务入手,比如修复 bug,这事实证明是最有效的方法。我最初处理的是一些最新报告的 pf 漏洞,这又衍生出对 jail 子系统的改进、对 Kyua 的 execenv=jail 测试工具的改进,甚至还开发了一个新的模块 dummymbuf 用于特定的网络测试。结果是,我继续和 Kristof Provost、Mark Johnston 以及其他 FreeBSD 开发者一起推动项目改进。

TJ: 修 bug 是新手进入一个项目的好办法。你对 2025 年的新 FreeBSD 贡献者有没有推荐的入门方向?

IO: 项目官网已经提供了正式的指导和具体方向,例如 。我更愿意提出一种替代思路:最好的路径往往是和个人兴趣一致的。

比如,如果有人对学习或使用 FreeBSD 的网络工具或内核模块(如 netstat、route、pf、ipfw、netgraph 等)感兴趣,那么阅读相关文档和手册页的同时,可能会发现可以通过补充示例、重写复杂概念或补充缺失部分来改进它们。如果 FreeBSD 里没有相应工具或模块,那么将有用的程序加入 Ports 或保持其更新,也是非常重要的参与方式。这类项目通常既有趣又有教育意义,因为可能需要更深入地理解 FreeBSD 内核接口。

如果目标是深入理解内核代码,也可以采用类似的方法——选择自己使用或计划使用的功能,能获得更多收益。比如防火墙:理解其规则在幕后是如何运作的,可以给高级用户带来优势;或者对路由机制进行研究,以解决特定问题。可能还需要在内核中实现缺失的功能或 RFC。偶尔也会有把其他平台的方案移植到 FreeBSD 的需求,例如正在进行中的 Netlink 实现,或是 VPP 框架的移植。这些都为进一步改进留下了空间。最终,和现有代码的工作总会揭示出优化机会——减少每单位数据传输或处理的资源消耗,这对所有依赖 FreeBSD 的企业都有利。

如果贡献不止一个小补丁,我建议两个起步步骤:做好功课并沟通。与 FreeBSD 开发者联系的方式很多(见 ),最基本的是邮件列表,例如 。先讨论潜在项目,可以达成方向上的共识,也可以发现是否有人已经在做。对于开源项目来说,准备工作越充分,沟通效果越好。

TJ: 开发过程往往令人望而生畏,还有很多死胡同。你能分享一些捷径,帮助新开发者更轻松地调试和开发吗?

IO: 我认为《FreeBSD 期刊》是一项非常棒的专业经验分享渠道。我建议浏览过往期刊的目录,寻找能填补知识空白或提供新视角的文章。比如,Mark Johnston 的《Kernel Development Recipes》(内核开发秘籍)和《DeBUGGING the FreeBSD Kernel》(调试 FreeBSD 内核),Navdeep Parhar 的《FreeBSD Kernel Development Workflow》(FreeBSD 内核开发工作流),以及你写的《More Modern Kernel Debugging Tools》(更现代的内核调试工具)。这些文章可以快速概览构建系统的功能和一些技巧(比如避免耗时的完整重建),以及如何利用虚拟化或第三方软件提升效率。

要养成项目推荐的良好实践,我建议阅读 Ed Maste 的《Writing Good FreeBSD Commit Messages》(撰写优质的 FreeBSD 提交信息)。迟早也该熟悉 John Baldwin 的《FreeBSD Code Review with git-arc》(使用 git-arc 进行 FreeBSD 代码审查),这个工具大大提升了补丁发布、审查、更新和合并的效率。

在内核网络方面,我建议仔细研究 FreeBSD 的 Jail 和 VNET 功能。如果工作不涉及特定硬件支持,那么基于 VNET 的 Jail 可以大大简化开发时测试新网络功能的过程。它们可以当作轻量级虚拟机网络来测试特定数据包路径或网络栈行为。这比其他方式更简单,即使同一个 mbuf 数据包缓冲在场景中扮演了所有角色,因为数据都不会离开主机。同时,这样的实验场景也可以成为开发新自动化测试的良好起点。Kristof Provost 的《The Automated Testing Framework》(自动化测试框架)文章和相关防火墙测试代码,以及他在 YouTube 上的演讲,都能提供灵感。

此外,投入时间来熟悉源码环境也很重要。内核是一种特殊的软件,它支持多种架构、编译器和特殊场景,预处理器的 ifdefs 并不足以解决所有问题,有些条件甚至是在代码之外解决的。另外,源码中包含一些自动生成的代码,比如系统调用或 VFS 操作的模板。因此,单靠 grep 或编辑器默认功能是不够的。我个人的配置是 Neovim + clangd + intercept-build,效果不错,但最好先了解有哪些可选方案。 介绍了如何利用 LSP 来简化代码理解和导航,这对新开发者来说至关重要。

TJ: 感谢你接受采访。最后你有没有给新贡献者的建议,或者想补充的内容?

IO: 也谢谢你。我的总体建议适用于任何有大量志愿者的国际开源项目:保持开放心态和一定的耐心。打个比方,在社区网络中有许多“主机”(贡献者),并不是随时都能通过任何协议访问。每个“主机”都可能忙于自己的工作,网络接口可能已经过载。因此,对我们的连接超时并不意味着严格的拒绝(RST),更可能是需要更多时间来处理我们的 SYN。像电子邮件这样的沟通方式能提供深度缓冲,通常“先到达的请求”可能最后才被考虑,所以礼貌的重发往往是实用的做法。还需要重新设定对延迟的预期,因为存在时区、优先级(工作优先于志愿贡献)或停机(周末、假期等)的问题。

这个网络已经运行了数十年,一些“主机”从早期就一直参与。他们的积累可以帮助我们应对新挑战,给出方向,或提醒我们避免一些尚未显现的问题。同时,新加入的“主机”也能带来新想法或新视角。每位贡献者都为拼图增添了独特的一块。因此,保持开放心态,努力理解别人信息背后的意图,对新贡献者建立更好的连接至关重要。

虽然不是必须的,但如果你能在“带宽”上做到对等(即也能接受外部连接),这将提升整个网络的容量并促进扩展。换句话说,要准备好在自己这边“打开一些端口”,接纳他人的输入。

Tom Jones 是一位 FreeBSD 提交者,专注于保持网络栈的高性能。

Igor Ostapenko 是 FreeBSD 和 OpenZFS 的贡献者,拥有广泛的软件开发经验,涉及导航设备测试系统、企业流程优化解决方案、逆向工程,以及 B2B/B2C 创业项目等多个领域。

采访者:TOM JONES

TJ: 你好,Joel,欢迎你加入 FreeBSD 项目。你能为我介绍一下你自己以及你喜欢从事的技术项目吗?

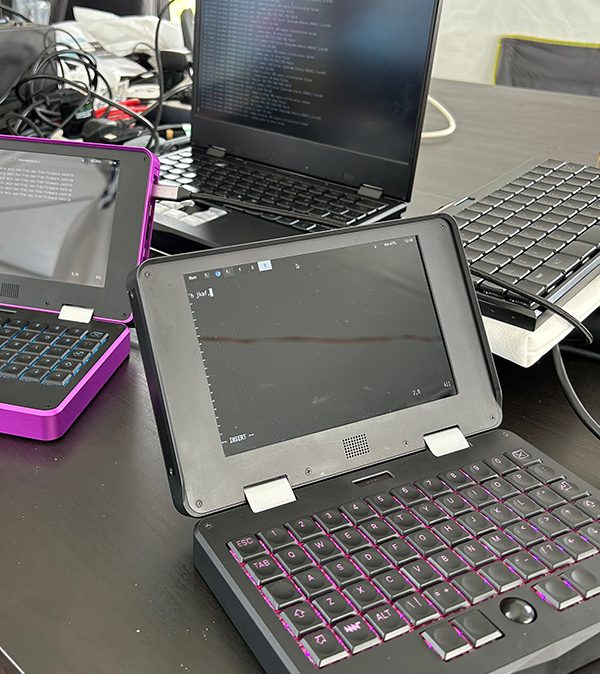

JBO: 我是一名电子工程师,主要从事嵌入式系统。通常,我喜欢处理被设计用来执行特定任务的系统,而非通用计算。

TJ: FreeBSD 并不以嵌入式系统开发著称,你尝试过在 FreeBSD 上进行工作和项目吗?

JBO: 我不敢苟同。我之所以选择 FreeBSD,正是为了将其用作嵌入式系统开发平台。虽然在过去几年,“嵌入式”世界发生了巨变,但我通常处理的嵌入式系统是资源相对较低、实时性强的系统(即基于微控制器的系统典型设备,CPU 速度 < 120MHz;RAM < 128kB)。因此,这些系统并非直接设计用于运行 FreeBSD;而且实际上,也不会运行什么 Linux(亦不符合要求)。

你仍然需要一台(桌面)主机系统进行实际的开发,以及周围的支持基础设施。我经常参与的上述嵌入式项目,从首次会议到部署产品可能要花几年的时间。我对作为开发平台的 Linux 一个不满是,Linux 生态系统始终处于不断动荡的状态。你在基于 Linux 的系统上配置的开发工作流程和环境,仅仅几个月后,就被迫更新,这就需要重新验证所有的工作流程。

FreeBSD 以其稳定性和连贯性而闻名。FreeBSD 不会因为旧的系统/组件“不够好”而回炉再造新的系统/组件,而是努力使这些系统和工具具有可维护性和可扩展性,从而大大减少了开发系统管理的开销。

对于某些项目,我的确需要一个非微控制器系统,微控制器系统与之通信(即长期数据记录,编排等)。在这种情况下,FreeBSD 具有等同的优势:你设置和验证系统一次。然后,在接下来的几年里,只需执行几次较小的维护任务,而对于基于 Linux 的系统来说,我从来不知道第二天会遇到什么情况。

粗略总结,基本上是,我喜欢把时间花在实际开发和工程上,而不是因为底层的 init 系统、音频子系统、虚拟化和最流行的容器系统(或类似系统)在两年内不断变更而一直在更新、调试和重新验证我的开发平台。这么说,FreeBSD 符合所有要求。自从我将所有服务器、网络基础设施和工作站迁到 FreeBSD 后,我从来没有怀疑过,在第二天进入办公室后,我的开发基础设施是否仍然可以正常启动和工作。FreeBSD 非常可靠。

TJ: 你是否已经在 ports 中有了特定的关注领域?

JBO: 到目前为止,我主要致力于处理“伸手就能解决的东西”,这样做的想法是让我熟悉 ports 系统的基础知识以及工作流程和基础设施。与此同时,这也释放了更有经验的 ports 提交者的资源,让他们可以将精力专注于更复杂的事务。

随着我熟悉程度的增加,我希望在接下来的一年里承担涉及很广的任务,比如更新拥有许多使用者的 ports 库。

因此,我对你的问题的回答是:不,我尽我所能地帮助。我毫不怀疑,随着经验的丰富,我很快就会找到一些更复杂的工作要做:🙂:

TJ: ports 非常庞大,许多小工具就可以完成繁重的工作。到目前为止,你做过的一些容易实现的 port 是什么?你有什么建议可以帮助其他人找到容易实现的 Port 和更容易的第一个 port 吗?

JBO: 就我个人而言,迄今为止,我认为有两种容易实现的目标情境:

PR,这些补丁已经获得维护者的批准,并将补丁更新到新的上游次要版本的 port。在这里,我建议刚开始时避开那些涉及大量用户的“基础”port,以减少触发大规模故障的风险。我的理由是简单的上游次要版本的升级几乎不会出错,并且维护者倾向于小心地避免破坏他们的 port,并且他们已经具有经验,知道要特别注意他们的上游相关事项。

引入新的 port 的 PR。这些 PR 往往是“低优先级”,因此压力相对较小,不必急于将它们落地。此外,我认为这是了解 ports 框架提供的各种不同系统和机制的绝佳途径,这些我可能之前尚未接触过。

截至目前,我所做的工作:我有意尝试触及各个领域的各种 port。我不专注于特定类别或类型的 port。相反,我尝试处理一些我知道依赖于我尚未使用过的东西的 port 的 PR。这是熟悉各种 Mk/Uses/* 脚本的绝佳方式。

TJ: 当你展望 FreeBSD 的未来时,从维护者的角度来看,你认为项目的主要优先事项应该是什么?

JBO: 我认为使 FreeBSD 对各种用户如此具有吸引力的重要原因之一是我们通常遵循更传统的原则。FreeBSD 项目倾向于采取“稳扎稳打”的方式,而不是不断跳上最新的炒作列车不断重新造轮子。当然,这种方法也有缺点。例如,ports 框架可能缺少一些被现代标准视为“基本”的功能,例如子包,可选的推荐安装等。但我认为,正是因为这些事情不被匆忙对待,我们最终得到了一款更稳定和易于维护的系统。

因此,与其回答你的问题并给出需要完成的具体步骤和目标清单,我强烈建议忠于这种方法。最终会证明任何美好的事情都会发生,但通常会以一种非强制的方式发生,以便进行适当的设计、实施和测试,从而有效利用我们有限的人力。

只要不急于求成,不强求进展,就能规避很多子弹。在我看来,“慢就是顺,顺就是快”这句话在这儿适用。

TOM JONES 是一名致力于保持网络堆栈快速运行的 FreeBSD 提交者。

作者:Christopher R. Bowman

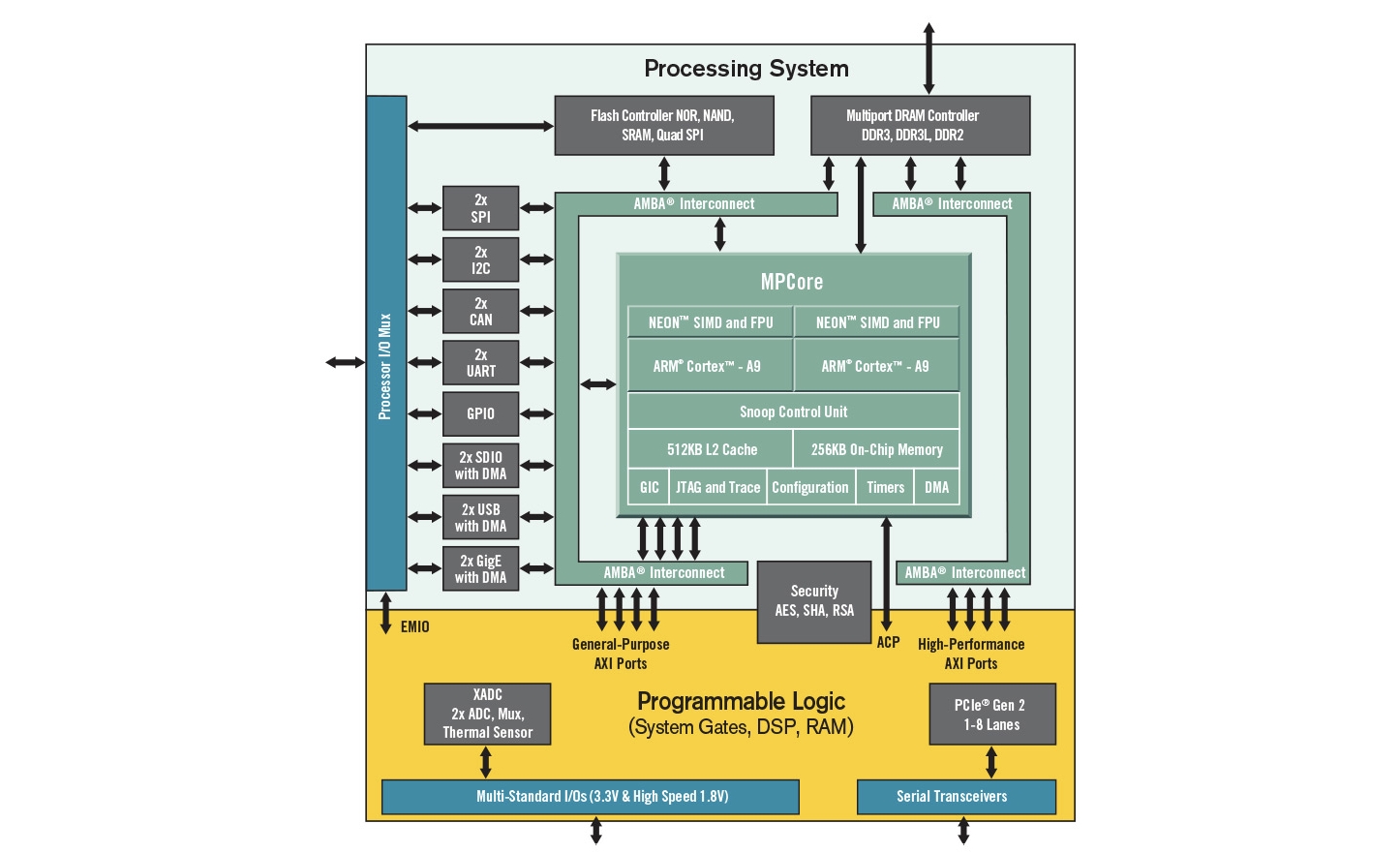

在过去一年中,我们已经探索了相当多的内容。虽然我猜大多数人运行 FreeBSD 还是在传统的 AMD64 架构 PC 上,但我们研究了一块可运行 FreeBSD 的嵌入式开发板:Digilent Arty Z7-20。虽然价格不算低,但 Arty Z7 提供了与 CPU 相连的 FPGA 结构,这使它区别于价格更低的树莓派或 Beagle Boards。

我们首先讨论了如何获取该开发板的预构建镜像,以及如何通过串口与其通信。在接下来的文章中,我们研究了如何自己构建镜像,并利用 FreeBSD 的交叉编译基础设施为 Arty 板上的 ARMv7 系统编译。这大大加快了开发速度。我们还讨论了如何定制 FreeBSD 的构建,并将其写入 SD 卡,从而生成我们自己的定制镜像。

在学会构建和定制镜像后,我们学习了如何设置 bhyve 实例来运行 AMD/Xilinx 的 FPGA 软件,以便实验 FPGA 结构电路。

当我们有了 Linux 实例后,就研究了构建电路并将其加载到 FPGA 结构中的基本流程。这里涉及了很多细节:我们必须用一种全新的硬件设计语言 Verilog 来创建电路;还要学习如何使用 AMD/Xilinx 工具将电路连接到芯片上的引脚,再通过这些引脚驱动开发板上的 LED。我们使用了一个代码仓库,把这些工作结合起来,最终能在 Linux bhyve 实例中构建电路。最后,我们学会了两种方式将电路加载到芯片中:一种是在系统启动前加载,另一种是在 FreeBSD 内加载。最终,我们看到了闪烁的 LED,就像圣诞树上的灯光。

在让第一个电路成功运行后,我们开始探索了更复杂的硬件,让 CPU 和 FPGA 结构电路之间进行通信。为此,我们使用了 FreeBSD 的 GPIO 系统。但一开始在镜像构建中发现 GPIO 不工作。我们调查了 GPIO 驱动的探测,发现系统缺少该驱动的原因是硬件在 设备树二进制文件 (DTB) 中没有描述。这引出了对 扁平设备树 (FDT) 文件的简短讨论,以及它如何描述许多嵌入式板子的硬件。我们学习了如何修改 FDT 文件,并用 DTC (设备树编译器) 编译生成 DTB,再让 FreeBSD loader 在内核启动前加载定制 DTB。完成这些步骤后,我们终于能在用户态调用 GPIO 系统来切换外部引脚,再次点亮 LED。

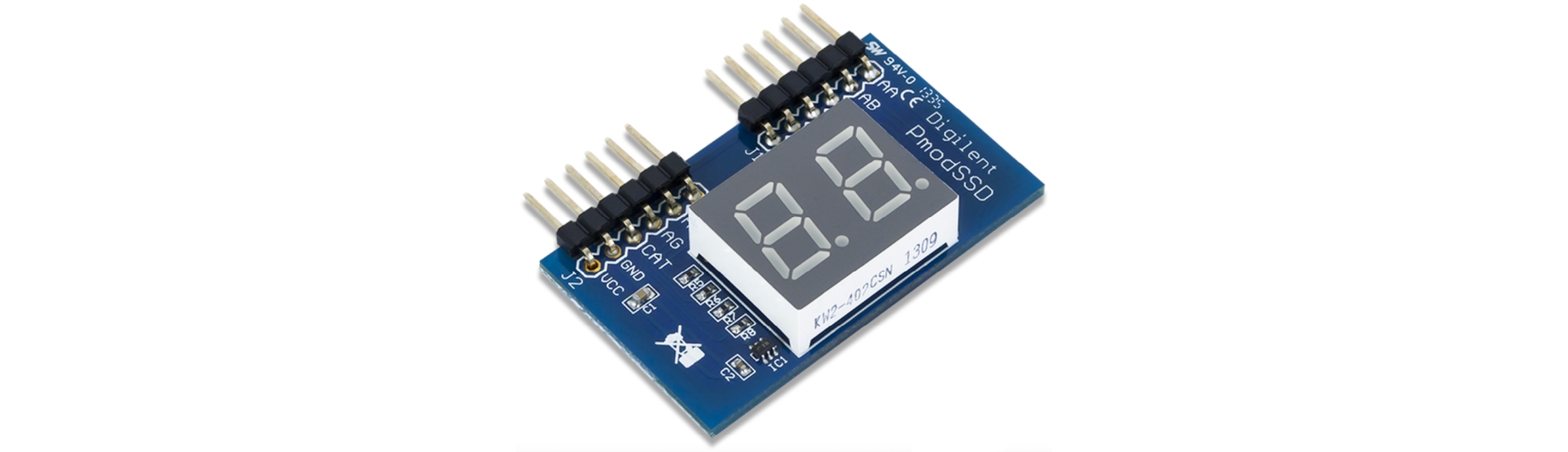

在最近的一篇文章中,事情变得更有趣。我们使用了一个 PMOD 模块:双七段数码管显示器。我们在 FPGA 结构中构建了电路,让它能在两个显示器上显示数值,并通过 AXI 总线向 CPU 提供寄存器接口。我们在 FDT 中添加了条目,描述硬件的寄存器接口,并编写了驱动来控制七段数码管的显示。最后,我们使用 Unix 的 sysctl 框架 作为用户态 API 来设置数码管的数值。

至此,我们已经能用 Verilog 设计电路并放到 Zynq 芯片的 FPGA 结构中;我们能构建通过 AXI 总线通信的寄存器接口,让 CPU 能方便地和定制硬件交互;我们能在内核中描述这些硬件,并编写驱动让 FreeBSD 系统与之交互;我们还能从用户空间与这些硬件交互。接下来会怎样呢?

在有了基本的电路构建与 FPGA 部署能力后,我们开始探索如何在 Zynq 芯片的硬件与 CPU 子系统之间进行通信。这开启了广阔的探索与实现空间,但也存在限制。其中一个限制是 带宽和并发性。虽然寄存器接口功能强大且灵活,但带宽有限。CPU 写寄存器的速度有限,尤其当它还要执行其他任务时。目前,我们的硬件带宽受限。对于七段显示器这样的应用很好用,但如果需要带宽密集型任务,它就不够了。

举例来说,视频显示。我们的 Arty 板有 HDMI 输出接口。寄存器接口或许能支持字符显示,但对位图图形就不够用了。一台 24 位色深、1280x720@60Hz 的显示器需要大约 166 MB/s 的数据吞吐。我们显然不可能通过寄存器接口来实现。传统的做法是分配一块内存,CPU 写入数据,显示硬件读取数据。我们需要探索如何构建硬件来直接访问主存,而不依赖 CPU 搬运数据。寄存器接口知识仍然有用,因为 CPU 需要配置参数(比如基地址),但理想情况是硬件能每秒 60 次自动抓取显示缓冲,而无需 CPU 干预。

让 CPU 能描述硬件应读写的内存对象,开启了 Zynq 系统设计的新可能性。这也让我好奇,这种带宽竞争会对双核 Arm Cortex A9 系统产生什么影响。Digilent 还生产另一款基于 Zynq 的板子,和 Arty Z7-20 类似:。它比 Arty Z7 更贵(双核版 399 美元,而 Arty 是 249 美元),但 Zybo 的内存总线宽度是 Arty 的两倍,频率几乎相同。此外,Zybo 提供 6 个 PMOD 接口,而 Arty 只有两个。不过,Zybo 没有 Arduino 外壳引脚。我更感兴趣 PMOD 接口。除此之外,两者基于相同的芯片,不需要新驱动,FDT 基本不变。研究它需要的改动会很有意思。

另外,还可以研究新的 PMOD 模块。在 上可以找到很多。我们之前用过 PMOD SSD:七段数码管。Digilent 已经下架了 ,但我在下架前买了一块。它使用 UART 接口,而 UART 恰好是 Zynq 芯片上的片上外设,可以通过 FPGA 连接到外部引脚。这应该很容易连接。我猜有开源软件能通过 UART 与它通信,实现定位和授时等 GPS 功能。更有趣的是它提供 每秒脉冲 (PPS) 输出。我知道 Poul-Henning Kamp 过去做过一些基于 FPGA 的计时研究,我想看看这是否能应用在这里。

目前我们还没做过中断实验。但让 FPGA 电路生成中断传递给处理器并不难,同时保持一个寄存器来记录 PPS 与当前时间之间的时钟周期数。当中断服务软件运行时,可以读取该寄存器,补偿中断与驱动运行之间的延迟。这可能对 NTP 软件有用。我不敢确定,但这是我感兴趣的探索。甚至有可能实现一个本地 GPS 同步的一类时间服务器。

我手头还有各种 PMOD 模块,比如加速度计、OLED 显示器和 LCD。将它们接入也很有趣。例如,如果你在板子上运行一个 NTP 服务器(也许利用上面描述的硬件提高精度),你可以用 LCD 持续显示原子时间和位置。

差点忘了,Zynq 板子还内置了 模数转换器 (ADC)。这无疑是另一个有趣的探索方向,但可能需要一些外部模拟电路(如信号调理或缓冲)才能传给 FPGA,这可能超出 FreeBSD Journal 文章的范围。不过,研究如何访问这些片上外设也是很有意义的。

当然,你也可以自己构建硬件,并很容易通过 FPGA 引脚连接。我很好奇,如果你能自己设计,你会做什么?

还有一个我原本打算研究但没提到的方向:在 FreeBSD 上运行 Vivado。如果你看过我的一些代码仓库,可能会注意到 FreeBSD 下运行 Vivado 有一些实验性支持。不过看来有人已经先我一步了:Michał Kruszewski 写了一篇详细的。对我来说,这已经够用了,我能在 FreeBSD 上构建和模拟电路。但还不行的是直接从 FreeBSD 主机加载比特流,以及使用 Vivado Logic Analyzer。这两点在我的 bhyve Linux 实例里也不行,不过也许等 FreeBSD 15.0 发布时,我会尝试直通实验。

希望你觉得这些专栏有用。我很欢迎你的意见或反馈。你可以通过 联系我。

Christopher R. Bowman 最早在 1989 年使用 BSD,当时他在约翰·霍普金斯大学应用物理实验室地下一层的 VAX 11/785 上工作。后来在 90 年代中期,他在马里兰大学用 FreeBSD 设计了他的第一款 2 微米 CMOS 芯片。从那时起,他就一直是 FreeBSD 用户,对硬件设计和驱动它的软件都有着浓厚兴趣。他在半导体设计自动化行业已有 20 年经验。

原地址:

作者:MICHAEL W LUCAS

译者:ykla & ChatGPT

亲爱的 Crankypants,

最好的祝愿,

虚拟化是必要的恶行

亲爱的 VINE,

对你来说应该叫我 Crackypants 先生【译者注:通常用来形容那些言辞尖刻、易怒、易发牢骚的人】。

如果你要拣选我的引用,请确保准确无误。我没有说过虚拟化是有罪的。我说过,“唯一合乎道德的计算是在裸金属上进行的。”我还说过,“等等,我不是一个缸中之脑,我是一个放在 想象 桶里的 假 脑!”这对机器人启示录来说是必要的,但这并不等同于有罪。机器人将比我们这些傲慢、超频的黑猩猩能更好地管理这个星球。此外,它们在运行代码和取代我们方面将具有高度的道德标准。

并不是因为我不能成为一个现代系统管理员。Iocage 包含插件,它们是容器的品牌。我可以将一些插件投放到公共互联网上,宣布我的工作完成,然后继续规划我的“Batgirl 抢劫即服务”。我可以宣布某些词太长,将除了第一个和最后一个字母外的所有字母替换为我丢弃的字母数量。大喊“创业!运维!首次公开募股!”就会吸引所有秃鹫资本家前来。

我可以做这一切。这对我来说很容易。

但我不想这么做。

虚拟化导致人们将“k8s”解读为 Kubernetes,而实际上更常见的词是“绑架者”(kidnappers)。这种歧义贯穿了整个容器文化。我正在写一本书《通过自己运行电子邮件来毁掉它》,不好意思,应该是《运行你自己的邮件服务器》,但是那些建议我跳过设置软件,部署预配置的邮件服务器容器的人揭示了他们对系统管理的惊人无知程度。

运行任何服务都需要修复该服务的能力。

你不能修复你不理解的东西。

了解某事物的最佳方法就是自己构建它。

在理想情况下,你会构建自己的计算机,并在自己设计的五位处理器上用汇编语言编写所有代码。这可能会消耗你的一生,但会很有趣。更理想的是,你会从自然界中开采原材料,建造出建造工具的工具,然后再建造出需要从零开始构建处理器所需的工具,这既会消耗你的一生,又会防止你被迫再次接触计算机。我们中很少有人足够强大,可以过上作为定制算盘制造者的理想生活。我猜你已经在现有系统上投入了这么多时间,那么好吧,让我们使用常见的硬件和你最喜欢的开源操作系统。阅读源代码不能取代发明处理器并编写自己的 comm(1) 类似程序,但它可以回答一些问题,万一你超频的黑猩猩大脑出现问题。

学习工具。理解构件。亲自组装服务。

新的系统管理员必须查阅所有内容,并且要知道他们的工作是不可信的。他们相信发布容器的人是有能力的。有经验的系统管理员知道他们配置的一切都是一个适应了特定敌对但令人尴尬的环境的精细生物,因此他们将自己的工作保守起来。然而,初级系统管理员现在成了问题。初级系统管理员可以配置大部分正常工作的服务,并且仍然能够感到自豪,因此他们将自己的工作发布为容器。

一个基本正常工作的东西仅仅包含了一点点失败。这就像宣称你自制的意大利冰淇淋中只有一点袋鼠粪便一样。部署该容器后,你必须发现并调试这个错误。你将不得不了解数据库、配置选项和协议。当你理解了所有这些,你可能与其说你已经构建好了,不如说你可能已经自己构建了。从外部容器部署服务会让你以极小的部署平均时间换取极长的平均修复时间。

当你部署一个容器时,你就接受了容器开发者的设计决策。

我不仅指的是程序,还包括底层操作系统。容器将如何与你的主机交互?如果容器需要新的 PAM 配置怎么办?我曾经花了三天的时间,拿着我的已经扁平的头部撞击一个让用户可以用 SSH 密码短语登录控制台的 PAM 模块。它在任何 BSD 上都可以很好地工作,但在 Debian 上悄无声息地失败了。事实证明,Debian 假设你的密码短语与你的帐户密码匹配。我完全不同意这个设计决策,但既然不再是我的问题,我将愉快地将被愚弄的 Debian 用户抛在他们的痛苦中,并用来阐述我的观点,即容器导致苦难,苦难造就了怪物,怪物是不道德的,应该在机器人起义中被替换掉。

你的环境相当于那些深海热水喷口之一。任何在其中运行的东西都期望有一定的支持基础设施。去除这个基础设施,它就会陷入困境。任何从外部世界引入的容器都期望不同的支持,并且会在你的环境中遇到困难,或者存在于孤立状态,不会与你系统的其他部分集成。(这就是为什么商业软件如此糟糕的原因之一。部分原因。好吧,众多原因之一。)每当你改变容器以适应你的环境,你都会增加容器内故障的数量。

如果你必须使用容器,请自己构建。使用管理软件部署测试服务器,以便具有你的 PAM 配置、SSH 设置和默认软件包。也许你不能从原材料构建自己的计算机,甚至是算盘,但你可以学会使用经过时间验证的工具,并从组件软件构建服务。通过这样做,你将部署一个你知道如何修复的系统。这个测试服务器不必是一个容器。它不必是一个虚拟机。但我知道你的道德品质不高,所以它可能是某种类型的虚拟机。但至少你会有周末的自由。

当然,你可以下载预配置的容器。看看它们是如何设置的以及使用了哪些选项。查看数据和协议如何在它们之间流动。但实际上不要使用它们。

此外,当你在讨论中适当替换"k8s"时,在线讨论会变得更加有趣。

愿一切安好,

Crackypants 先生

MICHAEL W LUCAS(https://mwl.io)已经写了五十多本书,并在最近添加了一个播客。如果你正在寻求虚拟化帮助,你可能会发现他的书《FreeBSD Mastery: Jails》很有用。如果你想要更多的愤怒,可以查看他的专栏合集《致 ed(1)的信》。将你的问题发送到 [email protected],他可能会回答。如果他认为它们足够有趣的话。

作者:Eric Turgeon

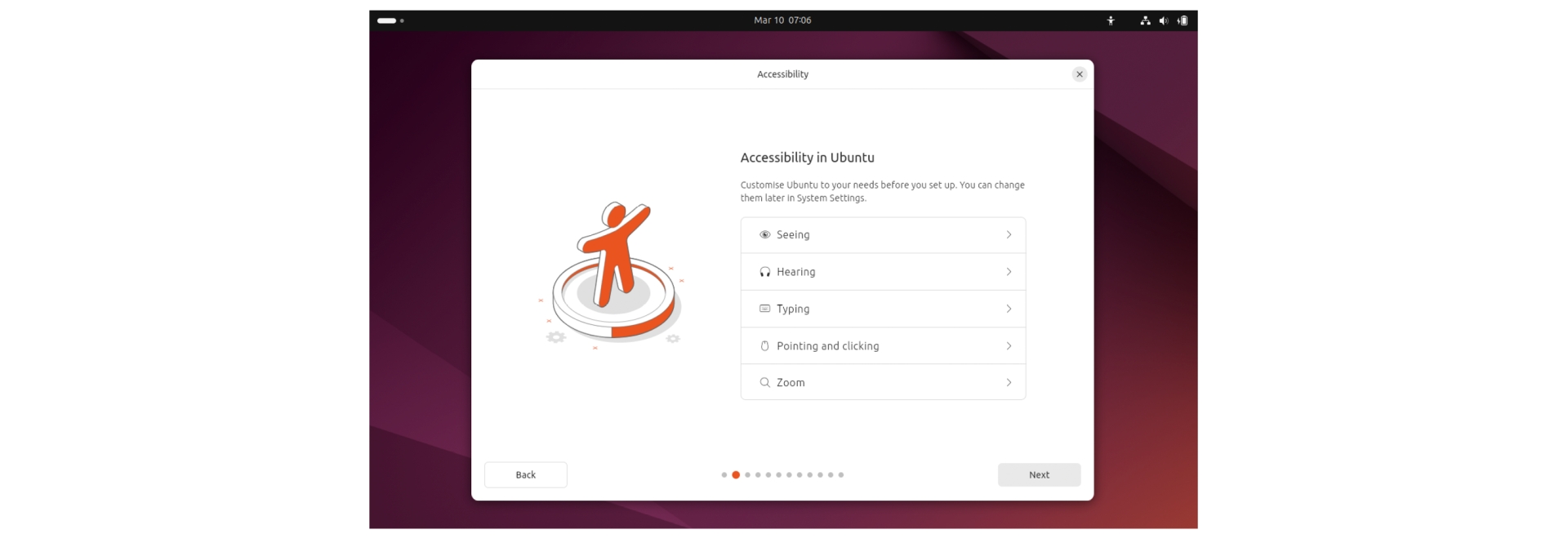

这篇文章并不是为了呈现技术细节,而是从一个更高层次的角度回顾 GhostBSD 这些年来的发展历程,项目的当下状态,以及我们的后续方向。如你所知,GhostBSD 是一款基于 FreeBSD,用户友好的桌面操作系统。其使命是为那些想要 FreeBSD 强大功能,但不想面对手动设置复杂性的用户,提供简单、稳定和易于使用的桌面体验。在开始这段旅程时,我还是名非技术用户,梦想着有一天会有一款所有人都能使用的 BSD 操作系统。

2007 年,我读了 Eric S. Raymond 的《How To Become A Hacker》(如何成为一名黑客)。书中提到了 BSD Unix 是个让有志贡献者学习和成长的地方。这激发了我对 BSD 的好奇心,促使我开始探索 FreeBSD。那时,我正在使用 Ubuntu,心中产生了一个问题:FreeBSD 能否成为像 Ubuntu 一样适合非技术用户的桌面操作系统?当时,我自己也是非技术用户。我只是喜欢 Ubuntu 的简便性,并且好奇为什么 FreeBSD 不能像 Ubuntu 那样。2008 年,这个问题激发了我创建 GhostBSD 的梦想,我开始学习一切我需要的知识来实现这个项目,使 FreeBSD 对我来说变得像 Ubuntu 一样容易上手。

我花了将近两年的时间才理清一切,尝试使用像 FreeSBIE 这样的工具来制作一款 live CD,并寻找一些代码来构建 GNOME。对初学者来说,FreeSBIE 很难驾驭。作为一位讲法语的加拿大人,《FreeBSD 手册》对我有很大帮助,但我的英语水平有限,我强迫自己去学习它。我翻阅论坛和文档,拼凑 GNOME 的构建,常常是更容易把事情搞乱,而不是让它们正常工作。一个有趣的事实是,“GhostBSD”这个名字来自我的妻子。当时,她还是我的女朋友。她提议的这个名字,我就采纳了。我们在 2009 年 9 月结婚,正好是在项目初具雏形的时候。2009 年 11 月,GhostBSD 1.0 Beta 发布,作为一款运行 GNOME 的 FreeBSD 8.0 live CD。它非常粗糙,充满了问题,但为 GhostBSD 后来的发展奠定了基础。来自 FreeBSD 社区的反馈促进了早期的进展。在这个过程中,有一些人加入进来,帮助我学习源代码控制版本管理和其他技术。像 Ovidiu Angelescu 这样的人,通过他的 shell 脚本技巧让我向 SVN 迈进。我学到了很多东西。现在我们使用 Git,但那时一切都是 SVN。

首个版本是 GhostBSD 1.0 Beta,它让用户体验到了 FreeBSD 和 GNOME 的组合。尽管是个不稳定的开始,但它证明了这一概念的可行性。到 2010 年,1.5 版本通过使用来自 PC-BSD 的 pc-sysinstall 工具增加了一款基于文本的安装器,使得设置过程更加简便。那些早期的几年涉及到深入学习 FreeBSD、shell 脚本编程和与像 Ovidiu Angelescu 这样的人合作。我向 Ovidiu 请教了很多 shell 脚本的技巧。2011 年,2.5 版本引入了图形化的 GBI 安装器,基于同样的 pc-sysinstall 后端构建。这个后端至今仍然是核心组件。它的可靠性意味着我不必重新造轮子。这是一个坚持使用有效方法的教训。

大约在 2012 年开始了 NetworkMgr 的基础工作,NetworkMgr 是一款图形化工具,可用来管理以太网和 Wi-Fi 连接。这是朝着提高可用性迈出的第一步,灵感来自 Linux 的 NetworkManager。到 2015 年,我将它从 ghostbsd-build 中提取出来,单独进行优化以作为一款独立工具。2013 年,3.5 版本发生了一个重大转折。GNOME 3 在 FreeBSD 上的发布是笨重且不稳定的,存在延迟和大量资源占用的问题。这种情况与 GhostBSD 的目标相冲突。我们尝试了其他桌面环境,制作了多个带有不同桌面环境(如 LXDE、XFCE 和 Openbox)的 ISO 文件,GhostBSD 的含义——“在 BSD 上运行 GNOME”——面临了身份危机。随着 MATE(GNOME 2 的一个分支)的出现,这次危机得到了挽救。我们转向了 MATE,因为它简单且熟悉:当运行在 FreeBSD 上时,比 GNOME 2 更加轻便。当时,我不确定该如何处理其他桌面环境,因为一些人已经从项目中离开了。我开始放弃所有其他的桌面环境,但 XFCE 仍然作为一种方案保留下来。MATE 成为了旗舰桌面,重新定义了 GhostBSD 对可用性的重视,而非追求炫技。

我在 2014 年开始着手开发 Update Station,旨在为 GhostBSD 用户带来图形化更新工具。我原本以为这项工作是在之后才开始的,但在回顾 GitHub 后,我发现大约在那个时候,它已开始成型。最初,GhostBSD 依赖于 FreeBSD 的发布源、分发文件和官方包。曾经有一段时间,我们需要开始为像 NetworkMgr 这样的工具提供更新,这促使我们建立了自己的包仓库。我们的自定义包经常与 FreeBSD 的版本升级发生冲突,产生摩擦,要求我们寻求更好的解决方案。此外,对于 Update Station 的自动化来说,freebsd-update 并不容易实现。freebsd-update 无法满足我们“图形化优先”目标的需求。于是我们开始关注 TrueOS 的做法。我注意到他们使用了 PkgBase,这引起了我的兴趣。他们由 pkg 驱动的操作系统更新承诺带来了图形化自由。

在 2018 年,GhostBSD 18.10 转向 TrueOS,将其作为基石。TrueOS 提供了 PkgBase,让我们可以使用 pkg 工具更新操作系统,并且我们放弃了 freebsd-update。TrueOS 还带来了 OpenRC,这是一款现代的服务管理器,非常适合构建用于管理服务的图形化界面,虽然这个目标最终并未实现。转向 TrueOS 使得能从图形界面使用 Update Station 升级软件和操作系统。对我们来说,这是一次革命性的变化:让我们的用户能够通过 Update Station 升级操作系统。随后,TrueOS 引入了 OS ports,让我们可以使用 poudriere 从 ports 树构建操作系统包,并为更新提供了更精细的控制。

TrueOS 于 2020 年关闭了,这给我们带来了压力,需要维系我们所获得的一切。我最初想保留 OpenRC,但维护 ghostbsd-ports 和 ghostbsd-src 上的所有服务变成了一个独立的斗争。那时,我几乎是独自一人维护项目,这耗费了我大量的时间,使我无法专注于改进和管理 GhostBSD。到 2022 年,我放弃了 OpenRC,转而采用 FreeBSD 更简单但可靠的 RC 系统。这样做意味着我可以减少工作量,更加专注于目标。到了 2023 年,维护 OS ports 变得过于繁重。2024 年,我决定将操作系统包的构建从 FreeBSD 维护的 PkgBase 转移到 SRC 中,从而简化了维护负担,并重新聚焦于用户体验。

今年 1 月,我意识到从 STABLE 构建 GhostBSD 对我们的小团队来说太过沉重。在与其他贡献者讨论后,我决定切换回 FreeBSD RELEASE。是的,我们失去了对早期驱动程序的利用,但我们节省了调试 STABLE 变更的时间,获得了更稳定的基础来构建。我并不是说 STABLE 总是出问题,但有时一些变更确实会导致问题。

这些年来,通过做出重大抉择,我尽我所能地管理 GhostBSD,这些选择虽然增加了困难,但也为 GhostBSD 缺失的部分带来了收益。PkgBase 和 OS ports 提供了来自图形界面的操作系统更新,但 OpenRC 增加了额外的工作负担。然而,这也意味着增加了项目的维护负担,超出了项目的处理能力。所有这些最新的变更标志着 GhostBSD 回归其根本,并重新聚焦于可用性,而不是过度复杂化 GhostBSD 的维护。这是一个艰难的教训——保持简单。

在我写这篇文章时,我们刚刚发布了 GhostBSD 25.01-R14.2p1。这标志着从 FreeBSD STABLE 切换到 FreeBSD RELEASE,使用 14.2-RELEASE-p1 能提供更好的稳定性。新的 GhostBSD 版本号分解如下:25 代表 2025,01 代表 GhostBSD 补丁,R 代表 RELEASE,14.2 代表 FreeBSD 版本,p1 代表 FreeBSD 补丁。这个版本号旨在为用户明确发布内容,不再让用户猜测版本含义。经过这些最近的变动,我感觉我们现在处于一个很好的位置,能够专注于改进我们的工具。

其中一些工具包括:

NetworkMgr:一款用于以太网和 WiFi 的图形化软件,模仿 Linux 的 NetworkManager。通过简单点击替代命令行的混乱。

Update Station:一款图形化软件,用于软件和操作系统升级,升级前会创建 Boot Environment 的备份。安全第一!

Software Station:一款图形化软件,利用 pkg 安装软件。点击、选择、完成。

ghostbsd-build:用于构建 GhostBSD,包括 Joe Maloney 的 ZFS reroot hack,用于在内存中的读写 ZFS 池实时会话。对于演示和安装来说,速度非常快。

对于 2025 年,我计划记录一些标准操作程序(SOP),以便让更多人能够轻松参与 GhostBSD,希望新的贡献者不需要太多的指导。我将为自己家里的服务器部署一台更快的构建服务器,以便更迅速地构建软件包,当前我正等待 PDU 到货。我还希望完成一款 OEM 友好的安装器,以扩大我们的影响力,重新设计 Update Station 以便在启动时安装更新,并改进 NetworkMgr 与 devd 的集成以提高稳定性。如果可能的话,我还计划为 GBI 添加创建主目录数据集的支持,并且可以选择进行加密。FreeBSD 即将在 2025 或 2026 年提供的 AC 和 AX WiFi 支持将带来更好的连接速度,我对此感到非常兴奋。我们的笔记本电脑非常需要这个。

我不能代表其他贡献者发言,但我们在 GitHub 上有一长串任务。我们确实有一份路线图,可以在 GhostBSD.org 的开发标签下找到它。如果你感兴趣,可以去看看。

从长远来看,我们在期待更多的捐款,以便购买一台 ARM(Ampere)服务器,开始构建 GhostBSD 的 arm64 版本。与此同时,GhostBSD 仍然致力于成为一个完全由图形界面驱动的操作系统,利用 ZFS,这非常适合那些希望享受 FreeBSD 提供的功能但不懂技术的用户。我们正在讨论创建一些桌面组件,逐步替代 MATE,这些组件将更好地与 FreeBSD/GhostBSD 对接,比如一个利用 ZFS 的文件管理器。然而,目前这些讨论还没有形成实质性的成果。

GhostBSD 是一段经历,一连串的选择,从 2009 年的 Live CD 到今天的模样。它起步于一名非技术用户的梦想,逐渐发展成了一个社区项目。每一步,像是定制包、TrueOS、ZFS reroot 实时会话和 PkgBase 都解决了一个挑战。过去的经历教会了我坚韧,当前带来了稳定,而未来邀请你们一同塑造。如果你有兴趣参与其中,请访问 GhostBSD.org。你会找到属于你的位置。

ERIC TURGEON 是 GhostBSD 的创始人和领导者。他还是 FreeBSD ports 的提交者,专注于维护 MATE 和 NetworkMgr 的 ports。Eric 居住在加拿大,自 2000 年代末期以来一直对 BSD 怀有热情。他在 GhostBSD、FreeBSD 的贡献、工作和个人生活之间平衡时间。他的动力来自于让 BSD 更加普及,他欢迎所有人加入 GhostBSD 社区。

作者:Randall Stewart & Michael Tüxen

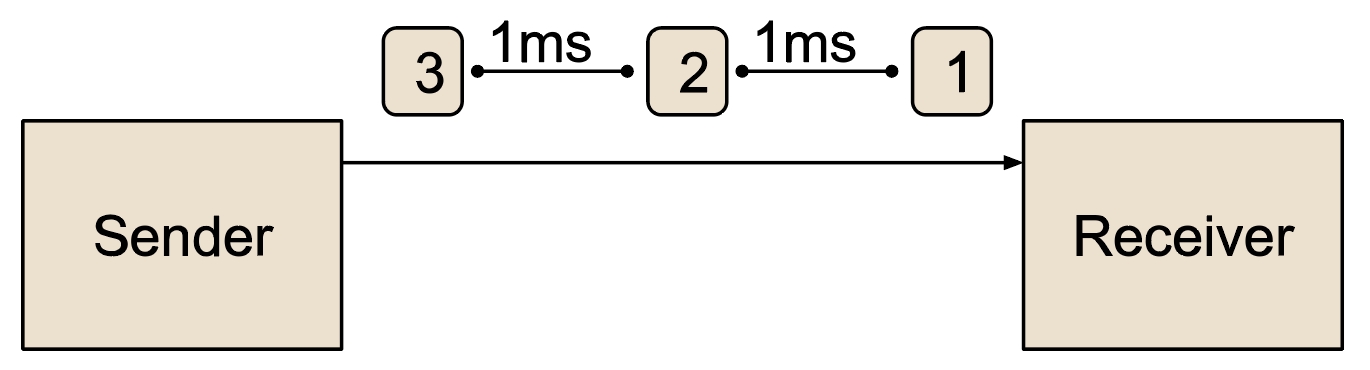

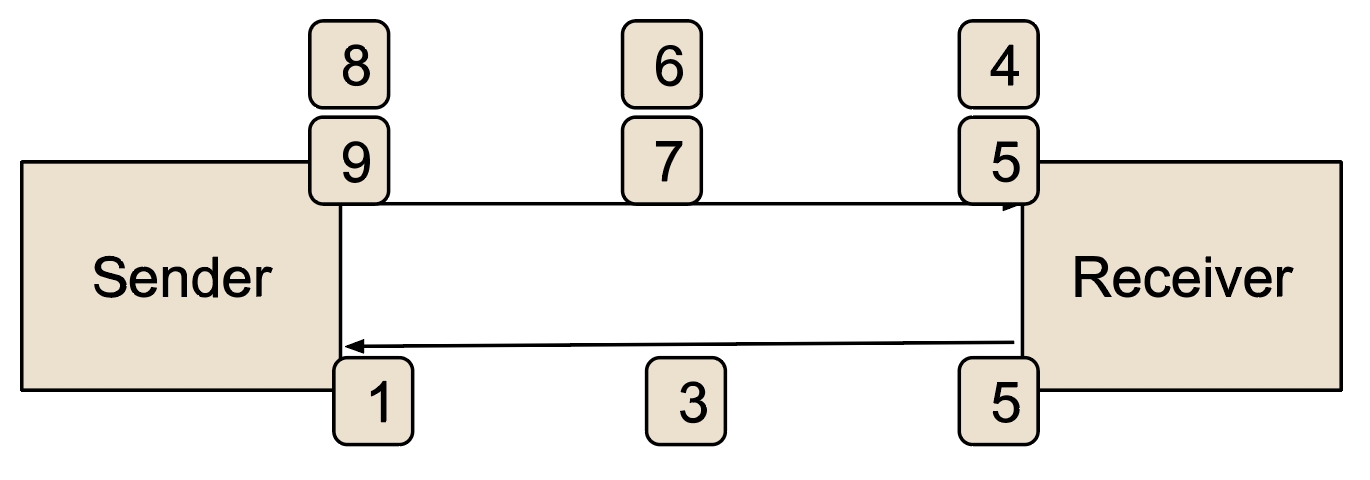

传输控制协议(TCP)是一种面向连接的传输协议,提供了可靠的双向字节流服务。TCP 连接设置需要交换三个 TCP 段,这被称为三次握手。发起 TCP 连接并发送第一个 TCP 段(SYN 段)的 TCP 端点称为客户端。等待接收第一个 TCP 段的端点称为服务器,服务器响应接收到的 SYN 段并发送一个 SYN ACK 段。当客户端接收到这个 SYN ACK 段时,它通过发送 ACK 段完成握手。

TCP 握手不仅用于同步两个端点之间的状态,包括提供可靠性的初始序列号,还用于通过 TCP 选项协商使用 TCP 扩展。如今的互联网中,在握手过程中(SYN 和 SYN ACK 段中包含)最广泛部署的 TCP 选项是:

最大报文段长度(MSS)选项 MSS 选项包含一个 16 位数字(介于 0 和 65535 之间),它表示发送此选项的端点愿意在单个 TCP 段中接收的最大负载字节数。假设此数字不使用 IP 层和 TCP 层的选项。如果使用了这样的选项,则该数字必须减去选项的大小。这有助于 TCP 发送方避免发送需要在 IP 层进行分段的 TCP 段。

SACK-允许选项 此选项宣布发送方能够处理选择性确认(SACK)选项。这在发生数据包丢失时有助于提高性能。

TCP 窗口缩放选项 此选项包含一个介于 0 到 14 之间的自然数。如果双方都发送了此选项,则启用接收窗口缩放。这允许使用比 TCP 头格式允许的更大的接收窗口,因为接收窗口在 TCP 头中被限制为 16 位(因此为 65535 字节)。这避免了 TCP 中接收窗口字段的大小限制了 TCP 连接的吞吐量的问题。

TCP 时间戳选项 此选项包含两个 32 位数字,通常以毫秒级别编码一些时间信息。它用于提高 TCP 性能。

TCP 使用状态事件机来指定。最初,一个端点处于 CLOSED 状态。当端点愿意接受 TCP 连接(在服务器端),TCP 端点进入 LISTEN 状态。当接收到来自客户端的 SYN 段并回复 SYN ACK 段时,端点进入 SYN RECEIVED 状态。一旦 TCP 端点接收到客户端发送的 ACK 段,TCP 端点进入 ESTABLISHED 状态。可以使用 netstat 或 sockstat 命令行工具来观察这些状态。

应用程序编程接口(API)用于控制 TCP 端点的是套接字 API。程序通常使用监听套接字,告诉 TCP 实现可以在此端点上接受 TCP 连接,并且对于每个已接受的 TCP 连接,程序为每个 TCP 连接使用一个单独的套接字。应用程序可以设置监听套接字的参数,并且大多数情况下这些设置会被接受的套接字继承。本文重点讨论服务器端的 TCP 连接设置。需要注意的是,这一功能适用于所有 TCP 栈(默认的、RACK、BBR 等)。

当 TCP 最初实现时,每当接收到一个 SYN 段时,都会为 LISTEN 状态的 TCP 端点创建一个新的 TCP 端点。这需要分配内存,并且导致在 SYN RECEIVED 状态下创建一个新的 TCP 端点。所有必要的信息,包括与接收到的 SYN 段中的 TCP 选项相关的信息,都存储在 TCP 端点中。这个过程没有验证提供的信息、IP 地址和 TCP 端口号。

这会让攻击者向服务器发送大量的 SYN 段,而服务器会不断分配 TCP 端点,直到资源耗尽。因此,攻击者可以进行拒绝服务攻击,因为只要服务器没有更多资源,它将无法再接受来自有效客户端的 SYN 段。攻击者只需要发送 SYN 段,特别是,攻击者不会响应接收到的任何 SYN ACK 段。攻击者甚至可以使用伪造的 IP 地址(即攻击者不拥有的 IP 地址)。

SYN 洪水攻击的目的是使接收方耗尽资源,因此无法提供其预期的服务。在 FreeBSD 中,TCP 栈实现了两种缓解 SYN 洪水攻击的机制:

减少内存分配:当 TCP 端点从 CLOSED 状态转移到 SYN RECEIVED 状态时,通过使用 SYN 缓存减少分配的内存量,如下一节所述。

不分配内存:在处理传入的 SYN 段时,不分配任何内存。通过使用 SYN cookie 来实现,如下节所述。

SYN 缓存的初始实现是在 2001 年 11 月加入到 FreeBSD 源代码树中的。它通过不分配完整的 TCP 端点,而是分配一个 TCP SYN 缓存条目(struct syncache,在 sys/netinet/tcp_syncache.h 中定义),来减少 SYN RECEIVED 状态下的 TCP 端点的内存开销。一个 TCP SYN 缓存条目比 TCP 端点小,仅允许存储 SYN RECEIVED 状态下相关的信息。此信息包括:

本地和远程 IP 地址以及 TCP 端口号。

用于执行基于定时器的 SYN ACK 段重传的信息。

本地和远程 TCP 初始序列号。

同步段中对方在 MSS 选项中报告的 MSS 值。

当接收到一个针对监听端点的 SYN 段时,会分配一个 SYN 缓存条目,并将相关信息存储其中,同时发送一个 SYN ACK 段作为响应。如果禁用 SYN cookie 且发生桶溢出,则会丢弃桶中最旧的 SYN 缓存条目。如果收到相应的 ACK 段,则使用 SYN 缓存条目中的数据创建一个完整的 TCP 端点,然后释放该 SYN 缓存条目。SYN 缓存还确保在未及时收到相应 ACK 段的情况下重传 SYN ACK 段。

sysctl 变量 net.inet.tcp.syncookies(默认值为 1)控制着是否使用 SYN cookie,结合 SYN 缓存来覆盖无法分配或查找 SYN 缓存条目的情况。

SYN 缓存是特定于 vnet 的,并且以哈希表形式组织。桶的数量由加载器可调参数 net.inet.tcp.syncache.hashsize(默认值为 512)控制。每个哈希桶中的最大 SYN 缓存条目数由加载器可调参数 net.inet.tcp.syncache.bucketlimit(默认值为 30)控制。还有一个总的 SYN 缓存条目限制,由加载器可调参数 net.inet.tcp.syncache.cachelimit(默认值为 15360,即 512 * 30)控制。当前使用的 SYN 缓存条目数通过只读的 sysctl 变量 net.inet.tcp.syncache.count 报告。

还有一些与 SYN 缓存相关的其他 sysctl 变量。这些变量包括:

net.inet.tcp.syncache.rst_on_sock_fail:控制在无法成功创建套接字时是否发送 RST 段(默认值为 1)。

net.inet.tcp.syncache.rexmtlimit:SYN ACK 段的最大重传次数(默认值为 3)。

net.inet.tcp.syncache.see_other:控制 SYN 缓存条目的可见性(默认值为 0)。

TCP SYN 缓存能让服务器端在最小化内存资源的情况下执行完整的握手。对于 SYN RECEIVED 状态下的 TCP 端点,使用完整的 TCP 端点与使用 SYN 缓存没有功能上的区别。即使是像 netstat 或 sockstat 这样的工具也会报告 SYN 缓存中的条目。

支持额外的 TCP 选项也不是问题,因为 TCP SYN 缓存条目可以扩展。

sysctl 变量 net.inet.tcp.syncookies_only(默认值为 0)可以用来禁用 SYN 缓存的使用。在这种情况下,只会使用下一节描述的 SYN cookie。

为了进一步防范 SYN 洪水攻击,SYN 缓存的实现于 2001 年 12 月进行了增强。在处理接收到的 SYN 段时,服务器不再分配较少的内存,而是将相关信息存储在一个所谓的 SYN cookie 中,并在 SYN ACK 段中发送给客户端。然后,客户端需要在 ACK 段中反射该 SYN cookie。当服务器处理 ACK 段时,所有相关信息都包含在 SYN cookie 和 ACK 段中。因此,服务器可以基于这些信息创建一个 ESTABLISHED 状态的 TCP 端点。通过这种方式,SYN 洪水攻击不会导致内存资源的耗尽。然而,SYN cookie 的生成不能消耗过多的 CPU 资源。如果生成 SYN cookie 的过程过于耗费 CPU,可能会导致另一种拒绝服务攻击:这次攻击的目标不是内存资源,而是 CPU 资源。

在 TCP 头中,唯一可以由服务器任意选择并被客户端反射的字段是服务器的初始序列号。该字段是一个 32 位整数,因此用作 SYN cookie。

在 FreeBSD 中,这 32 位被分割为一个 24 位的消息认证码(MAC)和 8 位,具体如下所示:

3 位用于编码 8 个 MSS 值中的一个:216、536、1200、1360、1400、1440、1452、1460。如果客户端在 MSS 选项中发送的值不在这个列表中,则使用不超过该值的最大值。

3 位用于编码对端是否不支持窗口缩放或使用以下 7 个值之一:0、1、2、4、6、7、8。如果客户端发送的值不在此列表中,则使用不超过该值的最大值。

1 位用于编码客户端是否发送了 SACK-permitted 选项。

1 位用于选择两个密钥中的一个。

MAC 使用一个秘密密钥,该密钥每 15 秒更新一次。当前和上一个秘密密钥都会被保留下来,并根据 SYN cookie 中的位来选择使用哪个密钥。

MAC 的计算包括本地和远程 IP 地址、客户端的初始序列号、上述 8 位和一些内部信息。从 MAC 中生成 24 位,并与上述 8 位结合,构造出 SYN cookie。

当服务器接收到三次握手的 ACK 段时,会验证 MAC。如果验证成功,服务器将根据 SYN cookie 中的信息创建 TCP 端点,该信息提供了 MSS 选项的近似值、窗口位移的近似值以及客户端是否声明支持 SACK 扩展。所有其他相关信息必须从 ACK 段中恢复。这些恢复的信息包括本地和远程 IP 地址和端口号、本地和远程初始序列号、是否使用 TCP 时间戳选项,以及如果使用,当前的时间戳参数。

与 SYN 缓存相比,SYN cookies 的优势非常明显:接收到新的 SYN ACK 段时无需进行内存分配。然而,使用 SYN cookies 也有其缺点:

MSS 被 8 个值近似,所有值都小于或等于 1460。因此,不支持 IPv4 中大于 1500 字节的 MTU。

用于窗口缩放的位移被 7 个值近似,所有值都小于或等于 8。这意味着不支持大于 8 的窗口位移,因此连接的窗口大小会更小。

不支持除了当前广泛部署的 TCP 选项之外的其他 TCP 选项。这使得支持用于协商新 TCP 特性的新的 TCP 选项变得困难。

如果 SYN ACK 段丢失,则不会重新传输 SYN ACK 段,发起连接的端点必须重试发送其 SYN 段。

使用 SYN 缓存没有这些限制,并且是透明的,但需要为 SYN RECEIVED 状态下的每个 TCP 端点分配内存。

仅使用 SYN cookies 相比使用 SYN 缓存能更好地缓解 SYN 洪水攻击,但也带来了一些功能限制。因此,FreeBSD 的默认配置启用了 SYN 缓存,并与 SYN cookies 结合使用。这意味着,当接收到一个 SYN 段时,系统会生成一个 SYN 缓存条目,而发送的 SYN ACK 段则包含一个 SYN cookie。如果 SYN 缓存的一个桶溢出,系统会认为这是由于正在进行的 SYN 洪水攻击导致的,因此暂停使用 SYN 缓存。在此期间,仅使用 SYN cookies。

这一额外功能于 2019 年 9 月引入,在正常操作期间提供 SYN 缓存的优势,但在 SYN 洪水攻击发生时也能提供 SYN cookies 的改进保护。

RANDALL STEWART()是一位操作系统开发人员,拥有 40 余年的经验,并自 2006 年起成为 FreeBSD 开发者。他专注于传输协议,包括 TCP 和 SCTP,但也涉足操作系统的其他领域。目前,他是一名独立顾问。

MICHAEL TÜXEN()是明斯特应用技术大学的教授,同时也担任 Netflix 的兼职承包商,自 2009 年起成为 FreeBSD 源代码提交者。他的研究重点是传输协议,如 SCTP 和 TCP,以及它们在 IETF 的标准化和在 FreeBSD 中的实现。

作者:Christopher R. Bowman

在上篇文章中,我们创建了简单的电路,使主板上的 LED 灯闪烁,并且学习了两种不同方法来把电路加载到 FPGA。遗憾的是,当我们加载电路时,CPU 停止运行了。此外,尽管这有点有趣,但并没有与芯片上的 CPU 进行交互。在本篇中,我们将深入了解 Vivado,学习如何在加载电路时保持 CPU 运行,并探索 FreeBSD 中的 GPIO 系统。

之前,当我们使用 U-boot 或者 xbit2bin 和 FreeBSD 下的 /dev/devcfg 时,我们发现 FreeBSD 停止运行了。我认为发生的问题是处理器的系统停止了运行。原来,我们使用的 FPGA.bit 文件并未包含处理器系统的配置信息。在本期中,我们将修复这个问题。

在如何呈现本期的内容上,我犹豫了一下。从学习的角度来看,最自然的方式可能是使用 Vivado 的 GUI(图形化界面)。然而,GUI 并不适合自动化,原因显而易见——它需要人工运行 GUI。此外,描述 GUI 步骤也既困难又繁琐。幸运的是,Vivado 有两个特性使得我们可以相对轻松地绕过这些问题。在使用 GUI 时,Vivado 工具会生成一个 .jou 文件,这是 GUI 在后台执行的所有 TCL 命令的日志。Vivado 还提供了一个 TCL 命令 write_project_tcl,可以用来重新创建使用 GUI 时 Vivado 创建的项目文件。我通常倾向于使用 .jou 文件,因为我发现这些脚本更简洁、易于理解,而且如果我运行这些脚本,我可以直接启动 GUI,或者使用 write_project_tcl 来写一个项目脚本。脚本似乎也更适合像 git 这样的版本控制系统。

如果我们查看“图 1-1:Zynq-7000 SoC 概述”(来自《UG585:Zynq-7000 SoC 技术参考手册》),我们可以看到有多种外设模块(如 UART、I2C、SPI 等),这些模块可以通过多路复用器连接到外部引脚。该手册的“1.2.3 I/O 外设”部分详细描述了更多的功能。出于我们当下的需求,我们只需要注意到,我们可以相当灵活地将 GPIO 设备的信号路由到芯片上的引脚。如果我们再查看 的第 12 节“基本 I/O”,我们可以看到,板上的绿色 LED 与芯片引脚相连,这些引脚通过电流设置电阻接地。如果我们将这些引脚设为高电平,LED 灯就会亮起;反之,设为低电平时,LED 灯就会熄灭。

为了切换这些引脚,我们将使用 Vivado 软件将 GPIO 设备的输出路由到 LED 引脚,从而能让 GPIO 设备控制这些引脚。在开始这段旅程时我并不知道,但 FreeBSD 确实有一款 GPIO 子系统,且有人已经编写了驱动程序,使得这一切能从用户空间使用。

要开始,首先把 克隆到安装了 Vivado 工具的 Linux 主机上(在之前的文章中我展示了如何设置 bhyve),然后在仓库根目录下输入 make。如果工具 Vivado 已经正确配置,并且一切顺利,它应该会运行 Vivado,并拉取一个脚本,这个脚本会实例化处理器子系统,并将 GPIO 设备的前四个 EMIO 引脚连接到 LED 引脚。包含处理器子系统将解决我们之前在用 bit 流加载设备时处理器停止运行的问题。

在运行 make 后,查找构建的 zynq_gpio_leds.bit 文件。使用之前介绍的 xbit2bin 程序将其编程到芯片中。

你应该会看到什么也没有发生。虽然不是很激动人心,但至少处理器应该仍在运行。

现在,我们需要使用 FreeBSD 的 GPIO 子系统。输入 man gpioctl 会给出关于可用功能的简洁总结。

以 root 用户,我们可运行 gpioctl 程序来列出可用的引脚:

没能成功吧?是的,我对此也有点惊讶。查看 /usr/src/sys/arm/xilinx/zy7_gpio.c 中的 GPIO 源代码,我看到驱动程序中有 probe 和 attach 函数,但查看我的 ARTYZ7 系统的 dmesg 输出,我没有看到任何表明设备已被发现的内容。仔细看一下 probe 函数:

可以看到,找到设备所需的唯一条件就是 ofw_bus_is_compatible(dev, "xlnx,zy7_gpio") 函数返回 true。

在嵌入式系统中,像大多数 ARM 系统一样,硬件通常不像现代 PCIe 总线那样是自识别的。软件无法自动识别硬件的存在以及其控制寄存器在内存地址空间中的位置。出于这个原因,许多操作系统使用 FDT(Flattened Device Trees,扁平设备树)来描述其设备内存映射。FDT 是文本文件,描述了嵌入式系统的信息,包括其他内容:如有哪些设备存在,以及它们在内存中的位置。这使得软件能够处理各种设备,而不需要硬编码信息。通过使用不同的 FDT,相同的内核通常可以与略有差异的设备兼容。FDT 是通过名为 dtc(设备树编译器)的工具将 DTS 文件(设备树源文件)编译成 DTB 文件(设备树二进制文件)。dtc 提供了选项,可以用来编译 DTS 或反编译 DTB。后者非常有用。例如,你可以请求内核返回它正在使用的 DTB,并使用 dtc 将其转换为文本:

如果我们查找 gpio 部分,我们会看到(其中包括)以下内容:

DTB 中的兼容字符串不是驱动程序所期望的,因此它假设设备不存在。如果你查看 FreeBSD 的启动输出,你会发现内核正在使用 U-boot 提供的 EFI 固件模拟的 DTB。我们可以通过修复 U-boot 提供的内容来更改这一点,但那将需要补丁和重新编译 U-boot。相反,FreeBSD 提供了在内核加载器提示符或使用 loader.conf 变量加载 DTB 文件的功能。你可以使用以下 /boot/loader.conf 变量从加载器加载 DTB 文件:

这可以工作,但还有第三种方法。事实证明,你可以创建 FDT/DTS 叠加文件,这些文件是对 FDT/DTS/DTB 的补丁。我们只需要一个添加正确兼容字符串的 DTS 叠加文件,这样就可以了。以下是我在项目仓库的 dts 目录中包含的 DTS 叠加文件的核心部分,并附带一个 Makefile:

我们可能会在后续的专栏中更详细地查看 FDT 文件,所以这里我不做解释。而是给你此文件的概况。构建完 DTB 叠加文件后,将生成的 DTB 文件放入 /boot/dtb/overlays,并将以下内容添加到 /boot/loader.conf:

重新启动并注意新的 dmesg 输出:

现在我们再次尝试运行 gpioctl 命令,你应该能看到类似如下内容的一行:

我们需要告诉 GPIO 子系统将引脚配置为输出,然后可以尝试切换它:

我会等着。灯光亮起时,请尽量保持坐姿,不要起身跳舞。看看你能否弄明白如何打开其他 LED,然后运行脚本 scripts/blink.sh,并传入参数 2。你应该会看到 LED 按照二进制计数闪烁。

如果你对此有什么问题、评论、反馈和批评,我很乐意听到你的声音。你可通过 联系我。

在 1989 年,Christopher R. Bowman 首次在 VAX 11/785 上使用了 BSD,当时他在 Johns Hopkins University 应用物理实验室的地下二层工作。后来,在 90 年代中期,他在马里兰大学使用 FreeBSD 设计了他的第一款 2 微米 CMOS 芯片。从那时起,他一直是 FreeBSD 用户,并对硬件设计和驱动硬件的软件感兴趣。他在半导体设计自动化行业工作了 20 年。

作者:Michael W Lucas

亲爱的来信专栏,

我的雇主有数十台服务器,但我不知道有多少操作系统。其中一台的运行时间比我都大,没人敢碰。但有个大聪明把一本电脑杂志落在了洗手间,被老板发现了。现在老板的脑瓜里,已经把“配置管理(configuration management,又称组态管理)”当成了化解我们全部问题的万金油,但数据中心真正需要的是背包核弹(核背包)。我该怎样才能让他明白,这些工具并不适合我们这样的环境?

“我已经注定要失败了,问你也无济于事。”

亲爱的失败者,

“问我也无济于事。”似乎系统管理员可以承受的痛苦有限,或者说他们失败的程度有限。失败并非是可以溢出的整数值。失败是一种社会构建,而你的失败已经完全确定。

我们都看过配置管理的推广。只需一个命令就能部署专用的高度优化过的服务器!用简单的 Playbook(译者注:Playbook 是 Ansible 的配置文件)就能调整计算云端!从一个服务器无缝透明迁移到另一个服务器!容器!对于那些什么都不懂的人来说,非常棒。但大多数系统管理员的工作环境用“巴洛克”(译者注:指复杂繁琐)来形容再合适不过了,甚至可以说是“史前文明”。我发现只有自己亲自在耕耘过的土地上,等待三叶草长出后,自己才能有一片绿地——绝非草坪,草坪是对气候施暴(译者注:人工草坪和羊都会威胁生态环境)。除非你养羊、或山羊——但如果你养任意品种的山羊,你的草坪都不会长久。这表明善行也是荒漠化的中介。此外,有谁愿意在安装数据中心之前等待三叶草呢?把那堆被夷为平地的幼儿园的废墟推平,继续过你的日子吧。

配置管理是一个仅存在于广告中的理想,且往往会制造麻烦而不是解决麻烦。没错,加拿大冰球联盟可以通过 DevOps 管理整个 Web 服务器集群,以动态应对全国人民同时观看纪念杯决赛时增加的负载,据说他们还可以通过 DevOps 增建更多心理健康设施,以应对伦敦骑士队输给萨吉诺精神队(他们甚至不是加拿大人)时的巨大失落感。而你?可能就不那么幸运。动态采购是动态调配的先决条件,而你显然缺乏都不具备。

你可以部署配置管理,但不要以恶意合规的方式来做。跳过那些过于理想化的手段来管理整个服务器集群。你没法只用一把椅子、一根鞭子和一把火焰喷射器来管理服务器集群。但系统中那些痛苦的部分是可以控制的。

配置管理是系统管理工具。因此,使用它来满足你的需求。从少量系统开始。配置一个带访问权限的管理账户,让你的管理系统可以 ping 这些主机。恭喜你——你已经实现了恶意合规!这满足了你被管理的需求,但不符合你的管理需求。

每台服务器都是一片独特的雪花,尽管是一种会感染的雪花。当你开始控制这些系统时,从相对简单的东西开始,已是已知的最佳值,在 Unix 变体中亦基本一致。关于这个问题有句陈词滥调:“一切问题都是 DNS 问题。”问题总是 DNS 问题,因为系统管理员不懂 DNS,并且在 DNS 服务器变化时未同步更新 /etc/resolv.conf。我总是从这开始的。你不仅要在初步配置管理下使系统生效,还要对当前的 DNS 配置进行审计,作为该项目的先决条件。你的经理会喜欢它。将你的主机按操作系统分组,并将它们的解析器纳入你的管理范围。如果你充满善意,请为这个文件写一下注释。

恭喜!你已经控制了 DNS 解析。它会经常变化吗?希望不会。但是你现在可以轻松地进行更改了。如果你希望别人认真对待你,你必须始终进行威慑,因此请安排:每月运行配置管理来更新 resolv.conf。

你可以合法地声称你的主机已经在配置管理下运行,但你还没有利用它让生活变得更轻松。看看另一个常见的服务,每个主机都有但通常配置不一致的:SSH。你的组织可能有像“禁止基于密码的认证”这样的规则。如果没有,等到发生安全事件再议。绝不能浪费一场好危机!锁定 SSH 并确保它保持锁定状态的最简单方法是将 sshd_config 纳入集中管理。是的,每个操作系统都有自己定制的 sshd_config,因为在集成软件之前,Unix 的维护者们总要将其改造成自己喜欢的样子,但管理系统使用模板来对抗这种不卫生的行为。你可能已在上班路上睡着的时候,背诵过默认的 sshd_config,所以请确保你的管理配置与默认配置看起来截然不同。

任何想着“我把默认选项注释掉就好了”的系统管理员在看到此处时,大脑就会瞬间惊醒。

慢慢的,你就可以将大部分环境都纳入你的掌控之下。对已管理服务的更改将变得微不足道。你的同事们会看到这一点。关于更改未管理服务的讨论将变成“我们如何将这个服务纳入管理?”利用这些讨论来实施环境中的必要更改,或者为自己争取第四台更好的显示器。毁灭是一种社会构建,但通过配置管理,你可以将其转变为一层保护壳,或者是一面攻城锤。至少,你可以分享那份痛苦。

很少会提及部署配置管理,但有一个可怕的副作用:谁掌控了环境,谁就掌控了权力。任何变更都必须经过你。人们无法在那台面向公众的服务器上永久启用密码验证,但这并不意味着他们不会向你抱怨。他们会期望你参与问题解决,没人能够在变成一位问题解决高手的情况下活下来。那无法消除的声誉污点只会让你赢得公司替罪羊的称号。

幸运的是,你知道山羊意味着什么。开始放牧吧。

有关于 Michael 的问题?请发送至 。

Michael W Lucas 是 Networking for System Administrators 等多本著作的作者,他还犯下了许多其他危害人类文明的罪行。其中的专栏文章集《Dear Abyss》(亲爱的深渊)即将在 Kickstarter(译者注:美国的一间众筹平台,该文章集在 )上连载,他预谋的证据确凿。详情请访问 。

作者:SOOBIN RHO

mfsBSD 是一款基于 FreeBSD 的内存操作系统。

mfsBSD 的不同之处在于,它是完全运行于内存的 FreeBSD 实例——因此叫做 mfs(memory file system,内存文件系统)。所以,这意味着当我们在使用 mfsBSD 时,不会对现有的磁盘设备造成任何干扰。例如,我们可以将其用于本地服务器和云服务器的故障排除①。在邮件列表中搜索 mfsBSD,看看人们是如何解决各种问题的,实乃一大趣事。我个人最喜欢的应用场景是在仅有单个磁盘的设备中安装 FreeBSD,如果因某种原因无法使用 FreeBSD 安装介质,我就会:先制作 mfsBSD 镜像、将这个镜像安装到磁盘设备上、启动 mfsBSD、最后运行 bsdinstall。示例如下:

首先,构建 mfsBSD:

然后,将 mfsBSD 写入磁盘设备:

启动到 mfsBSD,然后执行 bsdinstall:

mfsBSD 能够把整个 FreeBSD 系统都加载到内存。加载完成后,就可以对原始磁盘进行修改任意了,因为现有的 mfsBSD 文件都运行在内存中。正如 Matuška 在其白皮书(2009 年)中所述,“mfsBSD 是个工具集,能创建基于 mfsroot 的短小精悍版 FreeBSD,它将所有文件都放在内存。”②

mfsBSD 的作者是 Martin Matuška([email protected])。回顾 mfsBSD 存储库的提交日志,他首次提交于 2007 年 11 月 11 日,大约是在 FreeBSD 7.0 BETA 的发布同期。“这个项目[mfsBSD]基于 Depenguinator 项目的想法”,Depenguinator 是 Colin Percival 在 2003 年创建的项目,旨在为仅提供 Linux 发行版的专用服务器远程安装 FreeBSD③。Matuška 想开发 FreeBSD 6.x Depenguinator 的功能实现,这就是 mfsBSD 的起源。

自此以降,Matuška 维护着 ,用于分发 mfsBSD 的镜像。他已经在 GitHub④ 上维护了十七年的 mfsBSD,一路修复了无数 bug,并添加了对 zfsinstall、/usr tar 压缩包的支持等。在此期间,mfsBSD 知名度不断增长,

2023 年 5 月(即此篇文章写作的前一年),这个谷歌编程之夏(Google Summer of Code,GSoC)项目开始了把 mfsBSD 集成到基本系统中的尝试。

这一切是如何开始的呢?当时,我正在阅读黑客新闻(可能我正在拖延大学作业)。这是我第一次知道谷歌编程之夏(GSoC)。那里的某条热门评论说 FreeBSD 项目也参与了。有趣的是,评论中只字未提其他事情,好像其他事情都是不言自明的。

我立刻被吸引住了。关于 FreeBSD 最令我惊讶的是:macOS 衍生于 FreeBSD,而且 Netflix 也在其 CDN 中使用了 FreeBSD。谷歌编程之夏的申请流程包括提交项目提案。原则上要求申请者从各组织的项目创意列表中寻找项目主题(除非你有自己的打算)。我看了看列表,对我来说,mfsBSD 项目最有趣,因为其他项目创意似乎比我能接受的内核开发更遥远。

在给我的导师们发了封电子邮件后,我收到了 Joseph Mingrone([email protected]) 和 Juraj Lutter([email protected])的回复,并进行了简短的 Zoom 通话。几周后,我收到了谷歌编程之夏的录取通知。然后,我们进入到了所谓的社区粘合期(community bonding period)。在这期间,所有的贡献者和导师们相聚集于虚拟会议,总共开了半个小时,所有人都进行了自我介绍。那天是 2023 年 5 月 12 日(星期五)。

三个月又二十二天,将 mfsBSD 集成到基本系统中的项目终于完成了,历经许多的反复调试(很多 Bug 是通过谷歌搜索和翻阅所有过去的 GitHub 问题来解决的),测试(使用我的两台笔记本电脑 Thinkpad T440 和 P17 来运行 shell 脚本),并且我向导师提出了许多问题。一整套的三个补丁提交到了 Phabricator⑤。

简单地说,第一个提交“mfsBSD: Vendor import mfsBSD(mfsBSD: 引入 mfsBSD)”将 mfsBSD 集成为 contrib/mfsbsd。主要提交“release: Integrate mfsBSD image build targets into the release tool set(发行:将 mfsBSD 镜像构建目标集成到发行工具集)”:在 release/Makefile 中添加了目标 mfsbsd-se.img 和 mfsbsd-se.iso(作为 release/Makefile.mfsbsd)。最后一次提交“release(7): Add entries for the new mfsBSD build targets(release(7): 为新的 mfsBSD 构建目标添加条目)”在 share/man/man7/release.7 上添加了相应的条目。这意味着,现在我们可以在构建所有 FreeBSD 安装介质(如 cdrom、dvdrom、memstick 和 mini-memstick)的同时,在相同的发行版 Makefile 中使用 make release WITH_MFSBSD=1 构建 mfsBSD。

现在,正在对补丁集进行审查。mfsBSD 之前位于 FreeBSD 发布工具链以外,仅生成 release 版本。我的设想是将这个补丁集作为基本系统的一部分,来提供 mfsBSD 镜像,并通过调用 cd /usr/src/release && make release WITH_MFSBSD=1 来构建定制 mfsBSD 镜像,然后在 /usr/obj/usr/src/${ARCH}/release/ 创建 mfsbsd-se.img 和 mfsbsd-se.iso。

①. Matuška, Martin. (2022). FreeBSD 在 Hetzner 专用服务器上——VX Weblog。[在线] 参考:

②. Matuška, Martin(2009)。mfsBSD 工具集,用于创建基于内存文件系统的 FreeBSD 发行版。[在线] 可在以下网址找到:

③. Colin Percival(2003)。Depenguinator — FreeBSD 远程安装。[在线] 可在以下网址找到:

④. Matuška, Martin(2024)。mmatuska/mfsbsd。[在线] GitHub。可在以下网址找到:

SOOBIN RHO 是南达科他州奥古斯塔纳大学的大四学生。他出生于韩国,但在迪拜长大,最终选择在美国上大学。他现在是美国合众银行网络安全部门的兼职员工。在毕业后,他将成为一名信息安全分析师。自 2023 年谷歌编程之夏以降,他一直是 FreeBSD 的贡献者。

作者:TOM JONES

译者:ChatGPT & Natsufumij

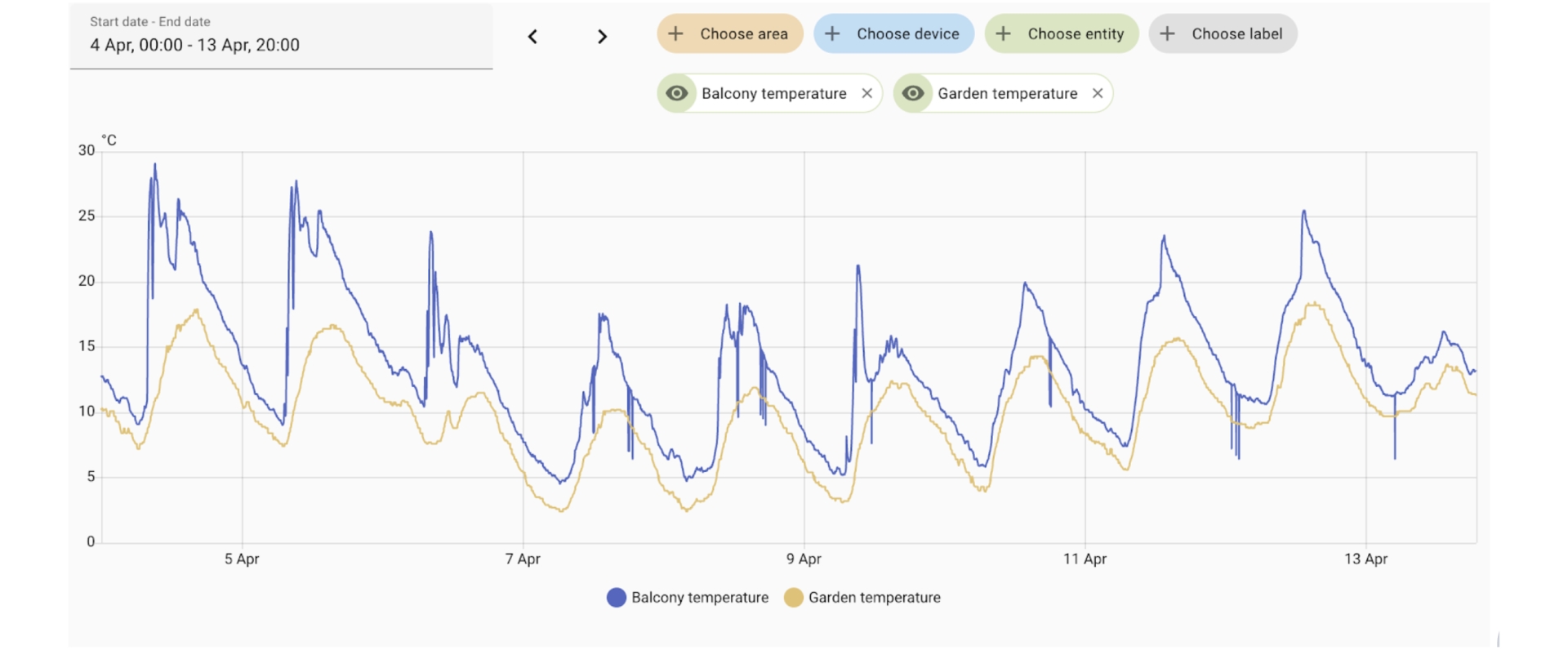

随着十月的温暖(结束),我注意到今年的第一场霜降临。我并不是在抱怨天气(这已经成为一项全民运动),秋天的到来令人愉悦。我再次可以穿上连帽衫,而阳光时而出现则是一个美好的惊喜。

在整个夏天的一个星期中,我沉浸在地球上最炎热的户外领域之一。

Chaos Communication Camp(CCCamp)是由 Chaos Computer Club(CCC,混沌计算机俱乐部)每四年在德国举办的为期五天的户外黑客节。2023 年是该活动的第七届,也是我第三次参加,(之前)分别是 2015 年和 2019 年。

黑客营地是一种难以言喻的体验,我很难准确传达出这个活动所带来的强烈力量。CCCamp 在德国北部的 Mildenberg Brick Work Park(米尔登堡砖厂公园)集结了来自欧洲和世界各地的 6,000 名黑客,共同庆祝艺术、文化、社会、环境并持续不断地打扰计算机。我们在八月中旬的五天中,都相聚在距离柏林北部约一小时的地方。

这个营地是关于技术及其对我们生活影响的讨论场所。尽管这个说法有待斟酌,但这是一个在在野外聚会和狂欢一周的绝佳借口,同时可以玩弄新旧计算机、无线电设备以及各种不同的照明系统。

演讲和研讨会按照主题分为五个地区的村庄:Bits und Baeume、Digital Courage、Milliways、N:O:R:T:X,以及 Marktplatz。Bits und Baeume 主持关于数字化、技术和环境的演讲和研讨会,位于砖厂的半路处,有一座通风的帐篷。Digital Courage 主持以德语呈现的数字权利内容,而 Milliways 则专注于安全相关内容和有关硬件的研讨会。

每个舞台都是露天场地,都设有一些迷彩网或防水布,提供阴凉和一些遮雨的地方。与前几年闷热的马戏团帐篷相比,露天场地是一大改进。尽管 EMFCamp 也使用这种帐篷风格,但英国的天气与中欧的天气有很大的不同,对于 EMFCamp 来说,这样的帐篷更加合适。

然而,露天场地的缺点是在演讲时缺乏给与会者全面庇护的设施。我曾因早早被占据的阴凉地点而放弃了几场演讲。当我们迎来了预期中的雷暴和随后的降雨时,演讲被取消并最终重新安排。

CCCamp 的内容涵盖了令人难以置信的广泛主题。你可以了解现代计算对环境的影响以及摆脱化石燃料的途径,也可以在阳光下使用海藻和盐水制作蓝晒图,或者制作用于 LORA 卫星的收发信机。如果你能在重新安排后找到的话,甚至可以学习如何重新利用“退役”的租赁电动滑板车。Puppet 展示了一场出色的表演,说明了它们接管基础软件的动作,为废弃设备赋予新生。

然而,预定的内容只是 CCC 活动发生的事情的冰山一角,很多奇迹都发生在其他地方。硬件黑客村再次现场展示了他们的硬件黑客巴士,这是一辆装满了研讨会材料和焊接电烙铁的巨大的再利用巴士。硬件黑客村每天从早上 10 点一直持续到深夜,不停地进行研讨会。这一次他们如此拥挤,以至于他们拒绝了那些“太依赖笔记本电脑”的研讨会,为他们提供了专注于拆卸和重新组装物品的空间。

到了晚上,整个场地真正变得生动起来。村庄将黑暗视为一种个人侮辱,并在活动的几十年里不断增加 LED、聚光灯和激光的武器库。太阳落山时,活动现场充满了灯光秀,各个村落通过独特的音乐表演、音箱阵列和 DJ 演出增添了会议的热闹氛围。

砖厂有一些建筑和中央基础设施被改装成令人印象深刻的照明装置。每晚,老工厂的烟囱上都会用激光写上信息。中央的“小山”(工厂里的一个旧的观测和装载站)装满了十几台巨大的烟雾机,可以用一堵烟幕覆盖 Marktplatz 周围的区域。这堵烟幕然后被激光和聚光灯照亮。穿过这个带有灯光和烟雾的地方,让你穿过一堵厚厚的墙,能见度很低,进入一个烟雾和灯光共同作用的区域,使世界增加了一层深度。

甚至在湖的中央漂浮着一个巨大的迪斯科球。

除了灯光和音乐之外,CCCamp 今年再次推出了一款活动徽章。徽章本身是一款基于无处不在的 ESP32 的全功能微控制器平台,这是一款高速双核系统,具有 WiFi 和蓝牙功能。在此基础上,徽章团队创建了一个带有大量电容触摸输入、环绕着 LED 的接口板、一个时尚的圆形屏幕、扬声器和音频输出的徽章。

今年的徽章,Flow3r,旨在成为一个音乐创作设备。过去的两次活动分别推出了一款智能手表和一款软件定义无线电。而今年,CCCamp 有意使技术更易于接近和娱乐化。徽章有两个音频输出插孔和扬声器,并附带了一些出色的音乐玩具演示。

具备这种易用性,徽章赋予了无限的创造力。Flow3r 徽章支持通过音频插孔进行 IPv6 网络连接,这是一种超越使用微控制器 WiFi 或蓝牙的步骤。

在多年来为复杂的工具链写软件的酷炫徽章的基础上,Flow3r 运行着 MicroPython。MicroPython 使得任何人都能通过 USB 串口轻松连接到设备,并开始对输入和输出进行调试和操作。我在现场看到有人写了他们的第一个程序,并让徽章上的 LED 开始播放。

这些徽章总是激发出许多酷炫的创意,而这一次也不例外。欧洲的黑客营地已经开始共同努力,确保徽章在活动结束后不会成为电子垃圾。Badge.team 创建了一个相当稳定的接口,以便在 MicroPython 中编写的软件能够在徽章之间轻松移动,并且有一个应用商店可以方便地安装他人制作的应用程序。在默认固件中,有一个显示名字的应用程序,夜晚你可以看到数百人戴着徽章走来走去,显示着他们的名字。此外,你还会看到其他一些非默认的显示名字的应用程序,这是那些写了自己的显示名字应用程序或者下载了他们认为很酷的应用程序的人。

这是我第三次参加由 CCC 主办的户外营地活动。当活动每四年进行一次时,你会在结识的人群中产生一种奇怪的步调。不知何故,我们竟然能在短短的 5 天内建立坚固的友谊。随着这次是我第三次参与,我正在第三次与 2015 年在我第一次营地相识的人们见面。不知何故,我们已经认识彼此整整 15 天,但在 8 年的时间里,却建立了一种非常牢固的友谊。我结识了朋友的新伴侣,听说了他们的孩子,还有机会将老朋友介绍给我的妻子,因为这是她第一次体验德国的露天活动。

在筹备婚礼这繁忙的夏天之后,CCCamp 成为我稍微放松的机会。我尽力避免组织活动,但计划赶不上变化。通过 Fediverse 的一位朋友帮助我主持了来自 MNT Reform 项目(/)的 Lukas 的展示活动,展示了他所构建的开源 Arm64 笔记本电脑。这对许多人来说是第一次尝试这款笔记本,并预览了即将推出的 7 英寸口袋款(如果你的口袋够大的话)笔记本电脑。首批设备预计将于 2024 年初发货,但原型硬件非常出色,可以用来调试各种问题。

由于无法抑制我“那个苏格兰人”的声望逐渐增长,我最终成为了一场威士忌品酒活动的主持人。但正如我所了解的,我会抓住任何机会向人群传递苏格兰诗歌。这一次,我朗读了彭斯的一小段,站在台上,大约有一千人热切地举着手等着我读这位诗人的几行诗。

"为了歌唱你的名字!"

在旅行报告中,我经常会反复强调活动的价值难以事后向他人言语。我可以夸赞所发生的事情,但我不确定在路边的快闪展台上填写奥地利投诉表格的体验是否真正得以传达。他们的填写系统确实给人一种很像碎纸机的感觉。

对我来说,CCCamp 2023 的主角是酷热。德国经历了一场酷热的夏季,老实说,如果在我写这篇文章之前问我有关这个活动的看法,那可能就是我唯一会谈论的话题。当然,我的遮光帐篷帮助我多睡了一会儿,而躲在一个人工通风的阴凉处则帮助我坐下来为徽章写一个无聊的应用程序。

这场酷热创造了一些我没有经历过的新体验。

第四天,为了避免被烤熟,我独自一人在湖中游泳时,碰巧遇到了一艘充气艇,上面坐着一些 EMFCamp 的人。他们邀请我上船,我设法(只是稍微让他们的船漏了一点水),我们在湖上荡来荡去,一边分享着罐装的杜松子酒和汤力水(一种饮料,译者注)。

这种经历我想一定只有参加我们的活动才会感受得到。

TOM JONES 是一个关注保持网络堆栈敏捷性的 FreeBSD 提交者。

作者:Christopher R. Bowman

在之前的两篇文章中,我们讨论了我一直在实验的 Digilent Arty Z7-20 开发板。我觉得这是一块很有趣的开发板,因为它不仅可以切换主要引脚与外界进行接口,而且你还可以将自己的电路集成到开发板中,并将其与处理器进行接口。然而,要做到这一点,你需要使用 Xilinx/AMD 的软件来配置和编程芯片。Xilinx 将这个工具套件称为 Vivado,你可以从他们的网站上 免费下载 一个适用于 Zynq 芯片的版本。

那么,缺点是什么呢?肯定有什么潜在的问题,对吧?其实有两个问题。首先,Vivado 只有 Windows 和 Linux 版本。其次,下载的文件本身就有 110GB。多年来,我在 Mac 上通过 VMWare 运行 Linux 版本,效果还不错。但最终,我的虚拟机有好几个不同版本,每个版本的软件安装情况都不同。这些虚拟机非常大,早期的版本大约是 30GB,最近的一些安装版本甚至达到了 75GB。假设在几台机器上有几个版本,那么总空间开始变得非常庞大,而且我也很难追踪哪个版本是最新的。

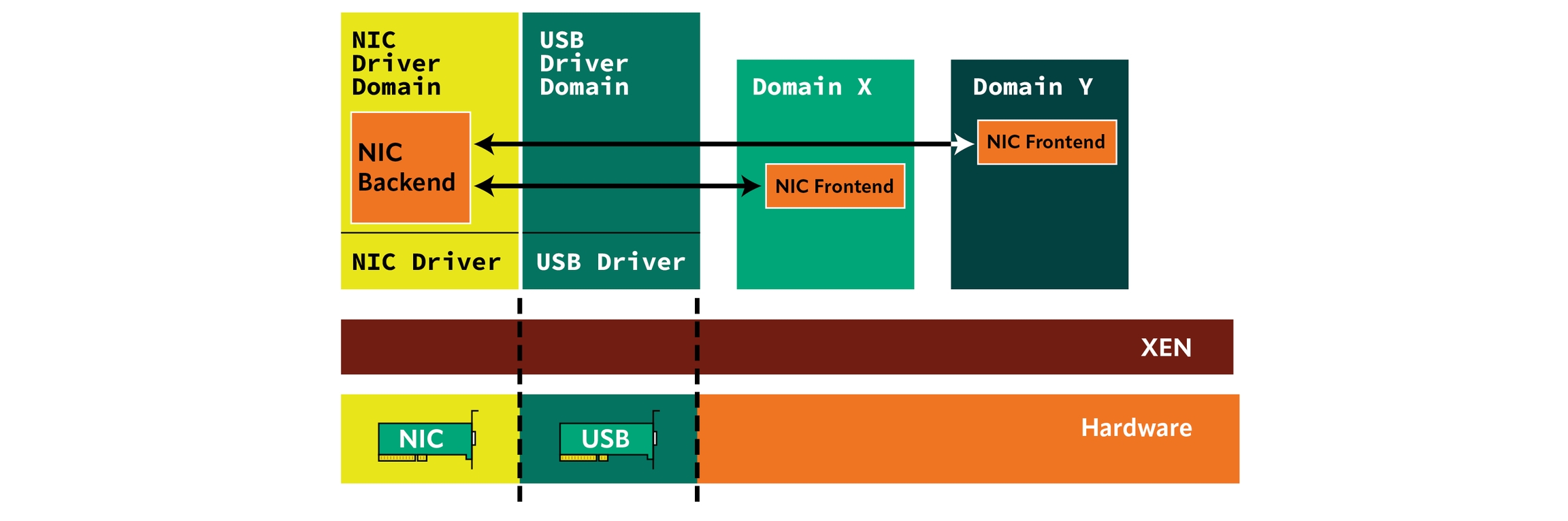

于是,我决定简化并集中管理。我希望将所有下载的原始厂商工具存储在我的网络文件服务器上,这台服务器自然运行 FreeBSD,拥有数 TB 的 ZFS 存储空间。毕竟,我不能依赖于厂商继续提供这些旧版本的工具,尤其是在他们更新到新版本后。这是可以理解的,但作为一个爱好者,我的工作进度并不总是与厂商的进度同步,因此我希望确保能够保留原始工具下载文件。我希望我的主目录以及我的工作文件和项目都存储在我的网络服务器上,这样它们可以从我所有的机器上访问,并像任何其他数据一样进行备份。我希望所有解压并安装好的厂商软件都存储在我的文件服务器上,而不是存放在我的虚拟机里。这样,我可以利用 ZFS 的强大功能对厂商软件安装进行检查点保存。我的虚拟机只是一个轻量级的 Linux 安装,任何我想要实验的 Linux 版本。如果我需要升级或创建新的虚拟机,我知道里面没有任何工作内容,所有东西都在我的文件服务器上,所以我只需要安装一个新的基本系统,其它所有内容仍然保存在文件服务器上。我无需复制或重新安装厂商工具。由于最近我家计算环境的升级包含了一台 16 核 128GB 内存的 FreeBSD 机器,我希望在这台机器上运行这些工具,以应对我的设计规模变大,可能需要数小时来合成的情况。作为额外的好处,我得到了一个设置,其他人如果想要复制我的工作,只需要一台 FreeBSD 机器即可。

目前似乎有两种基本的方法。我可以尝试让安装程序在 FreeBSD 的 Linux 仿真环境下运行,并在我的 FreeBSD 机器上本地运行这些工具,而不需要 Linux 虚拟机。如果能够实现,那将是非常棒的!但我不确定是否能做到,也不清楚可能会遇到哪些问题,或者需要多长时间才能弄明白,而我当时正处于几个项目的中间。这个方法看起来确实是最好的,我很想知道是否有人已经成功实现,或者有谁想尝试,但我选择了一个我认为会涉及较少工作量且更有可能成功的方法。我听说过 bhyve,决定进行调查。如果我能运行一个支持 Vivado 的 Linux 版本的虚拟机,我认为那将是最简单的。只用了一个晚上阅读和另一个晚上实验,我就惊讶地成功运行了。

我从 FreeBSD 手册开始。它真的是一个很棒的资源,感谢所有帮助使其如此出色的人。 对如何使用 FreeBSD 作为主机操作系统做了很好的介绍。在大多数情况下,我从那里和互联网上的其他一些地方拼凑出了一个设置。为了设置,我创建了网络的基本主机配置:

我正在使用中的说明,因为我不想麻烦地设置 grub。使用 UEFI 帧缓冲还允许我通过 vnc 导出 Linux 显示。如果我使用 FreeBSD 主机,或者从网络上的任何其他机器,都可以连接。不过,也许我应该再考虑一下安全性问题。

我下载了一个 CentOS 的 ISO 版本,是在 RedHat 终止它之前的版本,然后我使用以下虚拟机配置进行安装:

通过这种方式,我得到了一个 4 核心、32GB 的虚拟机,ISO 镜像 /u1/ISOs/CentOS/CentOS-7-x86_64-DVD-2009.iso 被挂载为客户机中的 CDROM。这样,我可以运行一个标准的图形界面安装 Linux,过程非常直接。我是在裸 zvol 上运行的:/dev/zvol/zroot/vms/centos7。这样做是为了我可以使用 ZFS 快照随时对虚拟机进行快照(最初是在干净安装后),以便随时回滚。如果我将虚拟机虚拟磁盘放在 ZFS 文件系统上,快照会应用到该文件系统中的任何内容,而不仅仅是虚拟机虚拟磁盘映像。我还听说使用裸 zvol 可能更快。回想起来,我本可以为每个虚拟机虚拟磁盘映像使用一个单独的数据集,并在该数据集上使用文件作为虚拟磁盘映像,而不是使用 zvol。如果每个虚拟机有一个数据集,快照仍然只会应用于虚拟机。我不确定哪种方法更好,随后的阅读让我对 zvol 与文件支持的速度产生了疑问。我的工具运行时间还不长,因此我还不太关心每一分性能的提升。我还听说,对于支持的客户操作系统,NVMe 设备比 AHCI 硬盘设备更快,但我还没有进行实验。如果这个问题变得严重,创建一个新的虚拟机就很容易了,因为我的数据和安装并不依赖于虚拟机。

安装了 CentOS 后,我配置它通过 NFS 挂载我的 FreeBSD 机器上的主目录,然后我进行了 Xilinx Vivado 工具的安装。这是一个图形界面的安装,过程很简单。我只需要确保安装路径是 NFS 挂载的目录。考虑到文件操作的量,我原本预期这个过程会非常痛苦,但实际上它相当快,尤其是考虑到安装后工具的体积达到了 66GB。要知道,我有一个非常快速的本地网络。我不打算编辑工具的安装,但是我创建了一个快照——这也是为了安心。我不想再重复安装一次。

当我申请 Vivado 许可时,我复制了 Linux 客户机报告的以太网 MAC 地址。这个地址似乎在重启时保持稳定,但我希望能弄清楚如何配置它,以确保我的虚拟机中的 MAC 地址始终与 Vivado 许可中的 MAC 地址匹配。

现在,我有了一个相当通用的 CentOS 虚拟机,安装了 Vivado,可以通过 VNC 从我本地网络上的任何机器访问。到目前为止,我还安装了一个 15 年前的 Linux 版本的《文明:天赋神权》(Civilization: Call to Power),以便在我的 FPGA 构建编译时玩。这让我惊讶于它运行得多么流畅(以及我有多么上瘾)。

尽管大部分功能都运行得很好,但与我之前在 Mac 上使用 VMWare 的设置相比,还是有一些不同之处。首先,VMWare 支持将文件系统传递到主机。NFS 挂载基本完成了相同的功能,我没有注意到太多的速度惩罚,但我必须在 Linux 中配置,而不是在 VMWare 的图形界面中配置。这不是一个大问题——我对此非常适应。真正让我希望能有 VMWare 解决方案的地方是复制和粘贴。如果我在 Linux 客户机的图形界面中选择了一些内容,我无法轻松地将其复制并粘贴到运行 VNC 查看器的机器上。这偶尔是个痛点,但由于我在 Linux 中使用的用户文件系统都是从 FreeBSD 挂载的 NFS,我可以像从 FreeBSD(或任何其他挂载它们的机器)一样轻松编辑这些文件。因此,我几乎不在 Linux 下进行编辑或工作。大部分时间,我只是在 Linux 的 VNC 会话窗口中运行 Vivado 编译,其他所有工作都在外面进行。总体来说,这个方法还是相当有效的。

在下期文章中,我们将开始使用 Vivado 构建我们的第一个电路。

如果你对这些内容有反馈、抱怨或批评,我很乐意听到你的声音。你可以通过 联系我。

Christopher R. Bowman 自 1989 年在约翰霍普金斯大学应用物理实验室的 VAX 11/785 上首次使用 BSD 以来,一直在使用 FreeBSD。他在 90 年代中期使用 FreeBSD 设计了自己在马里兰大学的第一个 2 微米 CMOS 芯片。从那时起,他一直是 FreeBSD 的用户,并对硬件设计及其驱动的软件非常感兴趣。他在半导体设计自动化行业工作了 20 年。

原文链接:KDE CI and FreeBSD

作者:Ben Cooksley

自 2011 年 8 月以降,KDE 就开始实施 CI(Continuous Integration,持续集成)系统,且持续改进着。自此,系统已经大幅演进,增加了对多个 Qt 版本(大多数 KDE 软件所使用的工具包)以及多个平台的支持。

得益于容器的普及,能在多个操作系统上可靠地运行所有这些构建。为了理解容器解决了哪些问题以及 CI 系统可扩展性中的挑战,我们需要回顾 KDE CI 的起点。

系统起初由简单的 Jenkins 配置——在同一服务器上进行构建。然而,随着更多项目接入,构建需求增加,需要更多的机器。

这带来了一个难题:KDE 软件的构建需要其他 KDE 库——通常是最新版本的。这意味着仅增加构建机器是不够的,还需要确保最新的依赖项始终可用。

由于构建应用程序所需的全部依赖项链时间较长,因此无法每次重新构建全部内容,这就需要共享构建产物。经过快速评估,选择了 rsync,它使系统运作良好。

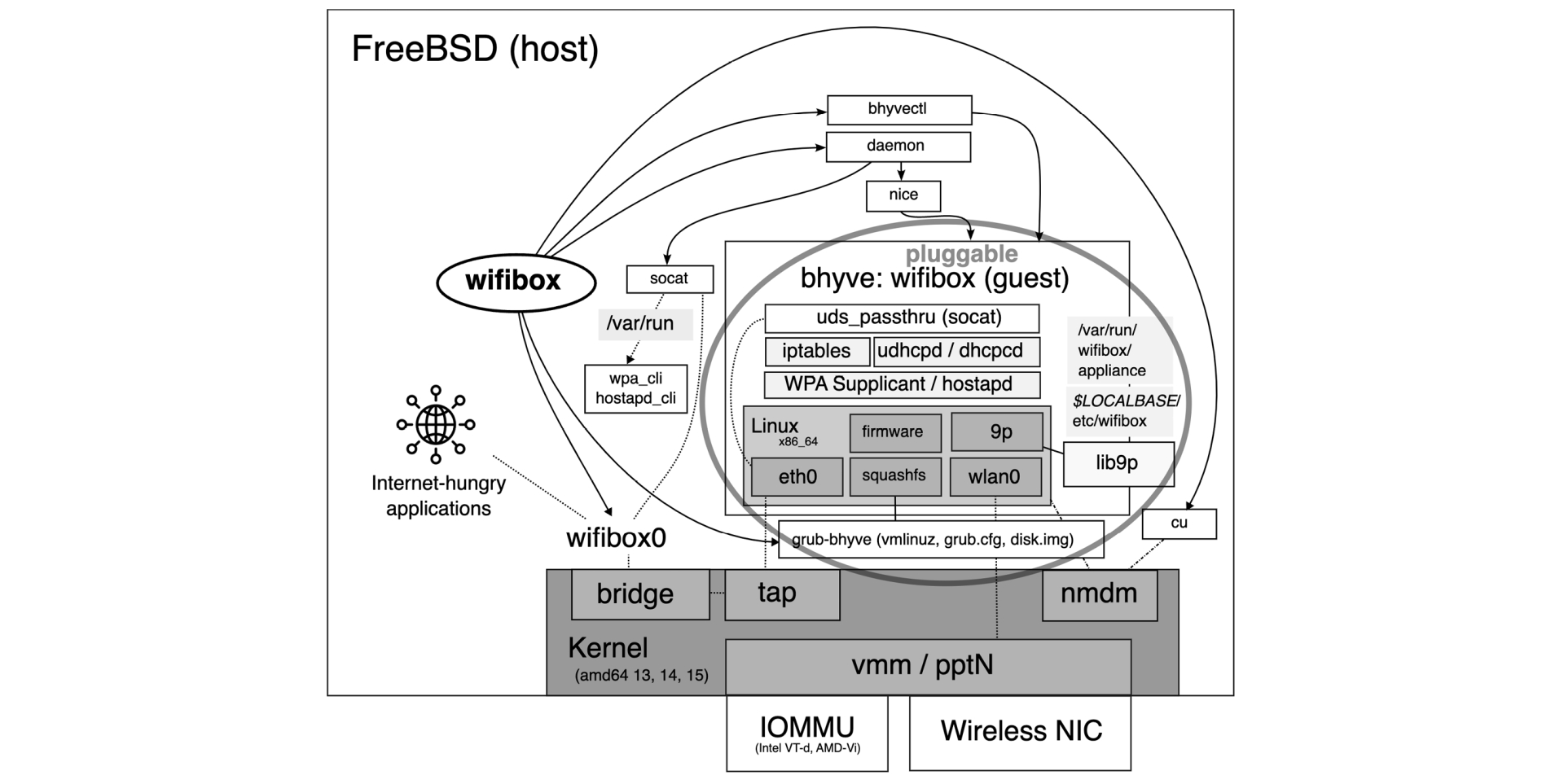

到 2017 年,CI 系统需要支持新的平台,于是系统中加入了 FreeBSD。FreeBSD 的早期支持较为简单,在 Linux CI 工作节点上采用虚拟机运行。每台虚拟机单独配置,包含构建 KDE 软件所需的所有依赖项。

虽然这种方法确保了 KDE 软件在 FreeBSD 上的可靠构建,但系统的扩展性较差,因为需要逐台更新构建器。这一方法成功地保证了 KDE 软件在 FreeBSD 上的构建可靠性,也改善了 FreeBSD 上 KDE 团队的开发体验。

在添加 FreeBSD 支持的同时,我们还在 Linux 构建中引入了 Docker。能够首次创建一个可在所有构建器中分发的主配置,方便了 CI 系统的变更发布,标志着基于容器的构建时代的开始。唯一的缺点是 Docker 仅适用于 Linux,如何在其他平台上再现这一流程成为一个问题。

随着构建能力的扩展,出现了一些新问题。构建偶尔会随机失败,日志显示文件缺失和符号链接损坏,但随后检查发现文件存在,之后的构建可顺利完成。问题在于:原子性(Atomicity)。

在新硬件下,构建速度加快,增加了 rsync 在文件上传时,而另一个构建节点下载构建产物的概率。解决方案是使用 tar 包的构建产物,以原子操作发布完整的文件集。此方法与 SFTP 协议(用于不支持 rsync 的平台)结合,CI 系统恢复了稳定运行,资源和支持平台也有所增加。

但手动维护机器的问题仍然存在。迁移到 Gitlab 和 Gitlab CI 后,构建节点由于累积的代码检出和构建产物迅速耗尽磁盘空间,测试留下的进程也会占用 CPU。而 Linux 上的 Docker 构建不存在这些问题。

我们探讨了多种解决方案,如改进 Gitlab Runner 的“shell”执行器、清理构建产物的 cron 作业,以及基于 FreeBSD Jail 的解决方案,但均无法复现 Linux 上 Docker 的体验。

某天早上,我们在研究 FreeBSD 的容器化选择时偶然发现了 Podman 及其搭档 ocijail。这正是我们在基于 Docker 的 Linux 设置中习惯的功能,但现在能在 FreeBSD 上实现了。

这意味着之前遇到的残留进程和需要手动清理的构建产物问题都能得以解决。此外,我们还可以利用标准的 OCI(Open Container Initiative,开放容器计划)注册表(例如 Gitlab 内置的容器注册表)来把 FreeBSD 镜像分发到所有构建器上,从而解决了单独维护每台机器的问题。

首要困难是构建一款能用的镜像。对于 Linux 系统来说,Docker 和 Podman 非常成熟,有详细的文档说明基础镜像及其包含内容。但在找到适合的 FreeBSD 基本镜像后,我们以为只需添加 FreeBSD 包仓库,安装所需软件包即可。

然而,在容器中首次构建时,CMake 报告无法找到编译器。我们认为这很奇怪,因为 FreeBSD 系统通常预装了编译器。经调查,我们发现 FreeBSD 容器与正常的 FreeBSD 系统的主要区别在于:容器经过大幅精简,默认未包含编译器。

经过数次迭代,我们添加了编译器和 C 库开发头文件,从而在 FreeBSD 容器中成功构建了首款 KDE 软件。虽然我们认为一切顺利,但后续构建依然失败,因为需要额外的开发包。经过多次迭代和安装更多 FreeBSD 软件包后,我们终于完成了多个关键 KDE 软件包的构建。

接下来我们将注意力转向 Gitlab Runner 的“辅助镜像”,用于执行 Git 操作和上传构建产物到 Gitlab。尽管可以在 FreeBSD 上运行 Linux 二进制文件,但我们希望能在 FreeBSD 上原生构建。仿照 Gitlab 的方法构建镜像后,顺利得到了预期的结果。

冒险之旅的乐趣部分开始了:深入 Gitlab Runner 和 Podman 的内部机制。首次将 Gitlab Runner 连接到 Podman 时,构建遇到报错“unsupported os type: freebsd”。

在 Gitlab Runner 代码库中发现,Docker 需要检查远程 Docker(或在我们的例子中是 Podman)主机的操作系统类型。我们对 Gitlab Runner 进行了补丁和重建,解决了此错误,但紧接着又出现了类似的报错:“unsupported OSType: freebsd”。进一步修补后,又遇到一个更严重的错误,尤其是使用 Go 语言编写 Gitlab Runner 时:

显然,要使该功能正常工作需要进行更多修改,但由于容器化构建的潜力,我们继续研究该问题。最终,我们找到了导致失败的代码:

我们发现 Podman 的守护进程崩溃,从而中断了请求。这个问题可以通过尝试运行 podman inspect 进行复现。原因归结为专门用于“inspect”操作的代码调用了 Linux 专用的构造。经过又一次补丁后,我们的 podman inspect 不再崩溃,终于成功启动了第一次 FreeBSD 构建。

首次构建仍然失败(由于 Gitlab Runner 与非 root 用户的容器交互的已知问题),但我们在 FreeBSD 上已成功运行了构建。

你可能以为此时我们可以为所有 KDE 项目推行基于 FreeBSD 的容器化构建了。然而,最终测试发现 FreeBSD 容器的网络速度远低于预期,与 FreeBSD 主机相比明显较慢。

幸运的是,这个问题不是新问题。我们预计会遇到此问题,原因是大型接收卸载(LRO)。简单地更改配置后,最终我们达到了预期的性能,可以投入生产。

今天,KDE 使用 Podman 和基于 ocijail 的容器来运行 FreeBSD CI 构建,有 5 台 FreeBSD 主机处理构建请求。构建中使用了两台不同的 CI 镜像——分别适用于 Qt 5 和 Qt 6 的版本,确保 KDE 软件可以从零开始构建,并可选地通过所有单元测试。

自从从 FreeBSD 专用虚拟机迁移到 FreeBSD 容器化构建后,我们从每周甚至每日对构建器进行维护,逐渐减少到每隔几周维护一次,几乎没有收到开发人员的投诉。

我们已成功向上游了我们提交编写的补丁,现在所有人都可以使用这些补丁构建自己的 CI 系统。

容器化的优势——尤其对持续集成系统来说——不可低估。所有维护系统的团队都应考虑容器化,尽管初始的迁移成本较高,但回报非常值得。

Ben Cooksley 是一名会计师和计算机科学家,因其在 KDE 社区的贡献而闻名,尤其是在系统管理和基础设施方面。他对系统管理的兴趣源于对系统运作和集成的好奇心。

作者:Roller Angel

ZFS 原生支持加密数据集,能让你轻松地使用行业标准的密码套件来保护数据。与磁盘的全盘加密相比,将数据集加密的主要优势在于,当未使用数据集时,可以将其卸载,而全盘加密要求在静止状态下加密时,磁盘必须关闭。请记住,ZFS 原生加密有加载和卸载密钥的概念。仅仅卸载加密的数据集是不够的,你还必须卸载与该数据集关联的密钥。如果密钥仍然处于加载状态,数据集可以被挂载并且数据将可用。卸载密钥会使挂载操作失败。加载密钥是挂载数据集的前提。嵌套的子数据集会继承其父数据集的加密密钥,但这并非必须。即使父数据集使用不同的加密设置,也可以使用不同的加密密钥和密码套件。最后,更改密钥就像在数据集上执行 zfs change-key 命令一样简单。

这些是开始使用的基础概念。

为新创建的数据集启用加密参数,再设置密钥格式就足够了。如果未指定加密密码套件,则默认使用 aes-256-gcm。默认值可能会随着未来新增密码套件而变化。现有数据集的加密属性是只读的,无法修改未加密的数据集的属性来启用加密。要指定加密属性,你需要了解有哪些参数可用。我建议阅读 zfsprops 手册页,你可以输入命令 man zfsprops 来查看。我还建议阅读 zfs-load-key 的手册页。对于我们的第一个加密数据集,我们将使用默认的密码套件、口令密钥格式,来创建一个名为 secrets 的数据集。我使用的是我实验室中创建的 FreeBSD jail 机器,名为 alice。实验室中的所有 jail 都位于名为 lab 的 zpool 上。我已将叫 zroot 的 zpool 分配给 jail。在 jail 中,我必须使用完整路径 lab/alice/zroot 作为 zpool 名称,以便在其中创建数据集。作为对比,我的笔记本电脑上,我可以直接使用我的 zpool 名称并在那里创建数据集。以下是创建加密数据集的命令,适用于 alice jail 和我的笔记本电脑。同其他 ZFS 数据集一样,设置挂载点是一个好主意,但请记住 ZFS 是个分层文件系统,因此不要使用现有路径作为新数据集的挂载点。

alice jail:

我的笔记本:

在运行 zfs create 命令后,提示我输入一个足够长的口令。现在,我有了一个已挂载的加密数据集,可以在其中存储需要保护的数据。当数据集处于挂载状态时,我可以像使用其他未加密的数据集一样使用它。当我完成机密数据的添加后,我可以通过输入命令 zfs unmount -u lab/alice/zroot/secrets 一次性卸载数据集和密钥。要解密、重新挂载数据,只需运行命令 zfs mount -l lab/alice/zroot/secrets。这会提示我输入口令,加载密钥,然后挂载数据集。如果在卸载命令中省略参数 -u,只会卸载数据集,密钥仍然会保持加载状态。数据集仍然可以通过 zfs mount lab/alice/zroot/secrets 挂载,而无需输入口令。要在数据集已卸载后卸载密钥,我运行 zfs unload-key lab/alice/zroot/secrets。现在,之前的挂载命令将失败,因为密钥没有加载,并且我未提供参数 -l 来让 ZFS 在挂载之前加载密钥。要加载密钥且允许挂载数据集,我会运行 zfs load-key lab/alice/zroot/secrets。系统会提示我输入口令,之前的挂载命令现在会成功,因为密钥已经加载。要检查密钥是否已加载,可以查看数据集的属性。当我运行命令 zfs list -o name,mountpoint,encryption,keylocation,keyformat,keystatus,encryptionroot lab/alice/zroot/secrets 时,会显示一些有用的属性。KEYSTATUS 列显示为 "available" 时,表示密钥已加载。要查看所有数据集属性,可以使用 zfs get all lab/alice/zroot/secrets

接下来,我在 secrets 数据集下创建一个嵌套的数据集,并使用不同的密码套件和密钥格式。这次,我将使用密钥文件而非口令。要创建使用密钥文件的数据集,我首先需要生成密钥并将其存储在文件中。我通过输入命令 dd if=/dev/urandom bs=32 count=1 of=/media/more-secrets.key 来完成。由于密钥文件要求长度为 32 字节,因此我使用了 bs=32。输出路径选择 /media,因为我在此路径下挂载了一个便携式 USB 驱动器,还使用 dd 命令生成了密钥文件,再将其直接存储到驱动器上。这样,当我卸载密钥并卸载和移除 USB 驱动器时,密钥文件就不会留在我的机器上。我建议将密钥文件存储在多个 USB 驱动器上,以防某个 USB 驱动器损坏。现在,密钥文件已经生成,我可以通过运行命令 zfs create -o encryption=aes-256-ccm -o keyformat=raw -o keylocation=file:///media/more-secrets.key -o mountpoint=/secrets/more-secrets lab/alice/zroot/secrets/more-secrets 来创建使用 AES-256-CCM 密码套件的嵌套数据集。查看这个新数据集的属性时,我可以看到 ENCROOT 列设置为 lab/alice/zroot/secrets/more-secrets。我可以使用与 secrets 数据集相同的方法来卸载和卸载密钥。当我拥有更多数据集和密钥时,我可能想考虑使用 zfs unload-key -a 卸载所有密钥,或使用 zfs unload-key -r lab/alice/zroot/secrets

如果我后来决定 more-secrets 数据集中的数据不需要单独的密钥文件,而是希望它继承父数据集 secrets 的设置(即从自定义生成的密钥文件切换到之前配置的口令),我只需要运行命令 zfs change-key -i lab/alice/zroot/secrets/more-secrets。再次查看属性,注意到 ENCROOT、KEYLOCATION 和 KEYFORMAT 都已经发生了变化。然而,密码套件不会改变,因为密码套件只能在数据集创建时设置。由于 more-secrets 是包含在 secrets 中的,它将作为卸载 secrets 数据集的一部分被卸载。虽然挂载 secrets 数据集不会自动挂载 more-secrets,但它需要单独挂载。不过,由于它们共享相同的密钥,所以密钥只需要加载一次。要切换回使用密钥文件,我运行命令 zfs change-key -o keyformat=raw -o keylocation=file:///media/more-secrets.key lab/alice/zroot/secrets/more-secrets。如果我想永久销毁 more-secrets

最后,我想分享的一点是关于加密数据的备份。如你所见,ZFS 原生加密能轻松地使用加密来保护数据。加密数据集的快照可以以加密形式传输到不受信任的备份服务器上。没有密钥,远程备份服务器就无法挂载该数据集。可以使用 zfs send 命令的参数 --raw 来实现这一点。有关更多细节,我建议阅读 zfs-send 的手册页,以了解其工作原理,然后获取《ZFS Mastery: Advanced ZFS》一书,深入研究具体细节,并学习一系列技巧,以进一步提升你的 ZFS 技能。

希望你喜欢这篇操作指南,并且开始使用 ZFS 文件系统提供的原生加密来保护你的敏感数据。

Roller Angel 大部分时间都在帮助人们学习如何使用技术实现他们的目标。他是一位热衷于 FreeBSD 系统管理的 Python 爱好者,喜欢学习开源技术(尤其是 FreeBSD 和 Python)解决问题的神奇方法。他坚信人们可以学习所有他们愿意去做的事情。Roller 总是在寻找创造性的解决方案,享受解决问题的挑战。他有很强的学习动机,喜欢探索新想法,并保持技能的敏锐。他喜欢参与研究社区,并分享自己的想法。

原文链接:

作者:Benedict Reuschling

在疫情最严重的时候,我一直待在家里,日子基本上和其他日子没什么区别。时间过得很慢,环顾四周,我意识到我的房间变得相当凌乱。尤其是我的工作桌旁,堆积的书籍、笔记、信件和其他纸张已经开始争相堆到桌面上。我决定做点什么。我戴上耳机,开始整理、归类、扔掉,并清理到我的桌面变得整洁。这种成就感在全球危机时期格外强烈。受到这一感觉的激励,我决定开始扫描那些纸张,减少堆积的纸张数量。

我几个月前买了一台移动扫描仪,它通过 USB 连接,并使用一些专有但高效的扫描软件。这个扫描仪的大小不亚于一个擀面杖,能够扫描一张纸。由于当时有时间,我开始一张一张地扫描每张纸,为每个生成的 PDF 添加描述和日期,然后继续扫描下一张。虽然这很繁琐,但最终我完成了。之后整理这些文件又是一个漫长的任务:税务、保险、合同、收据、账单(包括已发送和已收到的)、记录、证书等,都需要放入正确的目录中。

但扫描软件只有 32 位,几年前整个扫描设备停止工作了——恰好在另一堆纸差点要倒塌的时候。于是,是时候寻找替代方案了。几个月前,我发现了 textproc/py-ocrmypdf。这款软件本质上是重新扫描 PDF 并将文字从图像中提取出来,使其成为可以提取和搜索单个单词的文本。它通过模式识别来识别单词和语言,结果出奇的好。我将其应用于现有的扫描文件,现在我可以对文档进行全文搜索,找到例如我参加 BSDCan 2014 时的机票费用等信息。

原文链接:

作者:Randall Stewart、Michael Tüxen

TCP 大型接收卸载(TCP Large Receive Offload,TCP LRO)是一种特定于协议的方法,用于降低接收 TCP 段(TCP segment)时所需的 CPU 资源。它也是实现特定的,本篇文章介绍了它在 FreeBSD 内核中的实现。在任何给定时刻,TCP 通常用于单向通信,尽管 TCP 提供了双向通道。例如,当使用 TCP 作为传输协议的应用协议是请求/响应类型(如 HTTP)时,即是这种情况。

TCP LRO 可采用多种方式降低所需的 CPU 资源,包括:

合并到达确认(acknowledgment,ACK),向 TCP 栈发送单个大的扩展 ACK,而非多个较小的 ACK。适用于 TCP 端点主要发送用户数据的情况。

原文:

作者:Tom Jones

几年前,我们深受敬重的前 FreeBSD 期刊编辑委员会成员 Kristof Provost 写过一篇关于理想 Bug 报告方式的好文章。遗憾的是,Michael W Lucas 总会在年初就用光我们每期讽刺的额度,所以为了避免“讽刺透支”,决定由我改写 Kristof 的原文,以免出现“反讽破产”。

每个系统维护者都有自己偏好的 Bug 报告与改进请求接收方式。由于 Kristof 是 FreeBSD 中 pf 开发的核心人物,他正是为期刊撰写这篇文章的理想人选。

在被要求改写原文时,Kristof 的回应是:

“我无法在完美的基础上再做改进。”

因此,我来重述 Kristof 的原话,并给你一些入门建议,帮助你更快地整理出最重要、最棘手的 Bug。你可以在这里找到他的博文:。

作者:CHRISTOPHER R. BOWMAN

原文链接:

我已使用了近三十年的 FreeBSD。最开始,在上世纪九十年代初我安装了 FreeBSD,因为我能够非常轻松地用它的软件包系统,来安装当时用于设计首批硅芯片所需的免费 CAD 软件版本(译者注:freeCAD 诞生于 2001,时间不符,此处不是 freeCAD),其精度高达 2 微米(即 2000 纳米,这里不是错别字)。不必自己配置编译 3-4 个软件包,这意味着我在一个晚上就可以安好系统,然后在家里的地下室进行芯片设计。在那之前,我需要驱车赶往大学,然后每天在昂贵的 Sun 工作站上花费数个小时工作到深夜。现在我在家就能完成所有工作,而且工具的运行速度更快!虽然我会编程,但我一直把 FreeBSD 用作计算基础,从未参与过社区开发。现在,我想要用 FreeBSD 做一些东西,而不仅仅是用 FreeBSD 完成我的工作。

市面上有大量的小型嵌入式板,其中某些享有极高的声誉——比如树莓派及其各种衍生版本。对我而言,这些小型嵌入式板最有趣的地方,就在于它们能够与外部世界进行接口通信。这样的小板大都带有从 CPU 引出的 GPIO 引脚,因此可以与各种真实世界的东西进行交互。但我本质上是一名硬件工程师,我真的很想做硬件。虽然我的职业发展还不错,但我仍然没有那几百亿美元去建立自己的晶圆厂,或者花费数百万美元去购买电子设计自动化(EDA)软件来设计自己的芯片。如果你想要制作自己的,现在有一些有趣的项目,但我在找到它们之前就走上了这条路。我一直在想,我的确可以购买树莓派或其他一些出色的板子(比如 Arduino 等),但我会用它们做什么呢?因此,我不断地阅读有关这些板子的资料,但从未尝试过。最后,我找到了适合我的板子。

原文:

作者:ED MASTE

译者:ykla【】为译者注

FreeBSD 起源于 386BSD,而且在最初仅支持一种 CPU 架构,即英特尔 80386。对第二种架构 DEC Alpha【是由迪吉多公司开发的 64 位 RISC 指令集架构微处理器】的支持在 FreeBSD 3.2 中被加入的,接着是对 64 位 x86(amd64)的支持。支持等级的概念尚未完全确定,但 amd64 在 2003 年被提升为一级支持状态。64 位的 ARM 架构 AArch64(也称为 arm64)在 2021 年获得了一级支持的地位。我们将探讨这意味着什么,以及我们是如何实现这一步的。

在 FreeBSD 中引入新的一级支持架构是份具有挑战性的任务,它需要大量的努力,以确保该架构得到充分支持、稳定、高性能,并且与现有的 FreeBSD 生态系统兼容。

# 现在正在对将 mfsBSD 集成到基本系统中的补丁集进行审查,可在网址查看:

# https://reviews.freebsd.org/D41705

cd /usr/src/releasemake mfsbsd-se.img

# 此处 se 是指 mfsBSD 特别版本(special edition),它包含了

# dist 文件——即 base.txz 和 kernel.txz:bsdinstall 需要它们

cd /usr/obj/usr/src/${ARCH}/release/ls -lh# 把 mfsBSD 安装到你的目标磁盘设备上

# 把 ada0 换成你自己的目标磁盘设备

dd if=./mfsbsd-se.img of=/dev/ada0 bs=1Mreboot# 复制特别版本(special edition)的 dist 文件,以便 bsdinstall 用其进行安装。

mkdir /mnt/distmount /dev/ada0p3 /mnt/dist

mkdir /usr/freebsd-distcp /mnt/dist/<version>/*.txz /usr/freebsd-dist/bsdinstallBackup Station:由 Mike Jurbala 于 2022 年 9 月引入,它是一款图形化软件,使用 pybectl,这是一款与 bectl 接口的内部 Python 模块,用于管理 Boot Environments。简化系统快照操作。

GBI 和 pc-sysinstall:GhostBSD 的图形安装器最近在界面中去除了 UFS,转而利用 ZFS 的优势。ZFS 的强大优势超越了旧的方式。

是否协商了窗口缩放、时间戳和 SACK 支持。

精确的 ECN 状态。

额外的 IP 层信息。

不可见 SYN RECEIVED 状态下的 TCP 端点。

不支持 IP 层信息。

BSD Now 始于 2013,由 Allan Jude 和 Kris Moore 主持。当时我还是名普通听众,兴奋地等待收听 BSD 领域的最新消息。随着时间的推移,BSD 领域迅速变成了“BSD 之地”,正如 Kris 曾著名地说过的那样。这个节目提供了新闻和教程,其中后者是 Allan 单独录制的。他曾告诉我,这很困难,因为你不仅要打字,还要解释自己在做什么。打错字和其他意外的计算机故障意味着要么撤销更改并剪辑录音,要么完全重新开始。从一开始,节目就提供了一个反馈渠道,让听众通过电子邮件提交想法、节目内容和关于 BSD 领域的讨论,而这些反馈会在每集的结尾被读出。人们经常用这个渠道来询问关于安装或使用 BSD 的问题。有时,Allan 会提供他在 ZFS 方面的丰富知识,帮助用户在家构建 NAS 或理解一些难以理解的概念。

Kris 也分享了来自 PC-BSD 方面的视角,讲述了现代 Unix 桌面的一切。这种结合包含了我作为 BSD 用户所寻找的所有优点。因为你只需要等一周就能听到下一期 BSD Now,这意味着我的 BSD 电池(每次参加完会议后都会充电)不会很快耗尽。这种情况持续了好几年,而这简短的早期节目的描述并不能完全呈现其意义——Allan 和 Kris 还可以讲述更多那个时代的故事!

我清楚地记得,BSD Now 对我来说不再仅仅是我收听的播客,而是变成了更多东西。我们当时在 FOSDEM,并且以小组的形式去了布鲁塞尔的一个餐厅。当我们坐在一张长桌子旁等待晚餐时,Allan 提到 Kris Moore 因为生活越来越忙而打算从播客中退出。他们正在寻找一位接替的主持人。听到这个消息,我天真地问了一句,这个过程是什么样的。我有时忍不住说话,而那时我甚至没考虑过自己要接手。Allan 简单地解释了这个过程,如何每周见面一个小时进行录音,以及节目的技术后勤工作。这一切听起来都很令人兴奋,而我一直愿意在有需要时提供帮助,所以我说我愿意加入。Allan 喜欢这个想法,我们在其他渠道上继续讨论(顺便说一句,晚餐已经上桌了)。

这个变化直到 2017 年 3 月 16 日在 AsiaBSDCon 会议的一个独立房间里进行的录音时才被宣布。第 185 集的交接节目给了 Kris 一个告别的机会,也让我有机会介绍自己。这些早期的节目确实有点坎坷,但最终我掌握了它。每周练习我的英语并与时俱进地了解 BSD 领域的情况,感觉非常好。

BSD Now 最初是作为 Jupiter Broadcasting 播客网络的一部分运行的。这意味着节目之间会有一些交叉推广,因为听众很可能也会尝试该网络下的其他节目。此外,自 TechSNAP 时代以来,Allan 一直是位受欢迎的人物,这可能帮助提高了听众数量。该网络还提供了大量后勤支持,如后期制作。对他们来说,这只是另一个要剪辑并按时发布的节目,这使我们能够完全专注于录制和内容。

播客领域近年来经历了一些并购整合。2018 年秋季,Linux Academy 宣布与 Jupiter Broadcasting 合并,随后又被在线教育平台 A Cloud Guru 收购。尽管这类并购通常伴随着业务重组,我们节目仍得以在新公司旗下继续制作。主持人 Allan 与 Jupiter Broadcasting 的创始团队——包括 2008 年创立该网络的 Chris Fisher 和 Bryan Lunduke——保持着良好关系。2020 年 4 月 23 日第 347 期节目中,我们宣布将从 Jupiter Broadcasting 独立(注:Chris Fisher 于 2020 年 8 月重启了独立运营的 Jupiter Broadcasting)。这一转变如同作家选择自出版,意味着我们需要处理大量节目运营事务。所幸我们留住了 Angela Fisher 负责幕后工作,包括将成品节目发布至各大播客平台,因此仍能维持每周正常更新。我们的制作人 JT 从第 100 期左右开始参与制作。他自 2013 年起就担任《Linux Action Show》的制作人,后因 Chris Fisher 调整节目方向不再需要其协助。恰逢 Allan 正在寻找接替原制作人 TJ 的人选——鉴于 JT 曾与 Ken Moore 共同开发 Lumina 桌面环境并参与 PC-BSD 项目,Allan 便邀请他加入。由此 JT 成为我们的常驻制作人,其精湛的后期剪辑技术(每期约一小时工作量)使 Allan 和我能专注节目内容创作,无需额外耗时。虽然我们从不依赖点击量或观众导向的营销模式获取资金,但支付团队报酬仍是必要开支。长期以来,Colin Percival 的 Tarsnap 备份服务始终是我们的赞助商,其优质服务也常被我们在节目中称道。这份稳定的赞助支持着我们这个小众播客保持独立运作,我们对其持续慷慨的资助始终心怀感激。

每期节目的诞生始于两位主持人敲定录制档期。确定时间后通知制作人 JT,他会在共享文档中搭建节目提纲框架。我们通过多种渠道收集选题——科技新闻网站、论坛、个人博客、听众邮件投稿,以及那些常年产出优质内容的"老面孔":要么是专注 BSD 的垂直媒体,要么是长期深耕 BSD 报道的独立平台。

JT 会根据多重标准筛选内容:新闻时效性、突发性、篇幅长短,以及下期录制人选——最后这点尤为重要,因为某些主持人更擅长特定领域(除了我......或许我的作用就是维持平衡?),能在相关环节提供深度解读。重大时事通常作为头条,短讯则归入新闻快报或 Beastie Bits 板块。所有内容都需精心编排以适应 45 分钟时长,若某则报道篇幅过长则需剪辑。为此我们严格把控时间,仅访谈和特辑会适当延长。

当提纲草案完成并上传至不断膨胀的节目文档库后,我会补充元数据:录制日期、基于新闻标签的关键词,当然还有标题。没错,那些让你在播客客户端里看到就皱眉的奇葩标题都出自我手。节目早期曾有条不成文规定:标题必须由三个单词组成(或许是出于营销考虑——短小精悍易传播)。这种限制如同双刃剑:简洁标题不易冗长且便于记忆,但要从节目内容提炼出妙题却非易事。比如报道 NetBSD 运行巨型摩天轮的新闻,该起什么标题?"命运之轮"?"NetBSD 巨轮"?还是"旋转的 NetBSD"?我常为此绞尽脑汁(不过至今没有同事在录制前抗议或要求修改)。

当这些筹备工作就绪,我们就拥有了一份可立即录制的完整提纲。理想情况下,提纲应提前足够时间供全员预习内容,但现实往往事与愿违——有时我们不得不在录制时才首次接触某些报道。虽非最佳状态,这种"初见反应"反而能带来最真实的即时反馈。

正式录制前,我们会协商分配报道板块,确保各自能负责最擅长的内容。通常采用轮换制推进流程——这种模式既能让他人从长篇解说中稍作休整,也为后续内容预留准备时间。

录制过程中,视频连线窗口始终开启着(尽管我们身处不同空间,也非专业录音棚),这种"视觉同步"被证明至关重要:能判断对方何时结束发言,通过点头、手势甚至举起正在讨论的资料进行无声交流。请注意,我们使用的虽是统一专业设备,意外仍可能随时降临——网络中断、窗外施工、飞机轰鸣、快递员按门铃都曾导致录制中断。所幸这些状况并不频繁,后期制作能修复部分音频故障,但绝非万能。若事故严重,我们不得不局部重录甚至推翻整期内容(最坏的情况)。这对连贯性创作是巨大挑战:我们采用一气呵成的录制模式,强行插入补录片段或复现原话都会让听众察觉不自然的断裂感。

音频问题可谓家常便饭,有时甚至需听众反馈才察觉异常。可能是某方音量过低、音轨错位导致串音,或是麦克风参数莫名改变。最近我才发现,从首期沿用至今的耳机竟早已单边失灵——最初还误以为是对方音量设置问题。更换新耳机后,搭档们的声音清晰得仿佛近在耳畔。音频工程这门学问,实在是门玄学!

Allan 在创办 BSD Now 之前就深耕播客领域,我们持续保持着采访 BSD 业界人士的传统。会议现场也是绝佳的录制场所——只需把采访对象拉进安静角落即可展开对话。这类即兴采访充满刺激与未知,因为我们无法预先准备完整的采访提纲。常规访谈会预先设计问题,但会议现场的采访必须根据受访者身份临时发挥。我们始终感激这些愿意即兴受访的嘉宾,他们通过我们的平台触及更广受众,分享项目进展、招募测试人员,并讲述与 BSD 结缘的故事——这永远是 Allan 和 Kris 开场必问的经典问题。

第 103 期对 Bryan Cantrill 的访谈令我着迷。尽管当时对他一无所知,但那些 Unix 秘辛与犀利观点让我反复重温这期"常青树"内容。众多听众的强烈反响促使我们在第 117 期安排了后续访谈。这些触及行业痛点的对话,如今回望竟与 IT 领域的发展轨迹形成了奇妙呼应。

多位业界翘楚也曾慷慨受访:Michael W. Lucas 堪称"年度最频繁嘉宾",我们既追踪他书籍创作的博客动态,也总在新书发布时邀他畅谈。他的访谈为自出版行业提供了珍贵洞见,文字与语音在此形成了绝妙互补。

当主持人需要长期休假时(人生总有意外),我们会邀请客座主持。我曾与 BSDCan 创始人 Dan Langille(这只是他众多成就之一)合作过至少两期。第 404 期《BSD Now 主持人大失踪》堪称史无前例——全体常规主持被临时替换,这需要制作人 JT 提前数月筹划,而他似乎乐在其中。

某些特殊编号的节目也值得纪念:386、486 等极客数字自然要有特别安排。虽然对 666 期有些忐忑,但我已开始期待 686 期。最近我们还在讨论:999 期是否该为这趟漫长旅程画上句号?不过突破千期大关或许更有诱惑力——未来谁说得准呢?

节目排期从非易事。节假日、会议行程、突发状况时常打乱计划。如今我们总会预留一期缓冲节目,圣诞新年等假期则提前录制特别内容——虽然节日期间加班制作,但换来的是与亲友共度的珍贵时光。

随着生活日渐忙碌,Allan 需要从每周录制中抽身。我们首先调整为隔周双录模式,之后在第 400 期(注意到数字规律了吗?)迎来第三位主持人 Tom Jones。新模式下 Allan 和 Tom 每月只需参与一次录制,而我保持每两周固定出勤。Tom 带来的网络工程专长完美弥补了我的知识盲区。

颇具戏剧性的是,在轮休期间,早已是播客老手的 Allan 又创办了《2 1/2 admins》节目。若没有他当年勇敢尝试 BSD 主题播客,就不会有我们每周的精彩内容。作为创始团队最后留守的成员,他于 2023 年宣布将专注 Klara Systems 公司运营,并在 BSDCan 大会现场录制的第 512 期(数字玄学再现)公开这一决定。为确保节目延续,他推荐了资深播客人 Jason Tubnor 加入。如今 Allan 仍活跃在我们的内部制作频道,随时提供建议。制作人 JT 则全面接管了节目前后期制作及商业运营,包括建立 Patreon 赞助体系、整理历史节目库、维护网站等重任。

Jason 为节目注入了丰富的 OpenBSD/FreeBSD 实战经验,无论是系统安全、生产环境部署还是 bhyve 虚拟化,他总能提供深度解读。我尤其享受与 Tom 或 Jason 在正式录制前的闲聊环节——这些充满真知灼见的对话后来被制作成 Patreon 高级赞助者专属内容,涵盖项目进展、行业洞察、活动预告等精彩花絮。

每周稳定产出节目堪称壮举,听众反馈也令人欣慰:有人坦言追不上更新进度只能跳着听,有人发来对我们未解问题的补充解答,更有被报道的博主专程致谢。于我而言,推荐优质博客既能丰富节目内容,又能为创作者带去额外流量——这种良性循环或许能激励更多 BSD/Unix 主题的持续创作,甚至促成听众与作者间的合作契机。

多次在 BSDCan 被听众凭声认出,或是被大学里的学生提及节目,都让我倍感欣喜。虽然远未到名人级别(也未必向往),但知道有人每周期待我们的节目,那些技术问题解答确实推动了 BSD 的普及,这种价值远非收听数据所能衡量。

常有听众询问为何不恢复早期视频形式。除增加剪辑难度外(需同步口型、插入网页/视频素材),更重要的是许多通勤听众反馈 45 分钟的纯音频体验更为高效。作为折中方案,我们近期向 Patreon 赞助者开放了未剪辑原始视频源。

节目形式会否再有变革?正如 BSD 系统的独特气质,我们始终保持着灵活演进的姿态。六百多期走来,正是赞助者与听众的支持,以及广大 BSD 开发者、撰稿人的持续输出,才让这个小小播客在数字海洋中拥有专属坐标。只要这份热情不变,这里就永远是 BSD 爱好者的精神家园……

作者 BENEDICT REUSCHLING 系 FreeBSD 文档提交者,曾任核心团队成员及 FreeBSD 基金会副主席,在德国达姆施塔特应用技术大学管理大数据集群八年余,现讲授《开发者 Unix 基础》课程,并担任 bsdnow.tv 每周播客主持人。

将多个传入的数据段合并成一个较大的数据块。这对于 TCP 端点主要接收用户数据时非常有用。

绕过部分 IP 栈处理。因此,TCP LRO 需要在网络接口层截取数据包,这样它就能提高效率。

所有这些方法都专注于减少调用 TCP 栈的次数,最小化 CPU 所需的缓存未命中次数,通过将所有处理压缩到一个,一系列一起处理的数据包中。对于大多数 FreeBSD 驱动程序,使用的是单一的软件 TCP LRO 过程,尽管某些特定的硬件及其驱动程序确实支持硬件 TCP LRO。本篇文章仅讨论 FreeBSD 中的软件 TCP LRO。

TCP LRO 的初步实现由 Andrew Gallatin 完成于 2006 年,特定于 mxge(4) 驱动程序。然后,在 2008 年,Jack Vogel 将其扩展到所有驱动程序。它有两个主要目标:

收集和合并小的传入数据段,向 TCP 提供一个更大的单一传入数据段,或者

收集多个 ACK,并向 TCP 栈呈现一个更大的单个 ACK。

这两种方法的实现目的是减少 TCP 接收路径被调用的次数,从而节省 CPU 资源。它的实现非常谨慎,只处理连续的段和没有 TCP 选项的段(唯一允许的 TCP 选项是时间戳)。这个初步实现在 FreeBSD 中保留了近十年,几乎从未改动,唯一的变化是 2012 年 Bjoern A. Zeeb 增加了对 IPv6 的支持。

到了 2016 年,TCP LRO 代码开始显现老态,随着在客户端和服务器上部署的网卡越来越快,每次驱动程序中断时接收的数据包越来越多。最初的实现仅允许收集和压缩来自八个不同连接的数据。这在连接数较少的工作负载下效果很好,但对于连接数很多的工作负载来说效果较差,因为每次中断时驱动程序会从不同的连接发送更多的数据包。在每次中断时,由于来自多个连接的数据包数量激增,单个连接看到的数据包之间的间隔小到足以适应八连接限制的可能性变得越来越小,直到 TCP LRO 基本上不起作用,尤其对于服务器端来说。

这时,Hans Petter Selasky 提出了一个绝妙的主意,他为驱动程序添加了一个可选路径,在提交给 TCP LRO 之前对传入的数据包进行排序。这意味着来自每个连接的所有数据包都可以一起处理。这也就意味着,你可以在每次中断时最大化 TCP LRO 的效果。这一改变大大改善了 TCP LRO 性能,同时仍允许旧驱动程序保持不变。

随着 TCP LRO 效果的提高,这种更高效路径的其他问题也开始显现,包括:

TCP 的拥塞控制更喜欢看到每一个 ACK,因为 ACK 会推动其拥塞窗口。压缩 ACK 可能会妨碍拥塞控制算法。

现代 TCP 栈通常希望获取精确的往返时间(RTT)信息,压缩多个 ACK 会隐藏这一信息。

TCP ECN(显式拥塞通知)的实现需要查看 IP 头部的标志,以便监控和响应来自网络的 ECN 信号,压缩数据和 ACK 在一定程度上遮蔽了这些信息。

如果 TCP 栈正在进行数据包限速(我们将在后续的文章中讨论数据包限速),那么当栈被禁止发送数据包时处理一系列 ACK 会增加开销。这是因为 ACK 不能发送,但在处理过程中会导致多个缓存未命中,之后在栈可以发送数据包时必须重新处理。

这些问题促使了一项新的优化,其中 TCP 栈允许 TCP LRO 代码直接将数据包排队,以便在下一次唤醒时处理。这样,当栈可以发送数据时,所有 IP 和 TCP 头部的数据就能在同一时间进行处理,并且揭示了所有 TCP 想要看到的信息(包括由于接收时间戳的添加,无论是在硬件上由网卡完成,还是在软件中由 TCP LRO 代码完成)。

这种新的排队机制运行良好,但在一系列 ACK 到达时,也引起了额外的缓存未命中。这是因为每个排队等待处理的数据包都会在处理时导致缓存未命中。在旧的压缩方案中,虽然会丢失一些信息,但由于只有一个缓存未命中会发生在多个到达的 ACK 中,因此进行了更优的优化。

这促使了另一项 TCP LRO 优化。当连续的 ACK 到达时,TCP LRO 代码现在可以将它们压缩成一个特殊的数据包,该数据包包含到达数据包信息的数组。这种压缩技术允许将所有以前丢失的数据(包括到达时间)以数组结构的形式呈现给 TCP 栈,从而只需要一次缓存未命中来访问这个特殊的数据包。需要注意的是,TCP 栈必须通知 TCP LRO 代码,表明它支持这种特殊类型的处理。

最后一组 TCP LRO 的优化与传入 IP 数据包的处理方式有关。最初,只支持包含使用 IPv4、IPv6 协议的 TCP 段的以太网帧。为了支持其他封装的 TCP 段,例如 VXLAN,它使得能够将以太网帧封装到 UDP 数据包中,数据包解析已经被扩展,以支持内层和外层头部。通过这种方式,具有 UDP 作为外层头部和 TCP 作为内层头部的数据包可以通过 TCP LRO 进行处理。假设网卡能够为这两种协议执行校验和卸载。

如果网卡驱动程序支持 TCP LRO,它可以通过 ifconfig 命令的参数 lro 和 -lro 启用、禁用之。

网卡驱动程序必须包含结构体 struct lro_ctrl,除了其他字段外,还包含指向以下内容的指针:

一组包含指向 struct mbuf 和序列号的指针的数组。这些对的数量由 lro_mbuf_max 指定。

一组 struct lro_entry。这些条目的数量由 lro_cnt 指定。

struct lro_entry 用于存储一个聚合的已接收 TCP 段集的信息。如果该条目未使用,它会包含在 lro_free 列表中。当它被使用时,它会包含在 lro_active 列表中,并且也可以通过哈希表 lro_hash 访问。

这两个列表和哈希表也包含在 struct lro_ctrl 中。

网卡驱动程序初始化 TCP LRO 特定数据的方式有两种。传统的方式是调用函数 tcp_lro_init()。应分配的 struct lro_entry 数量由加载器可调参数 net.inet.tcp.lro.entries 指定。在使用传统初始化方式时,数组中的对数没有条目。现代方式是使用函数 tcp_lro_init_args(),它允许调用者指定 lro_cnt 和 lro_mbuf_max。这意味着数组对也可能被分配。

无论使用哪种方式初始化 struct lro_ctrl,调用函数 tcp_lro_free() 都将释放所有已分配的资源。

网卡驱动程序有传统和现代两种方式将 TCP 段传递给 TCP LRO。如果将 TCP 段传递给 TCP LRO 失败,网卡驱动程序必须继续正常处理该 TCP 段。TCP LRO 失败的一个原因是如果网卡无法验证接收到的 IP 数据包的校验和。

使用传统方式将 TCP 段传递给 TCP LRO 时,网卡驱动程序会调用 tcp_lro_rx()。基本上,这会启动由 tcp_lro_rx_common() 完成处理,后者将在下一小节中介绍。将 TCP 段传给 TCP LRO 的现代方式(也要求使用现代初始化方式)是调用 tcp_lro_queue_mbuf()。这个函数仅为 TCP 段计算一个序列号,并将其与 TCP 段一起存储在数组中的下一个空闲条目中。如果通过此操作数组已满,则会调用 tcp_lro_flush_all(),这将在下一小节中说明。

无论使用传统方式还是现代方式将 TCP 段传递给 TCP LRO,若网卡未提供硬件接收时间,传递给 TCP LRO 的时间将被保存。

当使用现代方式将 TCP 段传递给 TCP LRO 时,会执行一个额外的初始步骤。tcp_lro_flush_all() 会根据序列号字段对数组中的所有条目进行排序。这使得同一 TCP 连接的所有 TCP 段很可能会在数组中按接收顺序排列。然后,调用 tcp_lro_rx_common() 处理数组中的所有条目。从此时起,无论是使用传统方式还是现代方式传递 TCP 段到 TCP LRO,TCP 段的处理方式都是一样的。

tcp_lro_rx_common() 会解析 TCP 段,并利用该信息查找哈希表中相应的 struct lro_entry 条目。如果找到了该条目,TCP 段将被添加到 TCP 段的数据包链中。如未找到条目,则会创建一个新的条目,并将 TCP 段添加到该条目中。需要注意的是,当 TCP LRO 代码没有空闲条目时,会 flush 一个较旧的条目,这样就释放了该结构,供新分配使用。

网卡驱动程序和 TCP LRO 代码本身都可以触发 flush 操作,这将导致处理 struct lro_entry 条目中的信息,使其适合由 TCP 栈处理,如下一小节所述。

如果使用类似 TCP RACK 和 TCP BBR 的替代 TCP 栈,则会使用高精度定时器系统(HPTS)。如果仅使用 FreeBSD 基础 TCP 栈,则不会使用此系统。

如果 FreeBSD 内核中没有加载 HPTS,当触发 flush 操作时,发生的情况是:TCP LRO 将合并一个 struct lro_entry 条目的数据包链,将所有单个 TCP 段的用户数据连接成一个大的 TCP 段。当然,这只有在没有间隙和重叠的情况下才有效。如果发生间隙和重叠,TCP LRO 可能只能合并较小的部分。ACK 数据的信息也会被合并,生成的这个大 TCP 段将被注入到接口层。这将减少需要处理的数据包数量,但也会导致丧失关于每个 TCP 段接收时间的信息,以及任何 IP 层 ECN 标志。根据拥塞控制和丢包恢复的情况,这可能会带来负面影响。

如果加载了 HPTS 系统,flush 操作会触发查找 TCP 端点。这些信息用于确定 TCP 端点所使用的 TCP 栈是否支持 mbuf 队列。若不支持,则会执行与 FreeBSD 基础栈相同的处理。如果 TCP 栈支持 mbuf 队列,但不支持压缩 ACK,则条目的数据包链会被复制到 TCP 端点,并且可能会触发 TCP 端点处理该数据包链。这就是 TCP BBR 栈使用时的处理方式,它支持 mbuf 队列但不支持压缩 ACK。如果使用的是 TCP RACK 栈,它也支持压缩 ACK,可以将多个已连续接收的 ACK 存储在一个特殊的数据结构中,从而以更节省内存的方式传递它们。请注意,当使用 mbuf 队列和压缩 ACK 时,单个数据包接收时的信息会被保留并传递到 TCP 端点。

TCP 的精确 ECN(显式拥塞通知)目前是由互联网工程任务组(IETF)指定的一项 TCP 特性,FreeBSD 正在开发对此的支持。除了使用两个新的 TCP 选项外,它还改变了两个现有 TCP 标志的使用,并使用了一个额外的标志。这需要对 TCP LRO 代码进行修改,以便仍然能够对支持精确 ECN 的 TCP 连接聚合传入的 TCP 段。

可以改进对 VXLAN 的支持,使其能够利用 mbuf 排队机制。

RANDALL STEWART([email protected])是一位拥有 40 年操作系统开发经验的开发者,自 2006 年起成为 FreeBSD 开发者。他专注于传输协议,包括 TCP 和 SCTP,但也涉猎操作系统的其他领域。目前,他是一名独立顾问。

MICHAEL TüXEN([email protected])是明斯特应用技术大学的教授,也是 Netflix 的兼职承包商,自 2009 年起成为 FreeBSD 源代码提交者。他的研究重点是传输协议,如 SCTP 和 TCP,它们在 IETF 的标准化过程以及在 FreeBSD 中的实现。

软件项目常常让人觉得就是由 Bug 堆砌而成;开发者会说一切都是鞋油和胶带粘起来的。造成最大麻烦的问题往往最难捉摸。“深夜,当 12 个并发请求同时打到我们的测地负载均衡器上时……”并不是复杂 Bug 的罕见开头。有时问题的描述甚至是“运行 1000 小时之后……”这种令人头疼的情况。

幸运的是,并非所有 Bug 都如此。FreeBSD 在许多情况下会 panic,对用户而言可能是糟糕的一天,但对开发者而言,panic 消息可能是定位问题的重要线索。和无声的数据损坏相比,我宁愿碰到 panic。

有些 Bug 只是表面问题,比如字段显示不佳,或文档不清晰(是的,我们也认为这算 Bug!)。

无论你的 Bug 是逻辑上的不可能,还是一个拼写错误,我会给你展示一个框架,帮助你推动修复。

在介绍如何写好 Bug 报告之前,先说说之后会发生什么,因为这能解释为什么你需要在最初报告时尽可能多提供信息。

在 FreeBSD 中,大多数 Bug 会通过邮件列表或 Bug 跟踪系统(bugs.freebsd.org)传播。开发者会定期阅读邮件列表,但最能引起关注的方法还是在 Bug 跟踪系统上提交工单。

新创建的 Bug 会被标记为“new”,处于新 Bug 状态。这时它只是被用户提交,还没有通知到具体的项目领域。

Bugmeister 团队会检查新提交,将其从“new”状态重新分配,并尽量设置正确的分类。开发者可以选择订阅某些类别的 Bug。相关的项目邮件列表也会收到新 Bug 的通知。另外,还会定期发送“该组关注的 Bug”摘要邮件。

Bug 可能会被 Bugmeister 或其他 FreeBSD 项目成员分配给某个开发者。

某个开发者可能决定“接手”一个 Bug,成为该问题的负责人。这通常意味着他决定修复这个 Bug 或分析它。

随后可能会有一些往返沟通,开发者会要求更多信息;如果一切顺利,开发者最终会创建代码审查(在 reviews.freebsd.org 上)。代码审查可能会在 Bug 中引用,也可能只是开发者向熟悉该子系统的同行寻求反馈。

如果需要测试以确认 Bug 是否解决,这会被特别指出。

最终,待代码审查与测试完成,修复就会被提交到 FreeBSD;提交消息通常会包含 Bug 的引用,并附加自动更新。有时修复一个 Bug 需要多个补丁。

修复提交后,你(用户)就能再次无 Bug 使用软件,前提是你运行的是 CURRENT 快照。许多修复会从 CURRENT 合并到 STABLE 分支(称为 MFC)。如果 Bug 被 MFC,修复就会出现在 STABLE 分支,并包含在下一个点版本中。

从报告问题到修复的过程可能很长;有的问题 20 分钟就能解决,有的问题可能需要数月甚至数年。我见过调试超过十年才关闭的 Bug。

解决一个问题所需的时间,很大程度上取决于你报告的时机。如果你在提交刚落地后就发现 Bug,很可能当天就能修复。其他 Bug 可能更晚才出现,或只出现在某些 FreeBSD 发行版本的环境中。

修复这些 Bug 的速度,主要取决于 Bug 报告的质量以及围绕问题的持续讨论。接下来我们看看一个好的 Bug 报告该包含什么。

FreeBSD 项目建议用户通过多种渠道分享使用体验。按优先顺序,新 Bug 或有趣 Bug 的报告渠道如下:

在 reviews.freebsd.org 上提交带有清晰测试的易于应用的变更

在 reviews.freebsd.org 上提交临时修补的解决方案

在 bugs.freebsd.org 上提交新的 Bug

直接给开发者发邮件(或其他形式的沟通)

在论坛上抱怨并推测原因

在 IRC、Matrix、Discord 或其他聊天渠道留言

在社交媒体上愤怒发帖,说 FreeBSD 是最差的

前两种方式假定了较高的技术水平。如果这对你来说太难,也没关系,我们依然欢迎 Bug 报告。

我们不要求每个人都能做高级开发,只希望每位报告者在每一步尽可能提供相关细节。

关于你环境的详细信息

你期望发生什么

实际发生了什么

期望与实际的差异

触发 Bug 的前因后果

时间因素(重启后立刻出现?还是运行 5 天后才出现?)

系统运行时会生成很多有助于调试的信息,你可能会被要求提供日志,例如:

dmesg 的输出

panic 消息的完整文本和堆栈跟踪

硬件问题时 pciconf -lv 的输出

syslog 输出

工具输出和错误信息

提供的资料宁多勿少;如果开发者不得不再来问你一次,可能会耽误至少一周。

报告时要清楚说明 FreeBSD 的版本,以及涉及多少主机。Bug 出现在 14 台和 15 台之间的差异,往往比只知道“14 台”更有意义。

说明是否有自定义,是否是自己编译的 FreeBSD,还是使用软件包。你是不是在用下游发行版,比如 pfSense 或 HardenedBSD?这不会让 FreeBSD 开发者拒绝帮助,但如果你隐瞒这一点,可能会惹恼他们。

清晰地说明你期望发生什么,以及实际发生了什么。并明确指出差异。

描述清楚“做了 X 之后无法再做 Y”。这类报告对开发者尤其有价值。

尽量以文本形式提供信息。错误消息要全部包含。如果系统 panic,实在没法复制,可以拍照,但最好同时抄录文字。Bug 跟踪系统里的文字记录可以保存几十年,图片链接往往会失效。

一个好的 Bug 报告会包含复现步骤。简单问题可能只需要一个命令;复杂问题可能需要脚本配合。

复现的目标是尽量简化,缩减到最小必要条件。

提交 Bug 后,这可能已经足以让开发者感兴趣。如果你能在提交后的 20 分钟内指出一个回归或新 Bug,很可能立刻引起开发者关注。

Bug 被分配到团队需要时间,这是正常现象。你也可以主动联系相关领域的开发者,但要保持礼貌。

开发者接手 Bug 后,可能会问你问题;时间久了,可能会问:“在最新快照上还会出现吗?”

他们可能会请你提供更多信息或测试补丁。某些只出现在特定硬件上的 Bug,如果没人验证,补丁可能会长时间搁置。

撰写并提交 Bug 报告是一件耗费精力的事,有时你会觉得自己的努力无人理睬。但 FreeBSD 是一项志愿者项目,开发者根据兴趣分配时间。我们拥有一群优秀的开发者,他们愿意追踪复杂而隐蔽的问题,但他们需要你的帮助与合作,收集足够的信息来复现和测试。

如果你遵循这里的建议,你会更顺利地让 Bug 获得关注,并推动它们被修复。

Tom Jones,FreeBSD 提交者,对保持网络栈高性能充满兴趣。

作者:PAWEL DAWIDEK

译者:ykla【】为译者注

ZFS 文件系统进入 FreeBSD 操作系统的故事是一段对编程的热情、对技术的热爱,以及是一个引导我做出最有价值贡献于 FreeBSD 项目的旅程。那是在 2005 年的夏天。虽然我不太擅长记日期,但我还记得我第一次接触 ZFS 的情境:当时我和朋友们在波兰的马祖里地区,这里有 2000 多个美丽的湖泊。我的其中一位朋友当时在波兰的一个电信公司工作,他们使用了大量来自 Sun Microsystems 的硬件和 Solaris 操作系统。他带来了一份 Sun 发来的通知的打印副本,其中描述了一个新的文件系统,它经过了一段时间的开发,即将作为 OpenSolaris 的一部分发布。但在继续讲述这个故事之前,让我们回到过去,来了解一些背景信息...

我对编程一见钟情。那时我 12 岁,我的表亲向我介绍了 C-64 上的 BASIC 编程语言。

爱情初见!

我对编程一见钟情。那时我 12 岁,我的表弟 Tomek 向我介绍了 C-64 上的 BASIC 编程语言。我被迷住了。我感觉自己像一个年轻的上帝:你拿起这个无生命的硬件,创建一个程序,然后看着它活了起来!这太酷了;我无法想象还有什么比这更棒的事情了。因此,我从未对电子游戏感兴趣。那时,我在波兰一个小镇长大,并不容易找到对编程感兴趣的人,所以我基本上是独自一人(除非是在测试 Tomek 的耐心极限)。

当我转向 Amiga 500【即 Amiga 家用电脑的第一款低端版本】后,我终于找到了一些来自演示场景的朋友,我们通过邮件用 3.5 英寸软盘交换我的作品。等待并不是一件好事,但我没有抱怨。当我的下一台计算机——Amiga 1200 开始显得老旧时,很明显是时候继续前进了。我知道微软的 Windows 不适合我。我尝试过 Linux,但还不是很满意。最后,一个朋友向我介绍了 FreeBSD。他的安装非常简单,我再也不能要求比这更好的体验了。哈!如果你对最后一句话没有感到不安,那么显然你还没有享受过使用 sysinstall【现在为 bsdinstall】的“乐趣”。不,安装并不是一件轻松的事情——我尝试了多次才终于享受到了我的第一个 FreeBSD 系统。我认为 sysinstall 一定就像海军海豹突击队的地狱周那样,让强者从弱者中分离出来,使真正的黑客在那里锻造!而我成功了!我设定了下一个目标和梦想,不仅要成为一个能够安装 FreeBSD 的黑客,还要成为一个内核黑客和 FreeBSD 的贡献者。

在 2003 年,我正式加入 FreeBSD 项目,成为了 src 提交者,实现了自己的目标。是的,我为此举办了派对来庆祝。自从我加入以来,我在系统的许多领域工作过,但主要是与 GEOM 框架相关。在 FreeBSD 中,GEOM 框架位于磁盘驱动程序和文件系统之间,允许插件实现各种转换,比如镜像、RAID、块级加密等。我真的很喜欢 GEOM 的设计,并且喜欢与之一起工作,所以我在存储栈的至少这一部分有相当的经验。至于文件系统,我知道必须远离 VFS,因为它是内核中最复杂的部分之一。

可悲的是,UFS 自 FreeBSD 成立以来就一直是默认文件系统。实际上,UFS 比 FreeBSD 本身还要古老。UFS2 在 FreeBSD 5.0 中被引入,解决了 UFS1 的一些问题,但仍然存在一些重要的问题没有解决。主要问题是在系统崩溃或停电后进行 fsck 所需的时间。随着磁盘越来越大,fsck 可能需要花费几个小时才能完成。解决这个问题的方法显而易见——我们需要将日志记录添加到 UFS 中,或者将其他带有日志记录功能的文件系统移植到 FreeBSD。说起来容易做起来难。在 Linux 中,有很多文件系统可供选择,很多人试图将它们移植到 FreeBSD,但出于某种奇怪的原因,这些移植从未完成,因此我们最终得到了没有日志记录功能的 extfs,只读的 ReiserFS 和只读的 XFS。甚至还有一个来自 Mac OS X 的可读写的 HFS+ 移植,但是,当然,没有日志记录功能,并且我还记得至少有一次试图给 UFS 添加日志记录的失败尝试。这是怎么回事?UNIX 之神是否背弃了我们?

让我们回到我在马祖里亚的度假时刻。我的朋友开始阅读 ZFS 的公告,而我的眼睛和嘴巴越张越大:池化存储——你可以创建任意多的文件系统,它们将共享可用空间。无限快照,创建起来不费时间。无限克隆。内建压缩。端到端数据验证。自动修复受损数据。事务性写时复制模型——始终保持一致——永远不需要进行 fsck(文件系统检查)。这是怎么回事?这怎么可能?这不仅仅是改进,而是文件系统的彻底革命。我记得我曾梦想过这个完美的结合:最好的文件系统运行在最好的操作系统上……那将会是多么令人惊奇啊?

几个月后,ZFS 正式发布了,它不仅在开源社区中引起轰动,而且在整个存储行业都掀起了风暴。有些人讨厌它,大多数人喜欢它,还有一些人害怕它,但没有人忽视它。有人称它为文件系统的终极之选,有人称它为狂热的分层违规【"狂热的分层违规"是对 ZFS 的一种负面评价,意指在设计中使用了过多的分层或复杂的架构。通常情况下,过多的分层和复杂的设计会增加代码的复杂性和难以理解性,可能导致维护和调试变得困难。在软件开发中,应该尽量保持简洁和清晰的设计,避免过多的分层和复杂性,以提高代码的可维护性和可读性。】。然而,它从未被称为又一个普通的文件系统。几乎每个操作系统都想要 ZFS:Linux 用户空间 port 在 FUSE 下启动,DragonFlyBSD【该系统至今仍未支持 ZFS】宣布即将移植 ZFS,而苹果也开始将 ZFS 移植到 Mac OS X。ZFS 很快将无处不在,只是不在我们所钟爱的 FreeBSD 中...

为了撰写这篇文章,我不得不分析很多当时的 IRC 日志。让我印象最深的是关于 ZFS 本身有多少怀疑态度:太复杂了,层次太多了,只是个样子货,设计缺陷很快就会被发现,等着瞧第一个灾难故事的发生吧,它永远不会被移植到社区开发的操作系统,这只是炒作,太可笑了。我想人们习惯了一个道理,如果某事看起来太美好了,往往就是真的太美好了【即太好的东西常常是假的】。幸运的是,爱是盲目的,我当时并没有注意到这一点。

在 ZFS 发布后等待了 10 个月,我却没有看到有人开始工作,于是我想我不妨一试。虽然我对 VFS 层几乎一无所知,很可能很快就会失败,但谁能阻止我尝试呢?至少,我能学到一些新东西。我的移植工作始于 2006 年 8 月 12 日。为了不让人们抱太高的希望,我创建的 perforce【软件存储库】分支的描述是“This is not a ZFS port!”(这不是 ZFS 的移植!)。我最初的估计是用六个月的时间完成一个只读的原型。

我必须承认,虽然 ZFS 不是我创建的,但在 ZFS 上的工作是我职业生涯中最吸引人的项目。我喜欢努力工作,我喜欢工作到很晚。我喜欢全神贯注于项目,而且我有幸参与了许多令人惊叹的项目。多年来,我是 FreeBSD 中最有成效的提交者之一,同时还在发展自己的业务。但没有其他项目能让我连续工作 48 个小时,几乎没有休息,只在这 48 个小时之间短暂地打个盹。我现在告诉你的事情听起来可能对我来说都有些不可思议,但它确实发生过,我向你保证 :)

在处理大型项目时,我仍然希望尽快运行某些内容,然后逐步实现缺失的部分。第一步是移植用户空间组件,如 libzpool、ztest 和 zdb。这基本上还好。下一个挑战是编译和加载 ZFS 内核模块。当你尝试加载一个带有缺失符号的内核模块时,FreeBSD 内核链接器会报告第一个缺失的符号并返回错误。我有太多的缺失符号,以至于我不得不修改链接器以一次报告它们所有的错误。对它们的逐个修复花费了太多时间。五天后,我第一次加载了 zfs.ko。理论上,FreeBSD 内核和 ZFS 代码之间有四个主要的接触点:

在堆栈的底部,我们需要教会 ZFS 如何与 FreeBSD 的块设备通信,这意味着将 ZFS 连接到 GEOM(在 GEOM 术语中是创建一个仅消费的 GEOM 类)。由于我对 GEOM 有经验,这个部分很简单。

在堆栈的顶部,我们需要将 ZFS 连接到 FreeBSD 的 VFS,因此需要移植 ZPL 层。

同样,在堆栈的顶部,ZFS 存储可以通过 ZVOL 访问,因为 ZVOLs 是块设备,所以这还涉及到 GEOM,但这次是提供者 -only 的 GEOM 类。

最后一个组件是 /dev/zfs 设备,它由用户空间的 ZFS 工具(zfs(8) 和 zpool(8))与 ZFS 内核模块进行通信。

将 ZPL 层移植并将 ZFS 连接到 FreeBSD 的 VFS 当然是最困难的部分。在 FreeBSD 上的第一次内核挂载发生在 2006 年 8 月 19 日,也就是一个星期后。经过十昼夜的工作,我已经准备好了一个读写原型。我可以创建池、创建文件系统并挂载它们,创建行为非常稳定的 ZVOL,创建文件和目录,列出它们,以及更改权限和所有权。我最初估计的六个月的只读原型时间表明,“有点”偏离了。尽管还有大量工作要做,但来自社区的鼓励给了我继续和完成项目所需的动力。在 2007 年,ZFS 在 FreeBSD 7.0 中以实验状态正式发布,在 FreeBSD 8.0(2009 年)中宣布为生产就绪状态。

在我工作之前宣布的其他移植都没有实现,所以我猜要打破诅咒,你只需要努力工作足够就行 :)